S,TABLE,V2V: Устойчивость формы при редактировании видео

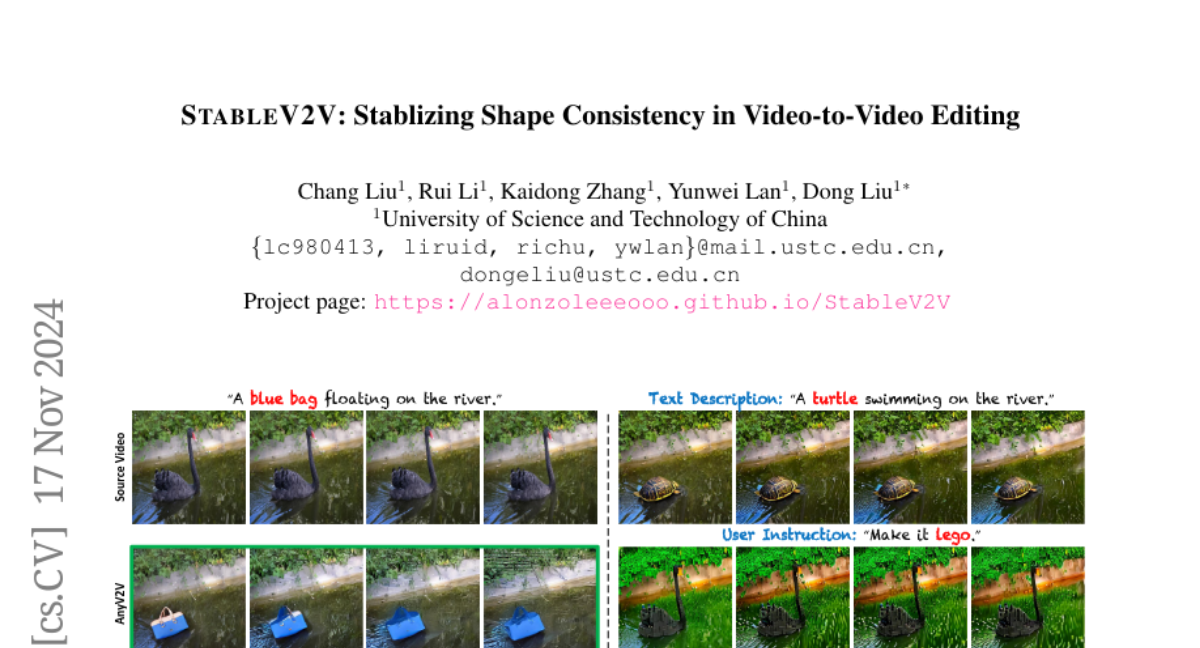

В последние годы технологии генеративного искусственного интеллекта (AI) значительно продвинулись вперед, что привело к улучшению инструментов для создания и редактирования контента. Одной из областей, где это особенно заметно, является редактирование видео. В этом контексте, новые методы стремятся не только изменять содержимое видео, но и сохранять его временную консистентность и соответствие заданным пользователем критериям. В данной статье мы рассмотрим новый метод под названием S,TABLE,V2V (Stabilizing Shape Consistency in Video-to-Video Editing), который предлагает инновационный подход к решению проблемы несоответствия формы при редактировании видео.

Редактирование видео — это процесс изменения исходного видеоконтента в соответствии с требованиями пользователя. С появлением и развитием моделей диффузии, таких как LLM (Latent Diffusion Models), стало возможным взаимодействие с различными внешними запросами, включая текст, инструкции, изображения и эскизы. Эти технологии позволяют не только менять визуальные элементы видео, но и адаптировать их к новым контекстам, сохраняя при этом исходные движения объектов.

Категории методов редактирования видео

Существующие методы редактирования видео можно разделить на несколько категорий:

-

Методы инверсии DDIM - используют инверсию DDIM (Denoising Diffusion Implicit Models) для хранения шаблонов движения видео в виде латентных признаков, которые затем инжектируются в модели диффузии при редактировании.

-

Методы однократной настройки - настраивают веса модели для каждого видео, чтобы точно воспроизвести его движения.

-

Методы обучения - обучают модели на больших наборах данных, чтобы обеспечить общее решение для редактирования видео, но часто требуют масок для точного определения областей редактирования.

-

Методы на основе первого кадра - редактируют первый кадр видео и затем распространяют изменения на остальные кадры, используя исходные движения.

S,TABLE,V2V: Описание метода

S,TABLE,V2V представляет собой метод, который разделяет процесс редактирования видео на несколько последовательных шагов:

1. Редактор первого кадра с подсказками (PFE)

На первом этапе S,TABLE,V2V редактирует первый кадр видео, используя различные типы внешних подсказок. Это может быть текст, инструкции, эталонные изображения или эскизы. Для этого используются существующие редакторы изображений, такие как SD Inpaint и InstructPix2Pix для текстовых запросов, или Paint-by-Example для изображений.

2. Итеративный выравниватель формы (ISA)

После редактирования первого кадра, S,TABLE,V2V использует ISA для установления соответствия между движениями в исходном видео и измененным содержимым. ISA предполагает, что измененные и исходные объекты имеют одинаковые движения и глубину. Этот процесс включает в себя:

- Симуляцию движений с использованием оптических потоков.

- Симуляцию глубины для создания глубинных карт, которые служат промежуточным звеном для передачи движений.

- Уточнение глубины с помощью сети уточнения глубины, направляемой формой, чтобы обеспечить точность глубинных карт.

3. Условный генератор изображения в видео (CIG)

CIG использует отредактированный первый кадр и уточненные глубинные карты для создания полного отредактированного видео. Здесь используется модель Ctrl-Adapter для инъекции глубинных карт и модель I2VGen-XL для распространения изменений на все кадры видео.

Эксперименты и результаты

Для оценки S,TABLE,V2V был создан тестовый бенчмарк DAVIS-Edit, который включает различные типы запросов и сложности редактирования. Эксперименты показали, что S,TABLE,V2V превосходит существующие методы по нескольким ключевым показателям:

- Визуальное качество - улучшенная детализация и консистентность текстур.

- Временная консистентность - сохранение движений объектов в соответствии с исходным видео.

- Соответствие запросам - более точное следование заданным пользователем критериям.

- Эффективность - быстрое выполнение процесса редактирования.

Применение и ограничения

S,TABLE,V2V демонстрирует широкие возможности для применения, включая изменение объектов в видео, стилизацию видео и даже инпейнтинг (заполнение отсутствующих частей видео). Однако метод имеет и ограничения:

- Внутренние проблемы предобученных моделей - случайные изменения в текстовых редакторах могут привести к нежелательным результатам, а ограниченная разнообразность данных обучения может вызвать небольшие расхождения в цвете.

- Сложные паттерны движения - метод может испытывать трудности при обработке видео с очень сложными или необычными движениями.

Заключение

S,TABLE,V2V предлагает новый подход к редактированию видео, который обеспечивает высокую консистентность формы и движения. Хотя метод имеет свои ограничения, он открывает новые горизонты для исследований в области генеративного AI и редактирования видео, предлагая инструменты для более точного и эффективного создания контента.