Мультимодальная генерация музыки с явными мостами и дополнением извлечения

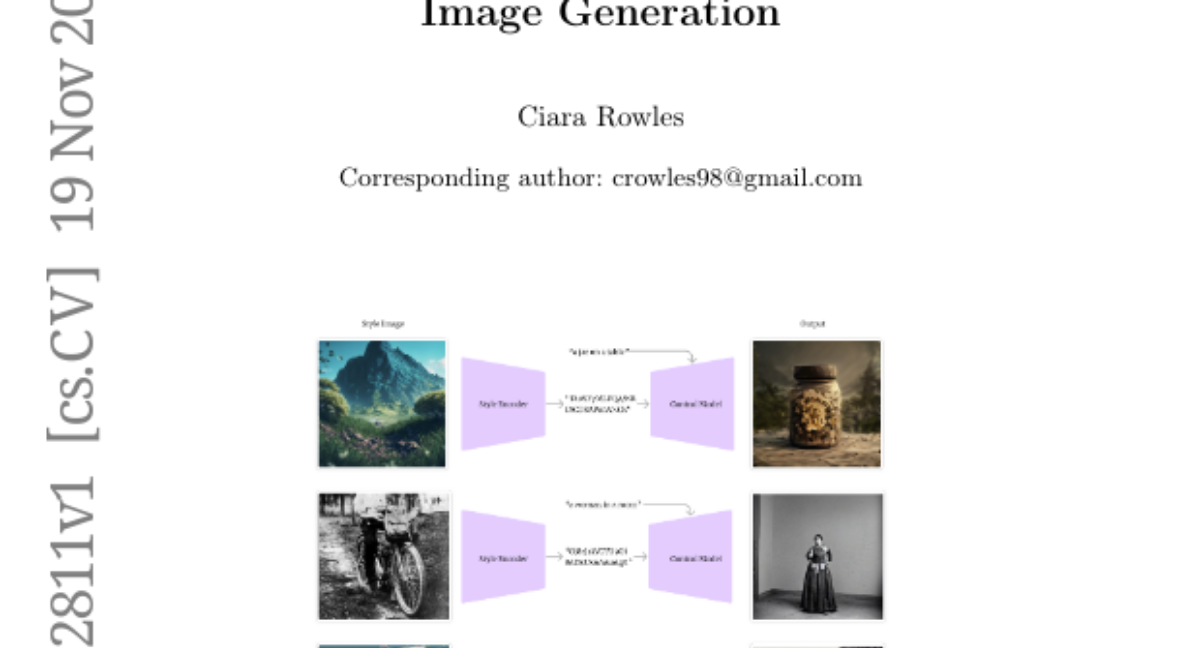

Мультимодальная генерация музыки направлена на создание музыки на основе различных входных модальностей, включая текст, видео и изображения. Существующие методы используют общее пространство встраивания для мультимодального слияния. Несмотря на их эффективность в других модальностях, применение этих методов в мультимодальной генерации музыки сталкивается с проблемами нехватки данных, слабой кросс-модальной синхронизации и ограниченной управляемости. В данной работе рассматриваются эти проблемы с помощью явных мостов между текстом и музыкой для мультимодального выравнивания. Мы представляем новый метод, названный Мост Музыки и Визуальных Образов (VMB). В частности, Модель Мультимодального Описания Музыки преобразует визуальные входные данные в подробные текстовые описания, чтобы создать текстовый мост; Модуль Двухпоточной Поиска Музыки сочетает широкие и целевые стратегии поиска, чтобы создать музыкальный мост и обеспечить пользовательское управление. Наконец, мы разрабатываем структуру Явно Условной Генерации Музыки для генерации музыки на основе двух мостов. Мы проводим эксперименты по задачам генерации музыки из видео, изображений, текста и контролируемой генерации музыки, а также эксперименты на управляемостью. Результаты показывают, что VMB значительно улучшает качество музыки, модальность и соответствие настройки по сравнению с предыдущими методами. VMB устанавливает новый стандарт для интерпретируемой и выразительной мультимодальной генерации музыки с приложениями в различных мультимедийных областях. Демонстрации и код доступны по адресу https://github.com/wbs2788/VMB.