SUGAR: Нулевая настройка видео на основе субъекта

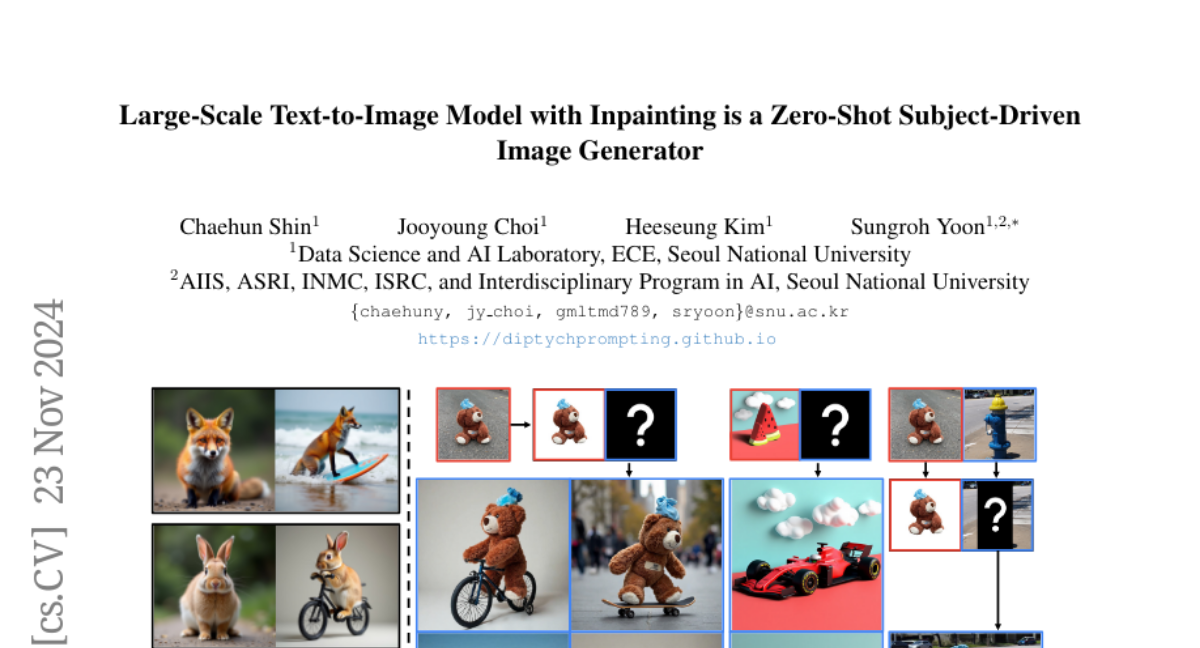

Мы представляем SUGAR, метод нулевого выбора для настройки видео, основанный на субъекте. Учитывая входное изображение, SUGAR способен генерировать видео для субъекта, содержащегося на изображении, и согласовывать генерацию с произвольными визуальными атрибутами, такими как стиль и движение, указанными текстом, вводимым пользователем. В отличие от предыдущих методов, которые требуют тонкой настройки во время тестирования или не могут генерировать видео, согласованное с текстом, SUGAR достигает превосходных результатов без необходимости в дополнительных затратах во время тестирования. Чтобы обеспечить возможность нулевого выбора, мы вводим масштабируемую систему для построения синтетического набора данных, специально разработанного для настройки, основанной на субъектах, что приводит к созданию 2,5 миллионов тройок изображение-видео-текст. Кроме того, мы предлагаем несколько методов для улучшения нашей модели, включая специальные конструкции внимания, улучшенные стратегии обучения и усовершенствованный алгоритм выборки. Проведено множество экспериментов. По сравнению с предыдущими методами SUGAR достигает передовых результатов в сохранении идентичности, динамике видео и согласовании видео с текстом для настройки видео, основанной на субъекте, демонстрируя эффективность нашего предложенного метода.