Генерация видео с сохранением идентичности на основе текстовых описаний с использованием частотной декомпозиции

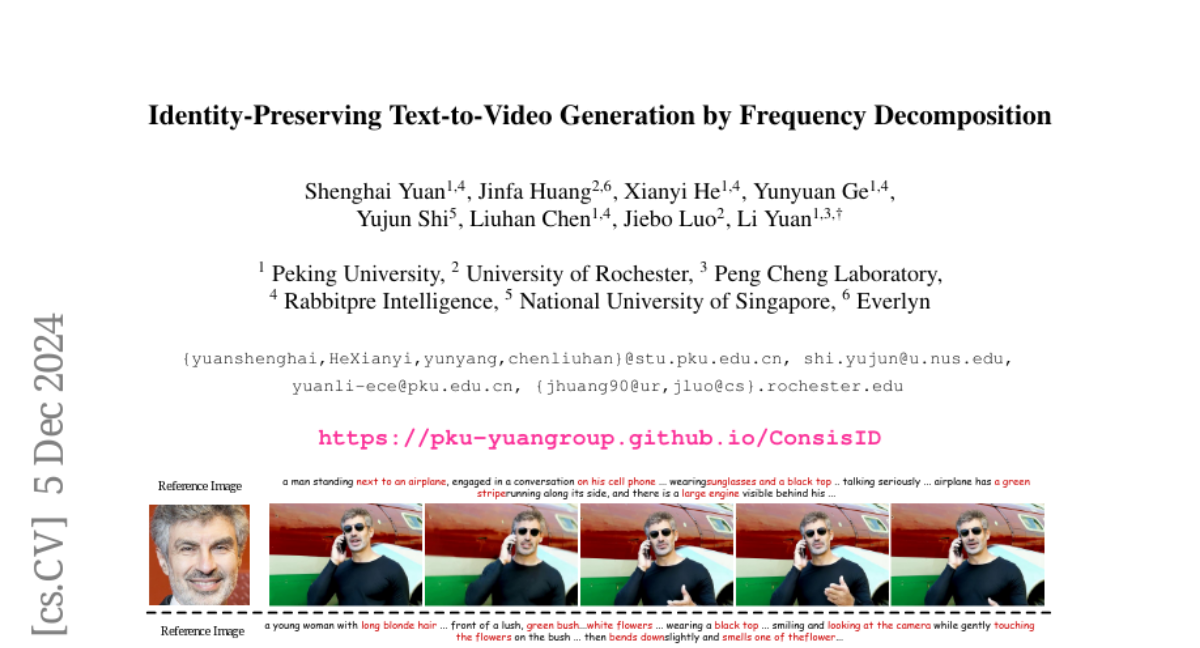

Создание видео с сохранением идентичности (IPT2V) стремится создавать высококачественные видео с последовательной человеческой идентичностью. Это важная задача в генерации видео, но она остается нерешенной проблемой для генеративных моделей. Эта статья продвигает техническую грань IPT2V в двух направлениях, которые не были разрешены в литературе: (1) Конвейер без настройки, без утомительной настройки случая за случаем, и (2) Эвристическая схема управления на основе DiT с учетом частот, сохраняющая идентичность. Мы предлагаем ConsisID, контролируемую модель IPT2V на основе DiT без настройки, чтобы сохранить человеческую идентичность последовательной в созданном видео. Вдохновленные предыдущими находками в частотном анализе диффузионных трансформеров, мы используем сигналы управления идентичностью в частотной области, где черты лица могут быть разложены на глобальные черты с низкой частотой и внутренние черты с высокой частотой. Во-первых, с точки зрения низкой частоты, мы вводим глобальный экстрактор лица, который кодирует эталонные изображения и ключевые точки лица в латентном пространстве, создавая признаки, обогащенные информацией с низкой частотой. Эти признаки затем интегрируются в поверхностные слои сети, чтобы облегчить трудности обучения, связанные с DiT. Во-вторых, с точки зрения высокой частоты, мы разрабатываем локальный экстрактор лица, чтобы уловить детали с высокой частотой и внедрить их в блоки трансформеров, улучшая способность модели сохранять тонкие признаки. Мы предлагаем иерархическую стратегию обучения, чтобы использовать информацию о частоте для сохранения идентичности, трансформируя обычную предобученную модель генерации видео в модель IPT2V. Обширные эксперименты показывают, что наша эвристическая схема с учетом частот предоставляет оптимальное решение для контроля моделей на основе DiT. Благодаря этой схеме наш ConsisID генерирует высококачественные видео с сохранением идентичности, делая шаги к более эффективному IPT2V.