MindtheTime: Управление временем в многособытийной генерации видео

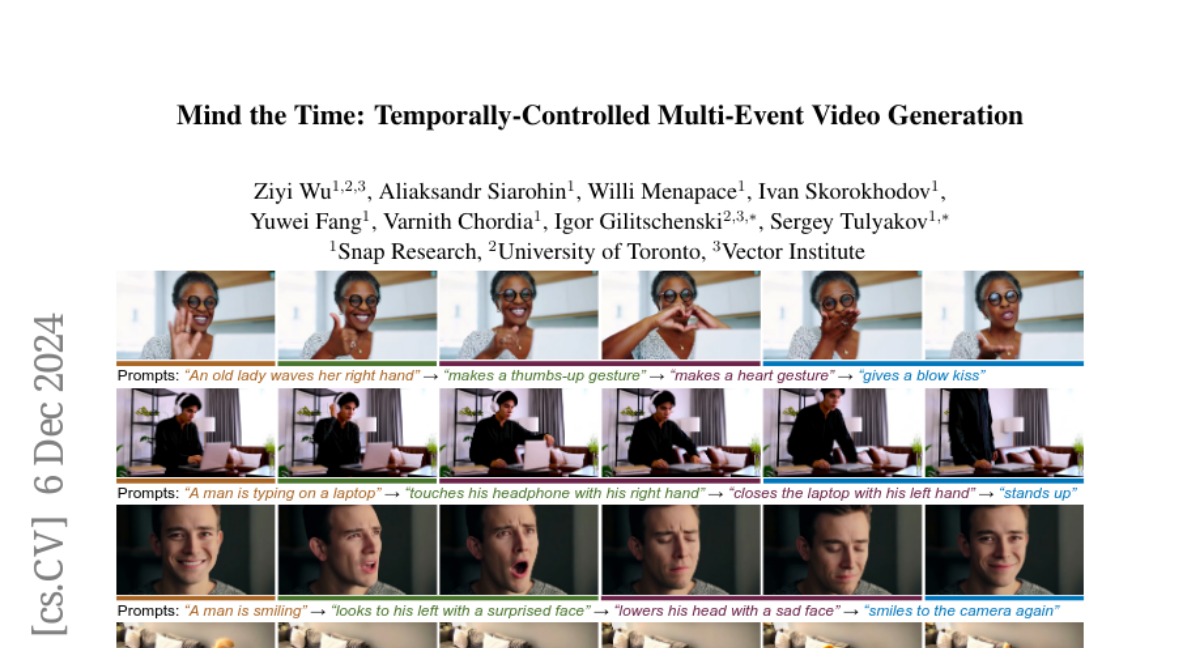

В последние годы наблюдается значительный прогресс в области генерации видео с использованием моделей диффузии. Однако большинство существующих подходов ограничены генерацией одного события на основе единого текстового запроса. В реальном мире видео часто состоят из последовательностей событий, которые требуют более тонкого управления временными аспектами. В этой статье мы рассмотрим новый подход, представленный в работе "MindtheTime" (MinT), который позволяет генерировать многособытийные видео с управлением временем.

Создание реалистичных видео, которые отражают последовательности событий, является сложной задачей для существующих генеративных моделей. Большинство из них используют один текстовый запрос, что приводит к игнорированию некоторых событий или неправильному порядку их генерации. MinT решает эту проблему, связывая каждое событие с определенным временным интервалом в генерируемом видео. Это позволяет модели сосредоточиться на одном событии за раз и создавать плавные переходы между ними.

Основные идеи

Ключевым аспектом MinT является привязка каждого события к конкретному времени в видео. Это достигается с помощью нового метода позиционного кодирования, названного ReRoPE (Rescaled Rotary Position Encoding), который помогает направлять операции кросс-внимания. Модель MinT, основанная на предварительно обученном трансформере диффузии, может генерировать последовательные события с точным контролем времени.

Связанные работы

В области генерации видео с текстовыми подсказками было много исследований, однако большинство из них сталкиваются с проблемами при генерации последовательностей событий. Например, работа Phenaki использует маскированные трансформеры для генерации каждого события по отдельности, что приводит к ухудшению качества при длинных последовательностях. MinT предлагает альтернативный подход, который обрабатывает все текстовые подсказки одновременно, обеспечивая согласованность и плавные переходы между событиями.

Методология

Формулировка задачи

MinT принимает последовательность текстовых подсказок, каждая из которых имеет свои временные метки начала и конца. Цель состоит в том, чтобы сгенерировать видео, которое будет содержать все события в заданные временные рамки. Это требует от модели умения планировать временные интервалы для каждого события.

Архитектура MinT

MinT строится на основе предварительно обученного текстово-видео трансформера (DiT). В каждой блоке DiT внедряются два слоя кросс-внимания: один для глобальных подсказок, а другой — для временных. Это позволяет модели эффективно обрабатывать временные метки и связывать их с соответствующими видео токенами.

Позиционное кодирование ReRoPE

Для управления временными аспектами в MinT используется метод позиционного кодирования ReRoPE. Этот метод позволяет модели фокусироваться на видео токенах в пределах временного интервала каждого события. Он также обеспечивает плавные переходы между событиями, что критически важно для создания реалистичных видео.

Эксперименты и результаты

MinT был протестирован на нескольких наборах данных, включая HoldOut и StoryBench. Результаты показывают, что MinT значительно превосходит существующие модели в отношении качества визуализации, согласованности событий и плавности переходов.

Генерация видео на основе текстовых подсказок

В экспериментах MinT демонстрирует способность генерировать видео, соответствующие заданным временным меткам событий. Например, при запросе "Кот прыгает со стола на пол" модель успешно создает плавную анимацию, в которой все действия выполняются в правильной последовательности.

Генерация видео на основе изображений

MinT также успешно работает в режиме генерации видео на основе изображений, где он анимирует объекты в существующих изображениях. Это позволяет создавать последовательные действия с сохранением идентичности объектов.

Улучшение подсказок с использованием LLM

MinT включает в себя механизм улучшения подсказок, который использует большие языковые модели (LLM) для расширения коротких текстов в более детализированные описания событий. Это позволяет пользователю генерировать более интересные и динамичные видео из простых запросов.

Заключение

MinT представляет собой значительный шаг вперед в области генерации видео с управлением временем. С помощью уникального подхода к позиционному кодированию и возможности работы с многособытийными запросами, MinT открывает новые горизонты для контролируемого создания контента. Будущие исследования могут сосредоточиться на улучшении моделей для генерации сложных сцен с несколькими объектами и действиями, а также на интеграции с методами персонализации видео.

В целом, MinT демонстрирует, что управление временными аспектами в генерации видео — это важный шаг к созданию более реалистичных и интерактивных медиаформатов.