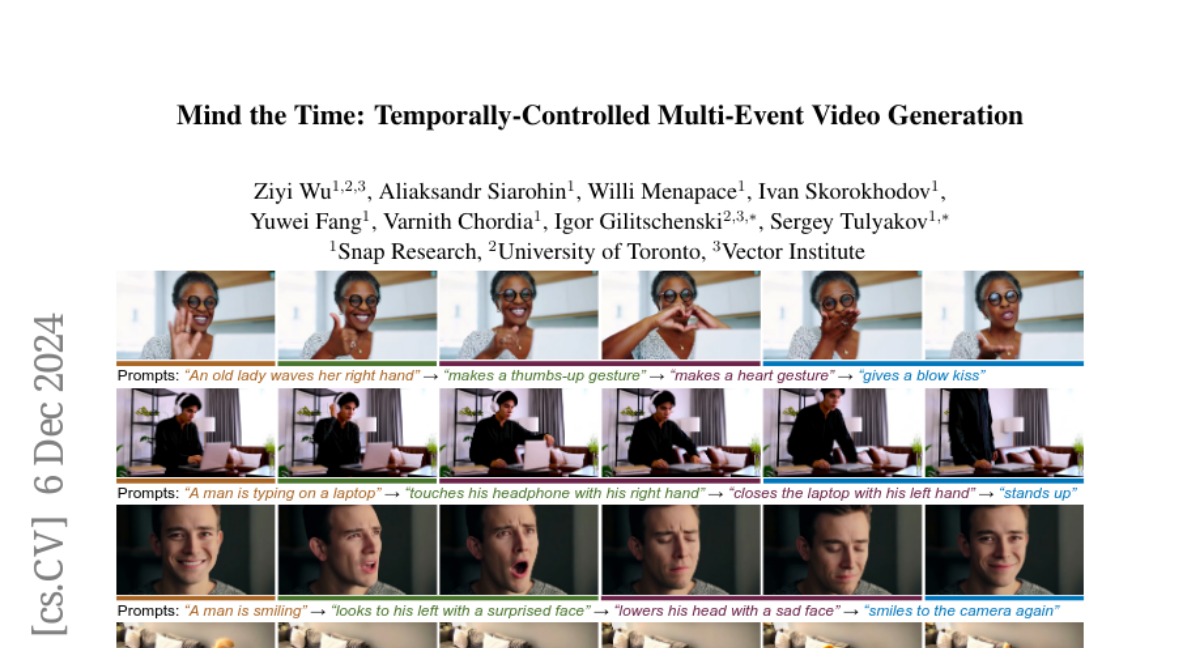

MindtheTime: Управление временем в многособытийной генерации видео

Видеоролики из реальной жизни состоят из последовательностей событий. Генерация таких последовательностей с точным временным контролем невозможна с помощью существующих генераторов видео, которые полагаются на один абзац текста в качестве входных данных. При задании задачи генерации нескольких событий, описанных с помощью одного запроса, такие методы часто игнорируют некоторые события или не могут расположить их в правильном порядке. Чтобы справиться с этим ограничением, мы представляем MinT, многособытийный генератор видео с временным контролем. Наше ключевое понимание состоит в том, чтобы связать каждое событие с определенным периодом в создаваемом видео, что позволяет модели сосредоточиться на одном событии за раз. Для обеспечения временной осведомленности взаимодействий между подписями событий и видео-токенами мы разрабатываем метод позиционного кодирования на основе времени, названный ReRoPE. Это кодирование помогает направлять операцию перекрестного внимания. Путем дообучения предобученного трансформера диффузии видео на временно привязанных данных наш подход создает согласованные видео с плавно соединенными событиями. Впервые в литературе наша модель предлагает контроль над временем событий в созданных видео. Обширные эксперименты показывают, что MinT значительно превосходит существующие модели с открытым исходным кодом.