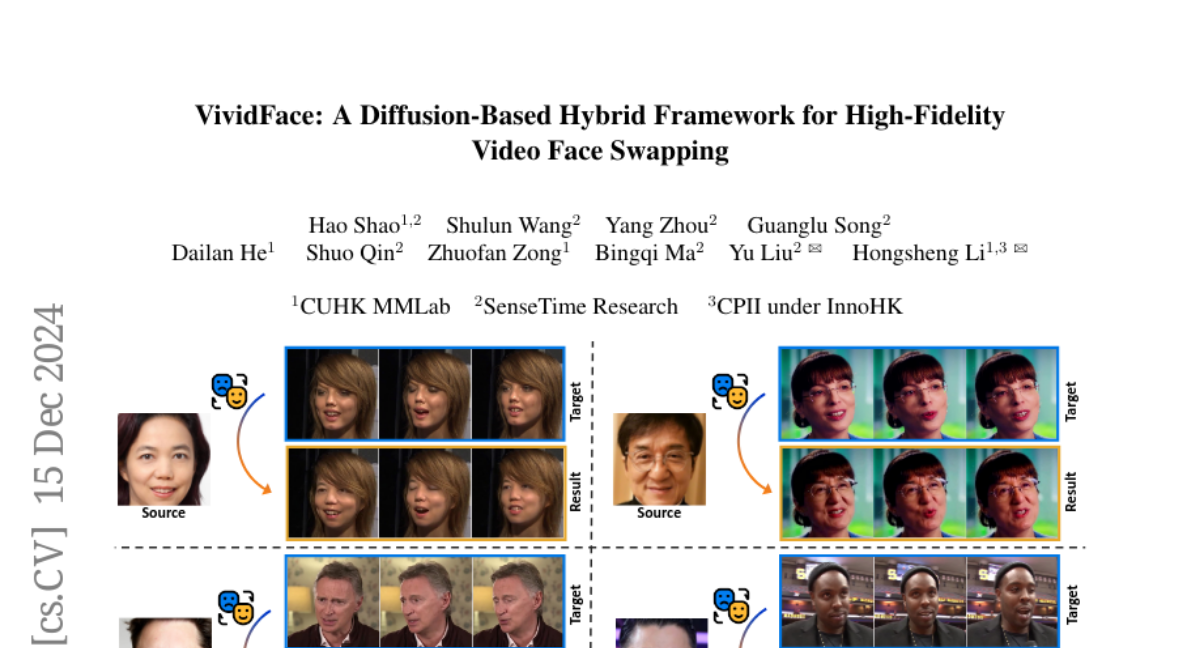

VividFace: Диффузионная гибридная система для высококачественного видео-замены лиц

С каждым годом технологии замены лиц становятся все более актуальными в различных областях, таких как создание контента, защита конфиденциальности и производство сцен с трюками. С увеличением популярности видео как основного средства общения растет и потребность в высококачественных методах замены лиц. Технология замены лиц в видео включает в себя извлечение идентификационных характеристик из исходного лица и их бесшовную интеграцию с атрибутами (такими как выражения, позы и фон) целевого лица, при этом необходимо сохранять временную согласованность.

Тем не менее, существующие методы в основном ориентированы на статические изображения и сталкиваются с трудностями при работе с динамическими видео последовательностями. Это связано с необходимостью поддержания временной согласованности, управлением большими вариациями поз и решением проблем с окклюзиями.

В данной статье мы представляем VividFace — первую диффузионную систему, специально разработанную для замены лиц в видео. Наш метод включает в себя новую гибридную стратегию обучения, которая использует как статические изображения, так и временные видеопоследовательности, что позволяет преодолеть ограничения, связанные с обучением только на видео.

Основные концепции VividFace

Гибридная стратегия обучения

VividFace использует гибридную стратегию обучения, которая сочетает в себе данные статических изображений и видеопоследовательностей. Это позволяет значительно увеличить разнообразие обучающих образцов и улучшить качество генерации. Основная идея заключается в том, что статические изображения могут служить источником разнообразия, в то время как видеоданные обеспечивают временную согласованность.

Диффузионная модель

VividFace использует специально разработанную диффузионную модель, которая обрабатывает как статические изображения, так и временные видеоданные. Эта модель позволяет поддерживать временную согласованность и уменьшает проблемы с фликерингом и искажениями, которые часто возникают в видео. В основе модели лежит подход, основанный на вероятностной модели диффузии, которая постепенно удаляет шум из данных, начиная с случайного состояния и заканчивая высококачественным изображением.

Датасет AIDT

Для улучшения процесса замены лиц мы представляем датасет AIDT (Attribute-Identity Disentanglement Triplet). Каждая тройка данных состоит из трех изображений лиц: исходного, целевого и GAN-сгенерированного изображения, которое соответствует позе и выражению целевого лица, но имеет другую идентичность. Этот подход позволяет модели лучше разделять и сохранять идентичность и атрибуты лиц.

3D-реконструкция

Для управления большими вариациями поз в VividFace интегрированы техники 3D-реконструкции. Используя 3D-морфабельные модели (3DMM), мы можем точно захватывать позы и выражения лиц, что способствует улучшению качества генерации и согласованности во времени.

Связанные работы

Существующие методы замены лиц можно разделить на три основные категории: основанные на 3D, GAN и диффузионные модели. Традиционные 3D-методы часто сталкиваются с проблемами низкого разрешения и смешивания лиц, тогда как GAN-методы могут испытывать нестабильность в обучении и проблемы с коллапсом режимов. В последние годы диффузионные модели стали популярными благодаря своей способности генерировать высококачественные изображения с меньшими затратами на обучение.

Однако большинство существующих диффузионных методов ограничены статическими изображениями и не решают задачи замены лиц в видео, что делает VividFace уникальным и прогрессивным решением.

Архитектура VividFace

Основная структура

VividFace состоит из нескольких ключевых компонентов, включая диффузионную модель, VAE (вариационный автокодировщик) и модули временной обработки. Основная архитектура включает в себя U-Net, который отвечает за удаление шума и генерацию изображений.

Модули временной обработки

Модули временной обработки в VividFace обеспечивают согласованность между кадрами видео, что является критически важным для успешной замены лиц. Эти модули используют механизмы самовнимания для захвата временных зависимостей и улучшения качества сгенерированных видео.

Обучение и тестирование

Процесс обучения VividFace состоит из нескольких этапов. На первом этапе обучается VAE, который отвечает за качественную реконструкцию лиц. На следующих этапах происходит предобучение модели с использованием статических изображений, а затем активируются временные модули для обучения на видеоданных.

Эксперименты и результаты

Сбор данных

Для обучения моделей VividFace было собрано около 300 часов лицевых видео с различных источников, включая VGGFace2-HQ. Используя эти данные, мы смогли создать высококачественные замены лиц в видео.

Оценка производительности

Производительность VividFace была оценена с использованием различных метрик, таких как FVD (Fréchet Video Distance), SSIM, PSNR и LPIPS. Результаты показали, что VividFace превосходит существующие методы по качеству визуализации, сохранению идентичности и временной согласованности.

Сравнение с существующими методами

В качественном сравнении VividFace демонстрирует высокую степень сохранения атрибутов и идентичности, даже в сложных сценариях, таких как большие вариации поз и окклюзии. В отличие от других методов, VividFace успешно восстанавливает окклюзированные области и поддерживает высокое качество замены лиц.

Заключение

VividFace представляет собой значительный шаг вперед в области замены лиц в видео. Используя гибридную стратегию обучения, диффузионные модели и 3D-реконструкцию, мы смогли решить многие проблемы, связанные с временной согласованностью, сохранением идентичности и управлением окклюзиями. Результаты экспериментов подтверждают эффективность нашего подхода и открывают новые возможности для будущих исследований в этой области.