ACDIT: Интерполирующая Автогрегрессионная Условная Модель и Диффузионный Трансформер

В последние годы наблюдается значительный интерес к многомодальным моделям, которые объединяют различные типы данных, такие как текст, изображения и видео. Однако объединение этих различных модальностей сталкивается с проблемами, связанными с различными методологиями. В частности, модели диффузии, которые продемонстрировали выдающиеся результаты в генерации изображений, работают в неавтогрегрессионном режиме, в то время как автогрегрессионные модели, используемые в обработке текста, требуют последовательного предсказания. В этой статье мы исследуем новый подход к объединению этих двух парадигм в рамках модели ACDIT (Autoregressive Conditional Diffusion Transformer), которая позволяет гибко интерполировать между автогрегрессией и диффузией.

Основы ACDIT

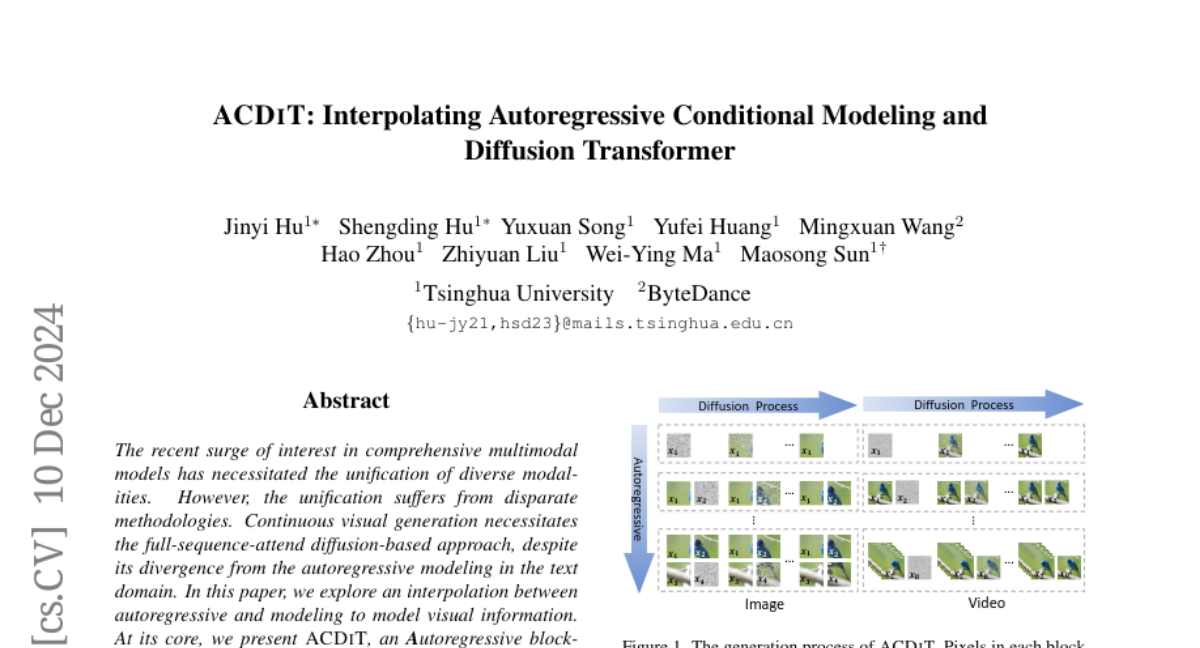

ACDIT представляет собой блоковую условную диффузионную модель, которая использует автогрегрессионные единицы для генерации визуальной информации. Основная идея заключается в том, чтобы расширить автогрегрессионные единицы от отдельных текстовых токенов до блоков, где каждый блок может состоять из визуальных патчей произвольного размера. Это позволяет модели одновременно учитывать причинные зависимости между блоками и некондиционные зависимости внутри блоков, что делает ACDIT мощным инструментом для генерации как изображений, так и видео.

Архитектура ACDIT

ACDIT использует архитектуру трансформера, которая включает в себя механизм внимания с маской, называемой Skip-Causal Attention Mask (SCAM). Эта маска позволяет модели эффективно обрабатывать как чистые блоки, так и зашумленные блоки, обучая модель предсказывать чистые блоки на основе предыдущих чистых блоков. Во время обучения модель оптимизирует условное распределение, а во время вывода выполняет итерации между процессом денойзинга и автогрегрессионной генерацией.

Преимущества ACDIT

- Единая архитектура: ACDIT объединяет сильные стороны как автогрегрессионного, так и диффузионного подходов, что делает его универсальным инструментом для будущих многомодальных моделей.

- Чистый визуальный ввод: Модель обучается на чистых визуальных данных, что улучшает результаты в задачах визуального понимания.

- Эффективность: ACDIT делает полный акцент на использование кеша ключей и значений (KV-Cache) для быстрого вывода, что позволяет значительно ускорить процесс генерации.

Связанные работы

Модели диффузии

Модели диффузии, такие как U-Net и DiT, продемонстрировали выдающиеся результаты в генерации изображений. Эти модели работают путем добавления шума к исходным данным и последующего обучения на обратном процессе, что позволяет им создавать визуальные данные, практически неотличимые от человеческих. Однако они, как правило, не способны эффективно учитывать временные зависимости в данных, что делает их менее подходящими для задач, связанных с видео.

Автогрегрессионные модели

Автогрегрессионные модели, такие как iGPT, показали многообещающие результаты в генерации визуальных данных. Они работают, предсказывая последовательность пикселей или токенов, основываясь на предыдущих значениях. Однако их производительность может страдать из-за необходимости обрабатывать длинные последовательности, что приводит к накоплению ошибок.

Объединенные модели

Существующие попытки объединить различные модальности часто сводятся к преобразованию многомодальных задач в задачи предсказания отдельных токенов. Модели, такие как VILA-U и Transfusion, пытались создать единые архитектуры, объединяющие понимание и генерацию, однако многие из них не смогли эффективно использовать сильные стороны как автогрегрессионных, так и диффузионных подходов.

Принципы ACDIT

Автогрегрессия

Автогрегрессия основывается на предположении, что значения в последовательности зависят от предыдущих значений. Это позволяет моделям предсказывать вероятностное распределение последующих токенов, что особенно полезно в задачах генерации текста и изображений.

Диффузия

Модели диффузии, в отличие от автогрегрессионных, рассматривают процесс добавления шума к данным и последующее обучение на обратном процессе. Это позволяет создавать высококачественные визуальные данные, но затрудняет обучение временных зависимостей.

Требования к модели

Для успешной интеграции автогрегрессии и диффузии модель ACDIT должна удовлетворять нескольким требованиям:

- Генерация будущих элементов должна основываться на четком представлении предыдущих последовательностей.

- Модель должна эффективно использовать все параметры нейронной сети для обеих задач.

- Процесс денойзинга должен учитывать всю последовательность предыдущих данных.

Архитектура ACDIT

ACDIT включает два типа блоков: чистые блоки и зашумленные блоки. Каждый блок обучается на основе предыдущих чистых блоков, что позволяет эффективно использовать механизмы внимания. В процессе вывода модель выполняет итерации между денойзингом и генерацией новых блоков, что обеспечивает гибкость в создании визуальных данных.

Позиционное кодирование

ACDIT использует расширение Rotary Position Embedding (RoPE) для обработки многомерных данных. Это позволяет модели учитывать позиционную информацию в данных, что критически важно для генерации последовательностей.

Эффективность и выбор размера блока

Модель ACDIT демонстрирует высокую вычислительную эффективность. Выбор размера блока влияет на производительность и качество генерации. Модель позволяет настраивать размер блока, что обеспечивает баланс между качеством и скоростью генерации.

Эксперименты

Настройка экспериментов

Для оценки эффективности ACDIT были проведены эксперименты на наборе данных ImageNet для генерации изображений и UCF-101 для генерации видео. Модель была обучена с использованием оптимизатора AdamW и различных стратегий обучения.

Основные результаты

Результаты экспериментов показали, что ACDIT превосходит все базовые автогрегрессионные модели по качеству изображений и скорости вывода. Модель демонстрирует конкурентоспособные результаты по сравнению с диффузионными моделями, такими как DiT, при этом обеспечивая значительно более высокую скорость генерации.

Анализ компромиссов

В ходе экспериментов была проведена оценка компромиссов между размером блока и качеством генерации. Увеличение длины автогрегрессионной последовательности приводит к снижению качества изображений, однако это можно компенсировать увеличением общей длины последовательности.

Заключение

Модель ACDIT представляет собой значительный шаг вперед в области генерации визуальных данных, объединяя сильные стороны автогрегрессионных и диффузионных подходов. Эта модель не только демонстрирует выдающиеся результаты в задачах генерации изображений и видео, но и открывает новые возможности для создания унифицированных многомодальных моделей в будущем. ACDIT может стать основой для дальнейших исследований и разработок в области искусственного интеллекта, особенно в контексте создания "моделей мира", которые способны эффективно обрабатывать и генерировать сложные визуальные данные.