Адаптация многомодальных больших языковых моделей к специфическим доменам: постобучение, синтез данных и оценка задач

С недавним развитием многомодальных больших языковых моделей (MLLM) стало очевидно, что их применение в специфических областях, таких как биомедицина и пищевая промышленность, требует особого внимания. Хотя общие MLLM продемонстрировали впечатляющие результаты в различных задачах, их эффективность в специализированных доменах часто оказывается недостаточной из-за нехватки данных и специфического обучения. В данной статье мы рассматриваем подходы к адаптации MLLM к специфическим доменам через постобучение, сосредотачиваясь на синтезе данных, обучающих пайплайнах и оценке задач.

Синтез данных

Визуальный синтезатор инструкций

Одной из ключевых проблем, с которой сталкиваются MLLM при адаптации к специфическим доменам, является недостаток доступных визуальных инструкций. Для решения этой проблемы мы разработали визуальный синтезатор инструкций, который эффективно генерирует разнообразные задачи на основе пар изображений и подписей, специфичных для домена. Этот синтезатор использует открытые модели и позволяет создать более разнообразные и точные задачи по сравнению с традиционными ручными методами или использованием закрытых моделей, таких как GPT-4.

Синтезатор обучается на наборе данных, включающем различные домены и типы задач, что позволяет ему извлекать доменные знания из источников изображений для создания разнообразных пар "инструкция-ответ". Этот подход позволяет значительно увеличить разнообразие задач, что критически важно для успешного постобучения MLLM.

Фильтрация данных на основе согласованности

Для повышения точности синтетических задач мы применяем фильтрацию на основе согласованности. Этот метод позволяет отфильтровывать задачи, которые не соответствуют внутренним критериям согласованности между инструкцией и ответами. Таким образом, мы уменьшаем зависимость от аннотаций экспертов, что делает процесс более эффективным и менее затратным.

Обучающий пайплайн

Одностадийный подход к обучению

Традиционно для обучения MLLM использовался двухстадийный подход: сначала обучение на парах изображений и подписей, затем на визуальных инструкциях. Однако в нашей работе мы предлагаем одностадийный подход, который объединяет синтетические задачи с задачами по аннотированным изображениям. Это позволяет избежать потерь в разнообразии задач, которые могут возникнуть при разделении обучения на два этапа.

Одностадийный подход не только увеличивает разнообразие задач, но и снижает вероятность катастрофического забвения знаний, полученных на первом этапе. Мы проводим эксперименты с различными MLLM, такими как Qwen2-VL-2B и LLaVA-v1.6-8B, и показываем, что наш подход значительно улучшает производительность моделей на специфических задачах.

Оценка задач

Эксперименты в специфических доменах

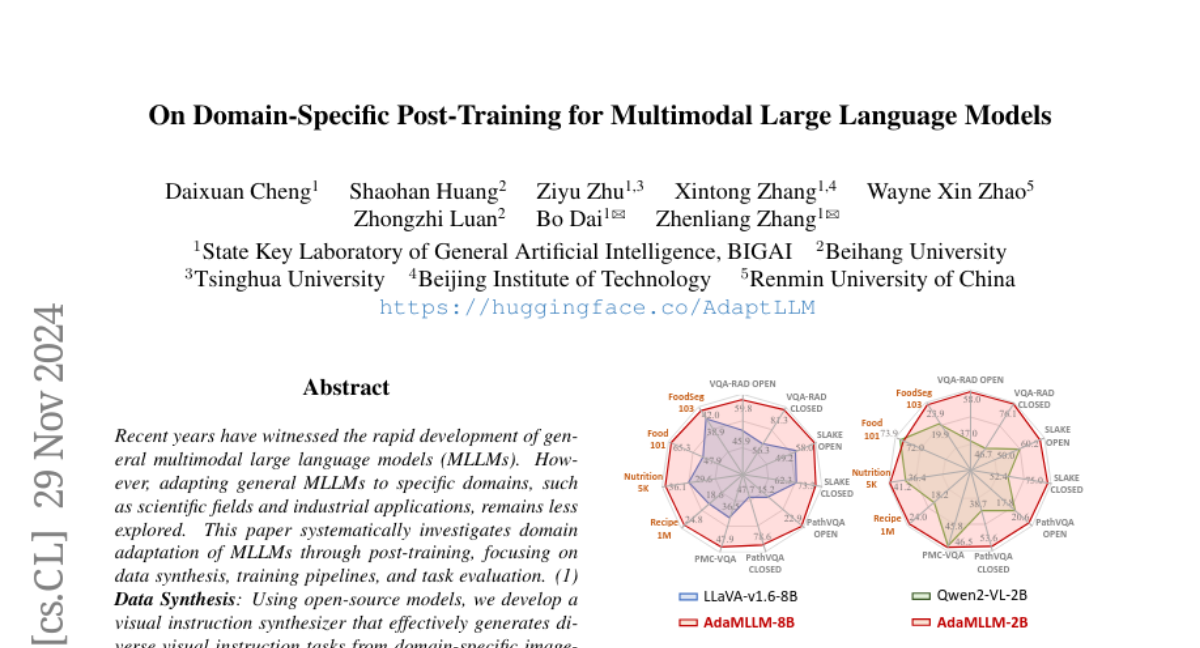

Мы провели эксперименты в двух специфических доменах: биомедицине и пище. В каждом из этих доменов мы адаптировали общие MLLM и оценили их производительность на различных специфических задачах. Результаты показали, что модели, прошедшие постобучение с использованием нашего синтезатора, значительно превосходят общие MLLM по эффективности в специфических задачах.

Оценка производительности

Для оценки производительности моделей мы используем несколько наборов данных, таких как SLAKE и Recipe1M. Мы сравниваем производительность моделей, адаптированных с помощью нашего подхода, с производительностью базовых моделей. Результаты показывают, что наш метод consistently улучшает производительность MLLM в различных задачах, что подтверждает эффективность предложенного нами подхода.

Заключение

В данной статье мы представили систематический подход к адаптации многомодальных больших языковых моделей к специфическим доменам через постобучение. Мы разработали визуальный синтезатор инструкций, который позволяет генерировать разнообразные задачи из пар изображений и подписей, а также предложили одностадийный подход к обучению, который улучшает производительность MLLM. Наши эксперименты в доменах биомедицины и пищи продемонстрировали, что адаптированные модели значительно превосходят общие MLLM в специфических задачах. Мы надеемся, что наши результаты вдохновят дальнейшие исследования в области адаптации MLLM к специфическим доменам, что приведет к более эффективным моделям для решения специализированных задач.