VisDoM: Мультимодальное QA с визуально насыщенными элементами

В современном мире, где информация представлена в огромных объемах и разнообразных форматах, эффективное извлечение знаний из документов является актуальной задачей. Одним из наиболее сложных аспектов этой задачи является обработка многодокументных наборов данных, содержащих как текстовую, так и визуальную информацию, такую как таблицы, графики и слайды презентаций. Это делает задачу вопросно-ответного анализа (QA) значительно более сложной, чем работа с одиночными документами.

Задачи многодокументного QA

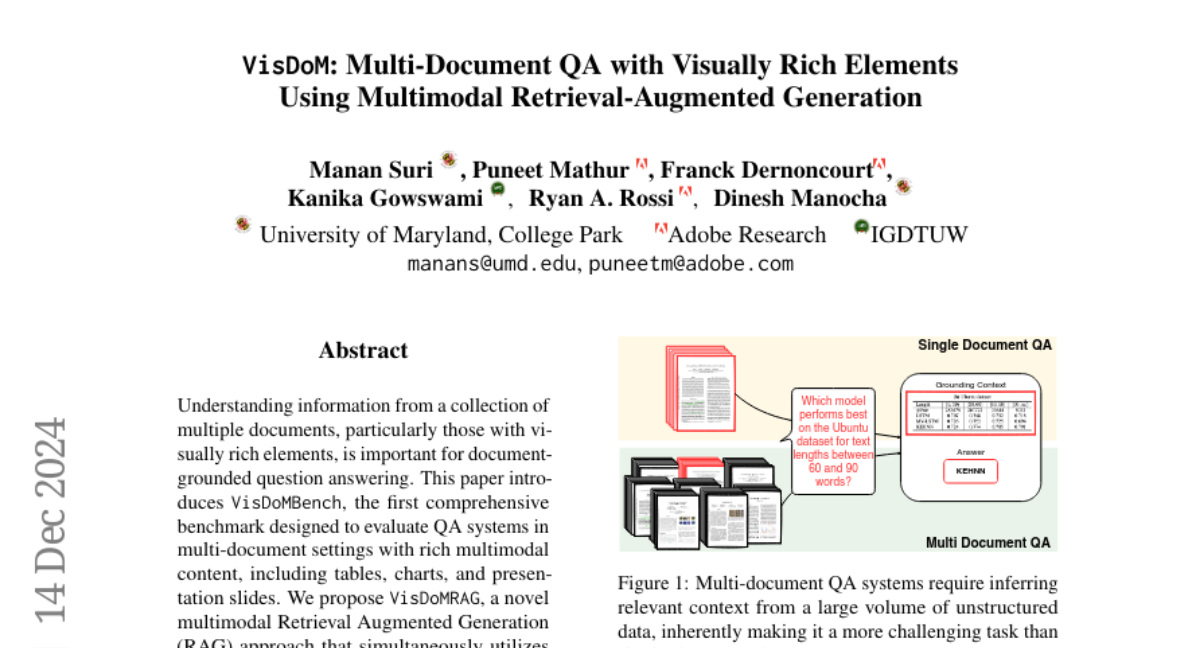

Многодокументный QA требует от систем способности извлекать релевантный контекст из большого объема неструктурированных данных. Это связано с тем, что информация может быть распределена по нескольким документам, и необходимо эффективно локализовать контекст, относящийся к заданному запросу. Например, в областях, таких как финансы или научные исследования, пользователи часто взаимодействуют с большими наборами документов, чтобы найти конкретную информацию.

Проблемы существующих подходов

Существующие системы QA, как правило, сосредоточены на текстовой информации, игнорируя визуальные элементы, которые могут содержать ключевую информацию. Визуальные элементы, такие как таблицы и графики, предоставляют структурированные данные и визуальные резюме, которые критически важны для ответов на определенные типы вопросов. Например, ответ на финансовый или научный вопрос может требовать интерпретации как числовых данных в таблицах, так и тенденций в графиках.

VisDoMBench: Набор данных для многодокументного QA

Для решения вышеупомянутых проблем был создан VisDoMBench, первый в своем роде набор данных, специально разработанный для оценки систем QA в многодокументных условиях с визуально насыщенным контентом. VisDoMBench включает разнообразные типы вопросов и контента, а также аннотированные доказательства, что позволяет проводить комплексную оценку мультимодальных систем QA.

Структура VisDoMBench

Каждая запись в VisDoMBench может быть представлена в виде тройки (q, D, ˆa), где q — это вопрос, D — набор документов, а ˆa — истинный ответ. Набор данных включает в себя существующие документные QA наборы, такие как PaperTab и SciGraphQA, и адаптирован для включения визуально насыщенных элементов.

Процесс формирования данных

При формировании VisDoMBench учитывались следующие критерии:

- Включение визуально насыщенного контента (таблицы, графики, слайды).

- Использование общедоступных исходных документов.

- Наличие обоснованных доказательств.

Это позволило создать набор данных, который актуален для мультимодального извлечения информации и применим к реальным задачам QA.

VisDoMRAG: Мультимодальный подход к RAG

В основе работы над VisDoMBench лежит предложение VisDoMRAG — нового мультимодального подхода к Retrieval-Augmented Generation (RAG), который эффективно объединяет текстовые и визуальные потоки обработки. VisDoMRAG использует параллельные RAG-потоки для текстовых и визуальных элементов, что позволяет извлекать и обрабатывать информацию из различных модальностей одновременно.

Архитектура VisDoMRAG

VisDoMRAG состоит из двух основных этапов:

- Параллельные unimodal RAG-потоки для текстового и визуального извлечения.

- Модальность слияния, которая накладывает ограничения на согласованность, чтобы объединить выводы из обоих потоков.

Этот подход отличается от традиционных unimodal или упрощенных мультимодальных систем, обеспечивая более полное использование информации из обеих модальностей.

Этапы обработки в VisDoMRAG

Параллельные RAG-потоки

-

Текстовый поток: Извлечение текста из документов с использованием OCR, сегментация текста на меньшие индексируемые части и их индексация с помощью модели текстового встраивания. Релевантные части текста извлекаются и предоставляются LLM для генерации ответов.

-

Визуальный поток: Извлечение и анализ графических элементов, таких как изображения и графики. Для данного набора документов создается индекс на уровне страниц, и релевантные страницы извлекаются визуальной моделью извлечения на основе заданного запроса.

Стратегия запроса

Оба потока используют сложную трехступенчатую стратегию запроса:

- Курация доказательств: Извлечение ключевых секций из контекста, которые, вероятно, относятся к запросу.

- Размышления по цепочке (CoT): Связывание отдельных частей доказательств в последовательную нарративную цепочку.

- Генерация ответов: Использование курации и CoT для создания точных и обоснованных ответов.

Слияние модальностей

Этап слияния модальностей является ключевым вкладом в VisDoMRAG. Этот этап принимает на вход результаты из текстового и визуального потоков, включая курацию доказательств и сгенерированные ответы. Процесс слияния обеспечивает согласованность между выводами из разных модальностей, позволяя создать финальный ответ, который логически интегрирует информацию из обоих источников.

Эксперименты и результаты

В ходе экспериментов оценивалась производительность различных методов извлечения и индексации на наборе данных VisDoMBench, а также проводилась оценка QA с использованием оптимальных моделей извлечения и различных LLM.

Базовые линии

Использовались популярные текстовые модели извлечения, такие как BM25 и современные модели плотного извлечения, такие как MPNet и MiniLM. Для визуального извлечения применялись последние разработки на основе многовекторного извлечения.

Оценка производительности

Результаты показали, что VisDoMRAG значительно превосходит традиционные методы, такие как длинный контекст и текстовые RAG, с увеличением производительности на 12-20% в различных условиях.

Качественные примеры

Качественные примеры, извлеченные из наборов данных, показали, как VisDoMRAG эффективно использует цепочки размышлений и выводы из unimodal RAG для синтеза правильных ответов. Эти примеры подчеркивают способность системы обрабатывать сложные запросы, требующие интеграции информации из различных источников.

Заключение и будущее

В данной работе был представлен VisDoMBench — первый набор данных QA, разработанный для оценки многодокументных систем с визуально насыщенным контентом. Кроме того, был предложен VisDoMRAG — мультимодальный подход к RAG, который продемонстрировал значительное улучшение по сравнению с традиционными методами.

Перспективы будущих исследований

Будущие исследования могут сосредоточиться на расширении этого подхода для включения более сложных задач, таких как обучение на основе примеров и использование end-to-end обученных моделей, особенно в условиях ограниченных ресурсов. Это откроет новые горизонты для применения мультимодальных систем QA в реальных сценариях, где информация часто представлена в смешанных форматах.