Нойз-рефайн: Эффективный подход к генерации изображений без использования методов управления

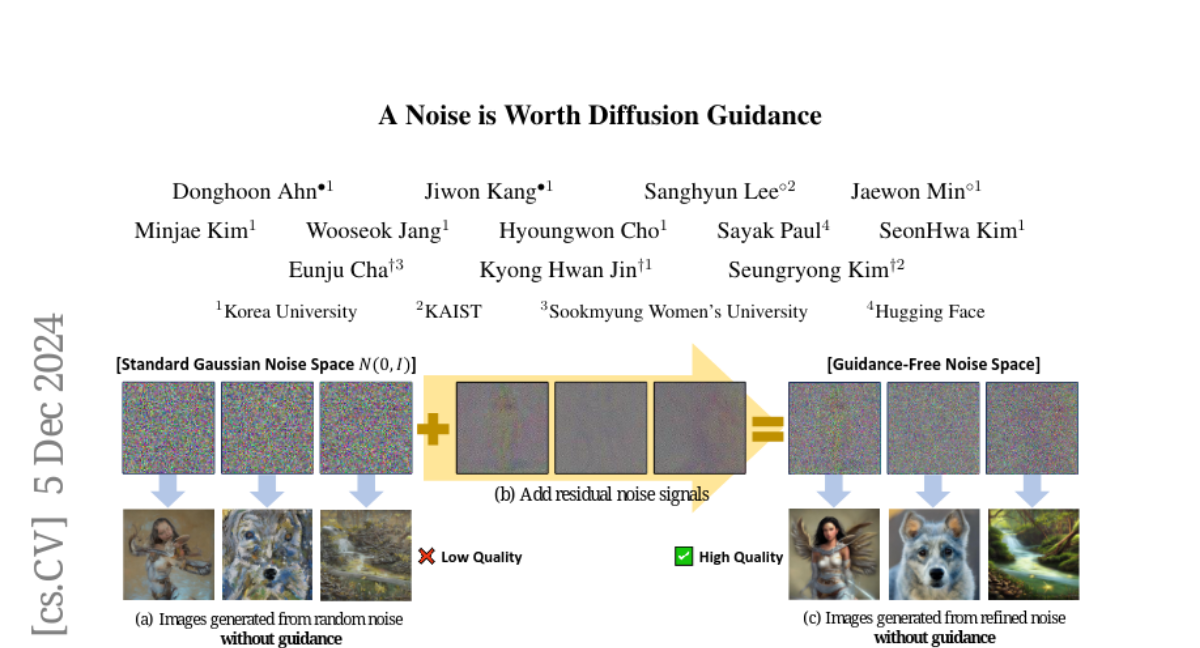

Модели диффузии отлично справляются с генерацией высококачественных изображений. Однако современные модели диффузии испытывают трудности с получением надежных изображений без методов управления, таких как управление без классификатора (CFG). Действительно ли методы управления необходимы? Наблюдая, что шум, полученный через инверсию диффузии, может восстанавливать высококачественные изображения без управления, мы сосредотачиваемся на начальном шуме в процессе ухания. Переводя гауссовский шум в "шум без управления", мы обнаруживаем, что небольшие компоненты с низкой амплитудой и низкой частотой значительно улучшают процесс ухания, избавляя от необходимости в управлении и тем самым улучшая как пропускную способность вывода, так и память. Расширяя эту тему, мы предлагаем extit{наше}, новый метод, который заменяет методы управления одним уточнением начального шума. Этот уточненный шум позволяет генерировать высококачественные изображения без управления в рамках того же потока диффузии. Наша модель уточнения шума использует эффективное обучение в пространстве шума, достигая быстрой сходимости и сильных показателей с всего лишь 50K пар текст-изображение. Мы подтверждаем ее эффективность по различным метрикам и анализируем, как уточненный шум может устранить необходимость в управлении. Смотрите нашу страницу проекта: https://cvlab-kaist.github.io/NoiseRefine/.