ILLUME: Инновационный подход к многомодальным языковым моделям

С недавними достижениями в области больших языковых моделей (LLMs) и их способности обрабатывать визуальные данные, исследователи начали разрабатывать многофункциональные модели, которые могут интегрировать текст и изображения. Одним из таких подходов является ILLUME, унифицированная многомодальная языковая модель (MLLM), которая предлагает новые методы для понимания и генерации изображений и текста. В этой статье мы подробно рассмотрим концепции, лежащие в основе ILLUME, включая его архитектуру, методы обучения и эксперименты, подтверждающие его эффективность.

Архитектура ILLUME

ILLUME объединяет возможности понимания и генерации изображений и текста в одной модели. Основная архитектура включает в себя несколько ключевых компонентов:

-

Визуальный токенизатор: Это инновационный компонент, который преобразует изображения в дискретные токены, используя семантическую информацию. В отличие от традиционных токенизаторов, таких как VQGAN, которые полагаются на потерю реконструкции изображения, семантический токенизатор ILLUME использует информацию о семантике для более эффективного квантования изображений.

-

Многомодальная языковая модель (MLLM): Основная языковая модель ILLUME оптимизирована для предсказания следующего токена как в текстовом, так и в визуальном контексте. Это позволяет модели одновременно обрабатывать текстовые и визуальные данные, что значительно улучшает ее возможности в многомодальных задачах.

-

Процедура обучения: ILLUME использует трехступенчатую процедуру обучения, которая включает в себя инициализацию визуальных эмбеддингов, унифицированное выравнивание изображений и текста, а также супервайзинговую тонкую настройку для повышения производительности в конкретных задачах.

Визуальный токенизатор

Визуальный токенизатор ILLUME играет ключевую роль в процессе обучения. Он использует предварительно обученный визуальный энкодер для извлечения семантических признаков из входных изображений. Эти признаки затем квантуются в дискретные токены, которые могут быть использованы в языковой модели. Процесс квантования осуществляется в семантическом пространстве признаков, что позволяет значительно ускорить процесс выравнивания изображений и текста.

Преимущества семантического токенизатора

Семантический токенизатор ILLUME обеспечивает несколько преимуществ по сравнению с традиционными методами:

- Снижение объема данных: Для предварительного обучения ILLUME требуется всего 15 миллионов пар изображений и текста, что более чем в четыре раза меньше, чем для других моделей, таких как Janus.

- Улучшенная производительность: Несмотря на меньший объем данных, ILLUME демонстрирует конкурентоспособные или даже превосходящие результаты по сравнению с существующими унифицированными MLLM и специализированными моделями.

Процедура обучения

Процедура обучения ILLUME состоит из трех этапов:

-

Инициализация визуальных эмбеддингов: На этом этапе модель обучается на паре изображений и текста для преобразования визуальных признаков в текстовое пространство. Это помогает модели быстро адаптироваться к новым данным.

-

Унифицированное выравнивание изображений и текста: На этом этапе модель обучается на 15 миллионах пар данных, включая текстовые данные, данные о подписях к изображениям и данные для генерации изображений.

-

Супервайзинговая тонкая настройка: После предварительного обучения модель дообучается на специфичных для задач данных, чтобы улучшить производительность в конкретных многомодальных задачах.

Самоусиливающая многомодальная схема

Одной из ключевых инноваций ILLUME является самоусиливающая многомодальная схема, которая направлена на улучшение синергии между пониманием и генерацией. Эта схема позволяет модели самооценивать качество своих само-сгенерированных изображений по сравнению с текстовыми описаниями.

Этапы самоусиливающей схемы

-

Самосгенерация корпуса: Модель генерирует изображения из подмножества данных текст-к-изображению в обучающем наборе.

-

Генерация оценки: Модель оценивает несоответствия между изображениями и текстами по различным критериям, таким как точность объектов, цвет, пространственные отношения и т. д.

-

Супервайзинговая тонкая настройка для многомодального выравнивания: На основе оценок модель проходит дополнительный этап обучения, чтобы улучшить свои способности к генерации изображений и пониманию текстов.

Эксперименты и результаты

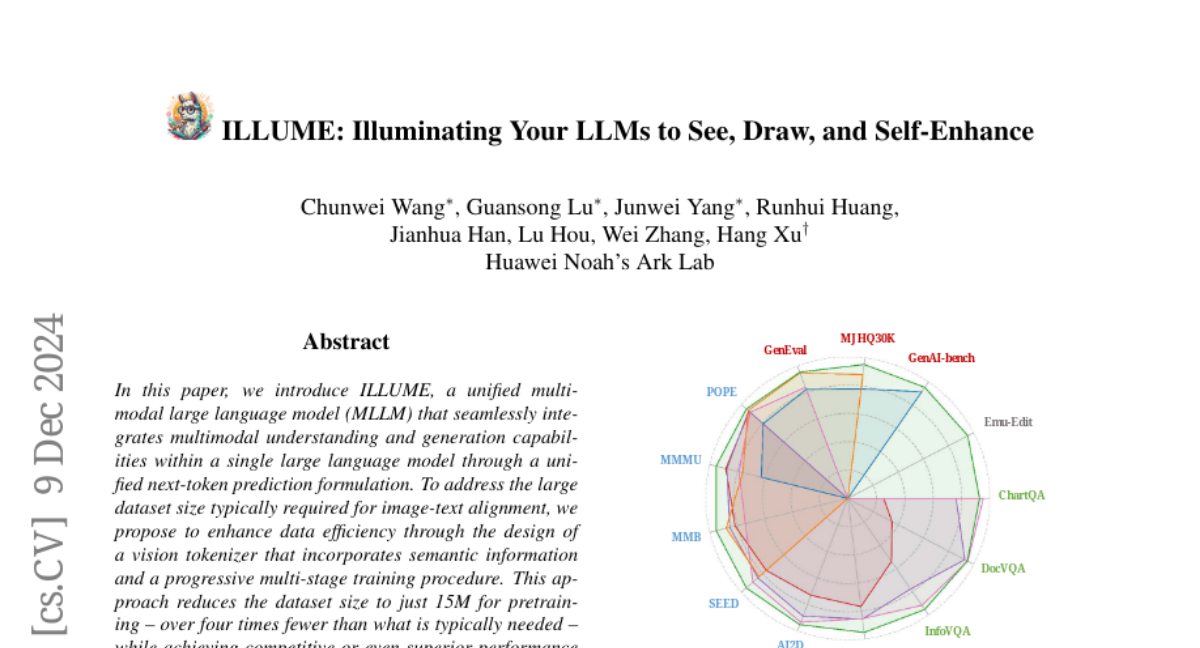

ILLUME была протестирована на различных многомодальных задачах, включая понимание, генерацию и редактирование изображений. Результаты показывают, что ILLUME достигает конкурентоспособных результатов по сравнению с существующими моделями.

Параметры оценки

-

Многомодальное понимание: ILLUME демонстрирует высокую точность на тестах, таких как POPE, MMBench и SEED, что подтверждает его способности к пониманию визуальных данных.

-

Генерация изображений: На тестах MJHQ30K и GenAI-bench ILLUME показывает впечатляющие результаты, достигая низких значений FID (Fréchet Inception Distance), что указывает на высокое качество генерируемых изображений.

-

Редактирование изображений: ILLUME также продемонстрировала конкурентоспособные результаты в задачах редактирования изображений, что подтверждает его универсальность.

Заключение

ILLUME представляет собой значительный шаг вперед в области многомодальных языковых моделей, предлагая эффективные методы для интеграции визуальных и текстовых данных. Его инновационный подход к токенизации, обучение и самоусиливающая схема открывают новые возможности для улучшения взаимодействия между пониманием и генерацией. Будущие исследования могут сосредоточиться на расширении возможностей ILLUME для работы с другими модальностями, такими как видео и аудио, а также на улучшении качества генерации изображений, что позволит создать более универсальную и мощную модель для широкого спектра приложений.