ILLUME: Инновационный подход к многомодальным языковым моделям

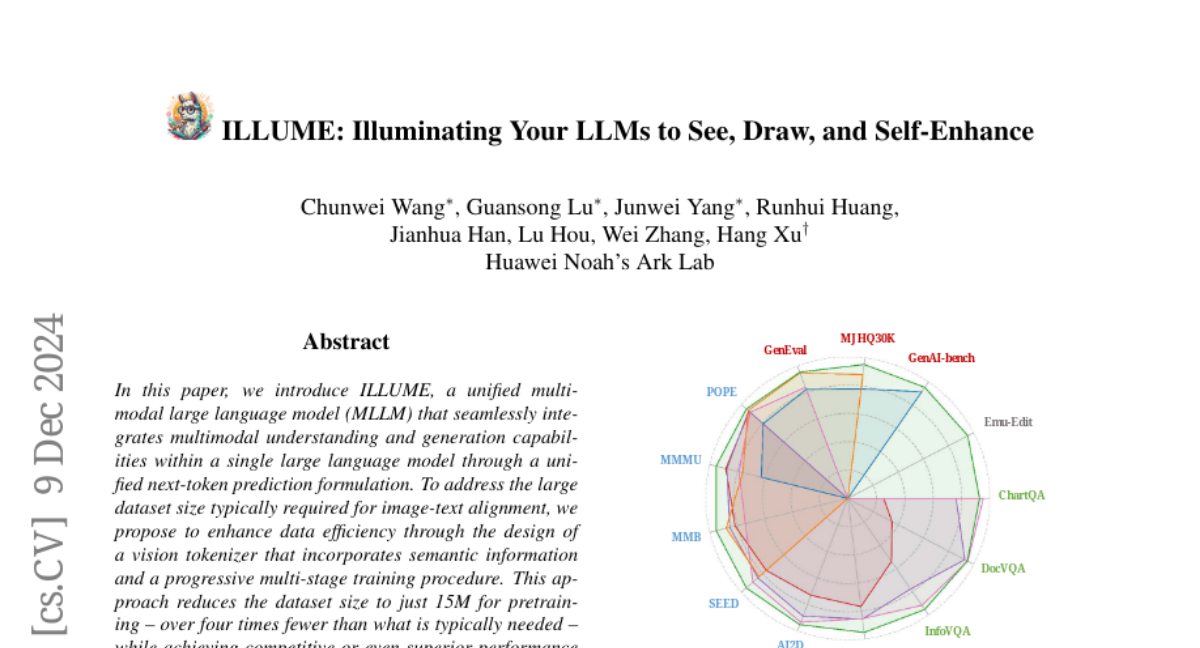

В этой статье мы представляем ILLUME, унифицированную многомодальную большую языковую модель (MLLM), которая бесшовно интегрирует возможности многомодального понимания и генерации в рамках одной большой языковой модели через унифицированную формулировку предсказания следующего токена. Чтобы решить проблему большого объема данных, который обычно требуется для сопоставления изображений и текста, мы предлагаем повысить эффективность данных за счет проектирования токенизатора изображения, который включает семантическую информацию, и прогрессивной многослойной процедуры обучения. Этот подход снижает объем данных до всего лишь 15 миллионов для предварительного обучения - более чем в четыре раза меньше, чем обычно требуется - при этом достигая конкурентоспособной или даже превосходной производительности по сравнению с существующими унифицированными MLLM, такими как Janus. Кроме того, чтобы способствовать синергетическому улучшению между возможностями понимания и генерации, что было недостаточно исследовано в предыдущих работах, мы вводим новую схему самоусиления многомодального сопоставления. Эта схема супервизирует MLLM, чтобы он мог самостоятельно оценить согласованность между текстовыми описаниями и самостоятельно сгенерированными изображениями, что помогает модели более точно интерпретировать изображения и избегать нереалистичных и некорректных предсказаний, вызванных несоответствием в генерации изображений. На основе широких экспериментов наша предложенная ILLUME выделяется и конкурирует с передовыми унифицированными MLLM и специализированными моделями по различным стандартам для многомодального понимания, генерации и редактирования.