VLsI: Вербализация слоев для взаимодействия в больших языковых моделях

С недавним ростом качества визуальных обучающих выборок от закрытых источников, таких как GPT-4V, открытые модели визуального языка (VLM) начали активно развиваться. Однако увеличение масштабов VLM для повышения производительности с использованием более крупных моделей создает значительные вычислительные проблемы, особенно при развертывании на устройствах с ограниченными ресурсами, таких как мобильные платформы и роботы. Для решения этой задачи была предложена новая модель под названием VLsI: Вербализация слоев для взаимодействия, которая ориентирована на эффективность без ущерба для точности.

Основные концепции VLsI

Архитектура VLsI

VLsI включает две основные компоненты: основную VLM и вербализаторы. Основная VLM, выбранная для этой работы, основана на Qwen2-VL, которая продемонстрировала высокую производительность на OpenVLM-Leaderboard. Вербализатор состоит из простой сети прямого распространения (FFN) и языковой головы, используемой в основной VLM. Эта архитектура позволяет проецировать промежуточные выходы в пространство естественного языка, что делает их интерпретируемыми и позволяет моделям меньшего размера гибко согласовываться с процессами рассуждения более крупных моделей.

Процесс обучения

Процесс обучения VLsI состоит из трех ключевых этапов:

-

Вербализация: На этом этапе каждый промежуточный слой получает вербализатор, который позволяет проецировать выходы этих слоев в пространство естественного языка. Для оптимизации сопоставления между встраиваниями и естественным языком используется автогрессивная потеря.

-

Взаимодействие: Этот этап включает адаптивное сопоставление слоев, чтобы согласовать прогрессию рассуждений между большими и малыми VLM. Каждому промежуточному слою в малой VLM сопоставляется соответствующий слой в большой VLM.

-

Укрепление: На последнем этапе происходит дообучение всей малой VLM на наборе данных визуальных инструкций, что улучшает ее способность следовать инструкциям и повышает точность.

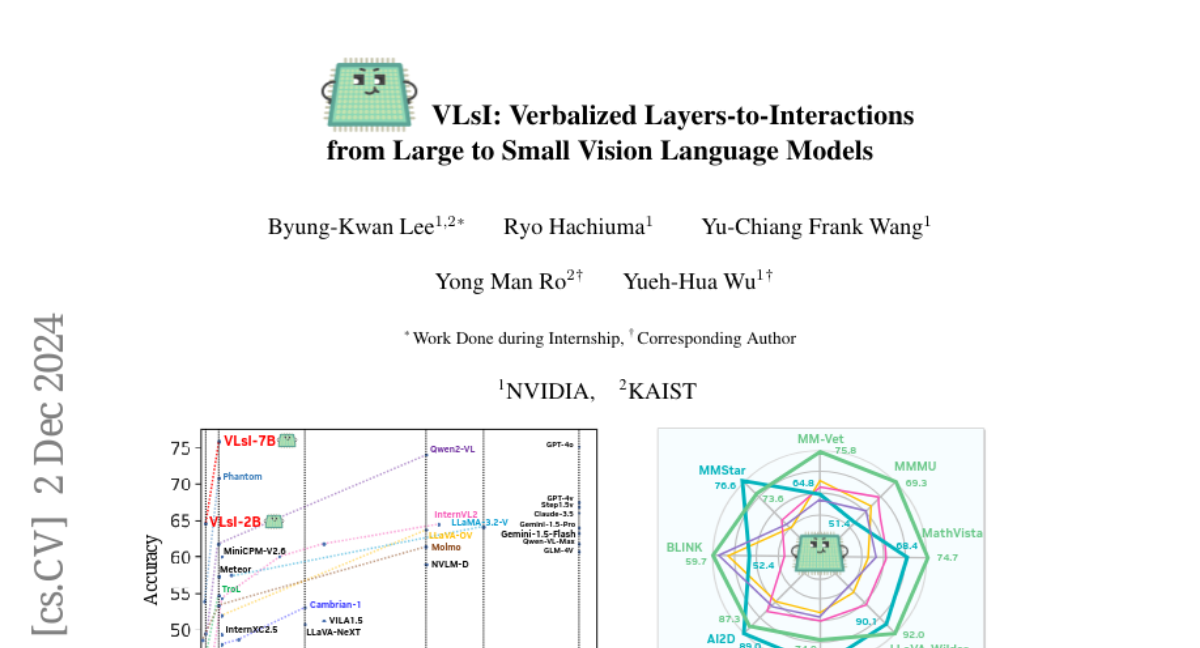

Эффективность и производительность

VLsI была протестирована на десяти сложных бенчмарках визуального языка, демонстрируя значительные приросты производительности: 11.0% для модели 2B и 17.4% для модели 7B по сравнению с GPT-4V. Эти улучшения были достигнуты без увеличения размера модели или изменения архитектуры.

Сравнение с другими VLM

Сравнение VLsI с другими открытыми и закрытыми VLM показывает, что VLsI достигает высоких показателей производительности при меньших вычислительных затратах. Модели, такие как LLaVA-OneVision и Qwen2-VL, также продемонстрировали эффективность, однако VLsI выделяется благодаря своей способности эффективно передавать знания от больших моделей к меньшим без необходимости в сложных архитектурных изменениях.

Заключение

VLsI представляет собой значительный шаг вперед в области визуального языка, предлагая эффективное решение для высокопроизводительных VLM без необходимости в масштабировании или структурных изменениях. Эта модель демонстрирует, что использование естественного языка в процессе дистилляции может существенно улучшить интерпретируемость и производительность в задачах визуального языка.

Перспективы

Будущие исследования могут сосредоточиться на расширении применения VLsI к различным архитектурам и задачам, а также на улучшении взаимодействия между большими и малыми VLM для достижения еще более высоких результатов.