VisionArena: Новая эра взаимодействия пользователей с моделями визуального языка

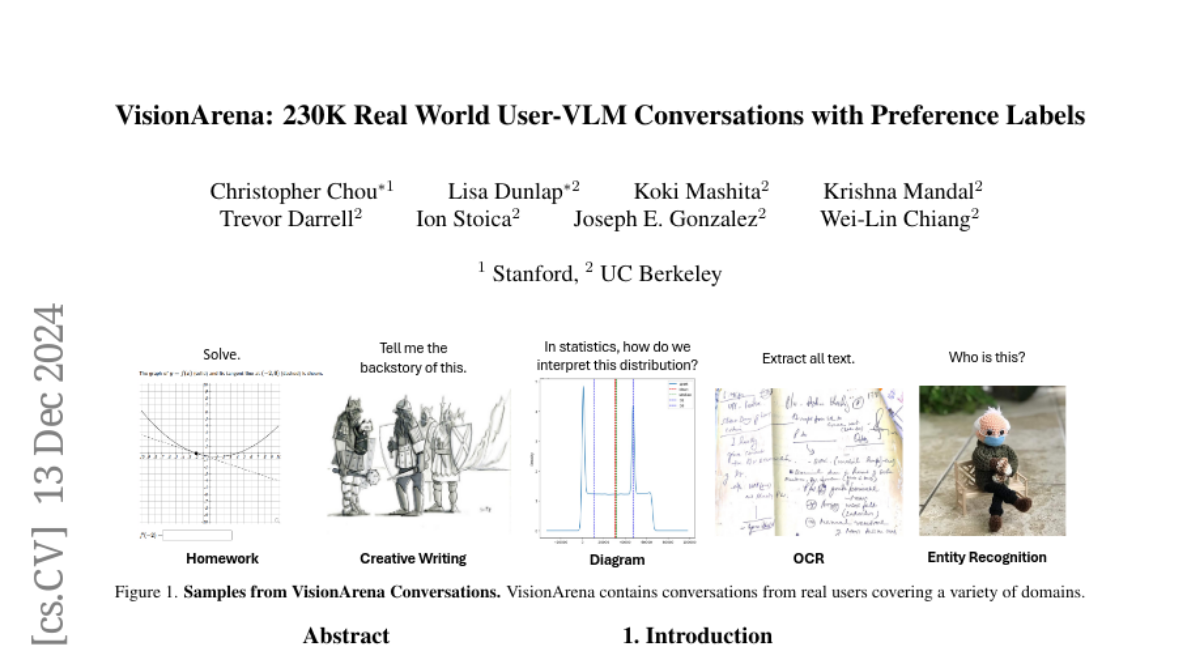

С ростом популярности и возможностей моделей визуального языка (VLM) появляется необходимость в создании стандартов, которые могут захватить аутентичные взаимодействия между пользователями и VLM. В ответ на эту потребность была создана база данных VisionArena, содержащая 230 000 реальных разговоров между пользователями и VLM. Эти данные были собраны на платформе Chatbot Arena, открытом источнике, где пользователи могут взаимодействовать с VLM и оставлять свои предпочтения.

VisionArena охватывает 73 000 уникальных пользователей, 45 VLM и 138 языков. Наша база данных состоит из трех подмножеств: VisionArena-Chat, VisionArena-Battle и VisionArena-Bench. Эти подмножества позволяют исследовать различные аспекты взаимодействия пользователей с VLM, включая влияние стиля ответа на предпочтения пользователей и области, где модели часто сталкиваются с трудностями.

Структура VisionArena

VisionArena-Chat

VisionArena-Chat включает 200 000 одно- и многоповоротных разговоров между пользователями и VLM. Эти разговоры охватывают широкий спектр запросов и ответов, что позволяет исследовать, как пользователи взаимодействуют с моделями в реальных условиях.

VisionArena-Battle

VisionArena-Battle состоит из 30 000 разговоров, в которых пользователи сравнивают два анонимных VLM и голосуют за предпочтительный ответ. Это позволяет получить более глубокое понимание того, какие модели предпочитают пользователи и почему.

VisionArena-Bench

VisionArena-Bench представляет собой автоматическую систему тестирования, состоящую из 500 разнообразных пользовательских запросов, которые могут быть использованы для быстрой оценки рангов моделей. Это позволяет исследователям эффективно оценивать производительность VLM без необходимости в длительных пользовательских исследованиях.

Анализ данных

Вопросы, задаваемые пользователями

В ходе анализа данных мы выделили несколько популярных категорий вопросов, таких как:

- Captioning: Запросы на описание изображений.

- OCR: Задачи, связанные с оптическим распознаванием текста.

- Humor: Вопросы, связанные с объяснением юмора в изображениях.

- Creative Writing: Запросы на создание креативных текстов, таких как истории или сценарии.

Эти категории помогают понять, как пользователи используют VLM для решения различных задач.

Влияние стиля ответа

Мы также исследовали, как стилистические свойства ответов, такие как длина ответа и специфичность, влияют на предпочтения пользователей. Открытые задачи, такие как captioning и humor, сильно зависят от стиля, что приводит к тому, что определенные модели, такие как InternVL, имеют непропорционально высокие рейтинги в этих категориях.

Области, где VLM сталкиваются с трудностями

Наш анализ также выявил распространенные ошибки VLM. Модели часто испытывают трудности с пространственным мышлением и планированием. Например, задачи, требующие сложного визуального понимания, такие как чтение и интерпретация искаженных изображений, остаются сложными для текущих VLM.

Улучшение VLM через инструктаж

Мы продемонстрировали, как VisionArena может быть использована для улучшения VLM через инструктаж. Сравнив результаты моделей, обученных на данных VisionArena-Chat, с LLaVA-Instruct-158K, мы обнаружили, что модели, обученные на VisionArena, показали значительное улучшение в производительности.

VisionArena-Bench: Автоматизированное тестирование

VisionArena-Bench позволяет быстро и недорого оценивать ранги моделей, что делает его полезным инструментом для разработчиков, стремящихся протестировать свои модели. Мы сравнили результаты VisionArena-Bench с существующими тестами и обнаружили, что наша система более точно отражает предпочтения пользователей.

Заключение

VisionArena представляет собой важный шаг вперед в понимании того, как люди взаимодействуют с VLM. Эта база данных и платформа создают основу для будущих исследований в области разработки и оценки VLM, помогая улучшить взаимодействие между пользователями и моделями. Мы надеемся на дальнейшие обновления и расширения базы данных, включая разнообразные модели и многокартинные разговоры.