Обучение универсального управления позами гуманоидных роботов на основе видео

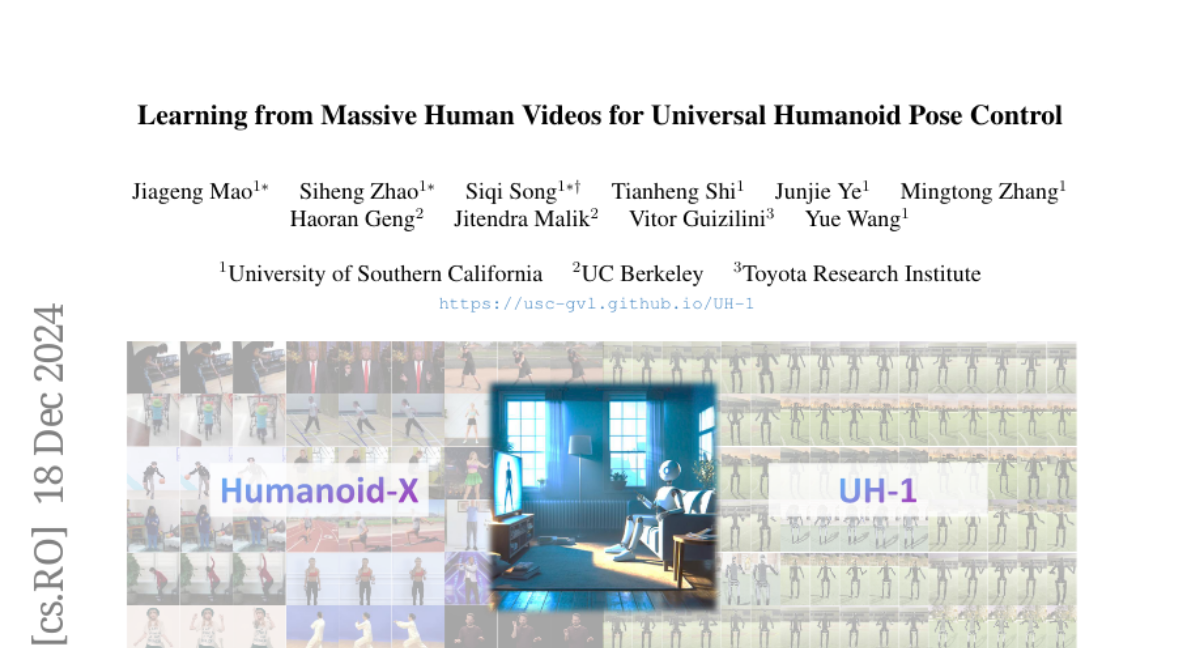

Масштабируемое обучение гуманоидных роботов является ключевым для их развертывания в реальных приложениях. Хотя традиционные подходы в основном полагаются на обучение с подкреплением или телеуправление для достижения полного контроля над телом, они часто ограничены разнообразием симулированных сред и высокими затратами на сбор демонстраций. Напротив, видеозаписи людей являются повсеместными и представляют собой неиспользуемый источник семантической и движенческой информации, который может значительно улучшить способности обобщения гуманоидных роботов. Эта статья представляет Humanoid-X, крупномасштабный набор данных, состоящий из более чем 20 миллионов поз гуманоидных роботов с соответствующими текстовыми описаниями движений, разработанный для того, чтобы использовать эти обильные данные. Humanoid-X создается через комплексный процесс: добыча данных из Интернета, генерация видеозаголовков, перенаправление движений людей на гуманоидных роботов и обучение политике для развертывания в реальном мире. С помощью Humanoid-X мы дополнительно обучаем большую гуманоидную модель, UH-1, которая принимает текстовые инструкции в качестве входных данных и выдает соответствующие действия для управления гуманоидным роботом. Обширные симулированные и реальные эксперименты подтверждают, что наш масштабируемый подход к обучению приводит к превосходному обобщению в текстовом управлении гуманоидом, что является значительным шагом к адаптивным гуманоидным роботам, готовым к реальному миру.