Естественное Языковое Усиление Обучения (NLRL): Введение в новый парадигм

В мире машинного обучения и искусственного интеллекта (AI) методы усиления обучения (RL) играют ключевую роль в обучении агентов принимать решения в динамических средах. Однако традиционные подходы к RL часто сталкиваются с проблемами, такими как отсутствие предварительных знаний о задаче, недостаточная интерпретируемость политики и нестабильность обучения, вызванная ограниченностью обратной связи в виде скалярных наград. В ответ на эти вызовы появился новый подход под названием Естественное Языковое Усиление Обучения (Natural Language Reinforcement Learning, NLRL), который стремится интегрировать богатство и гибкость естественного языка в процесс обучения RL.

Введение в NLRL

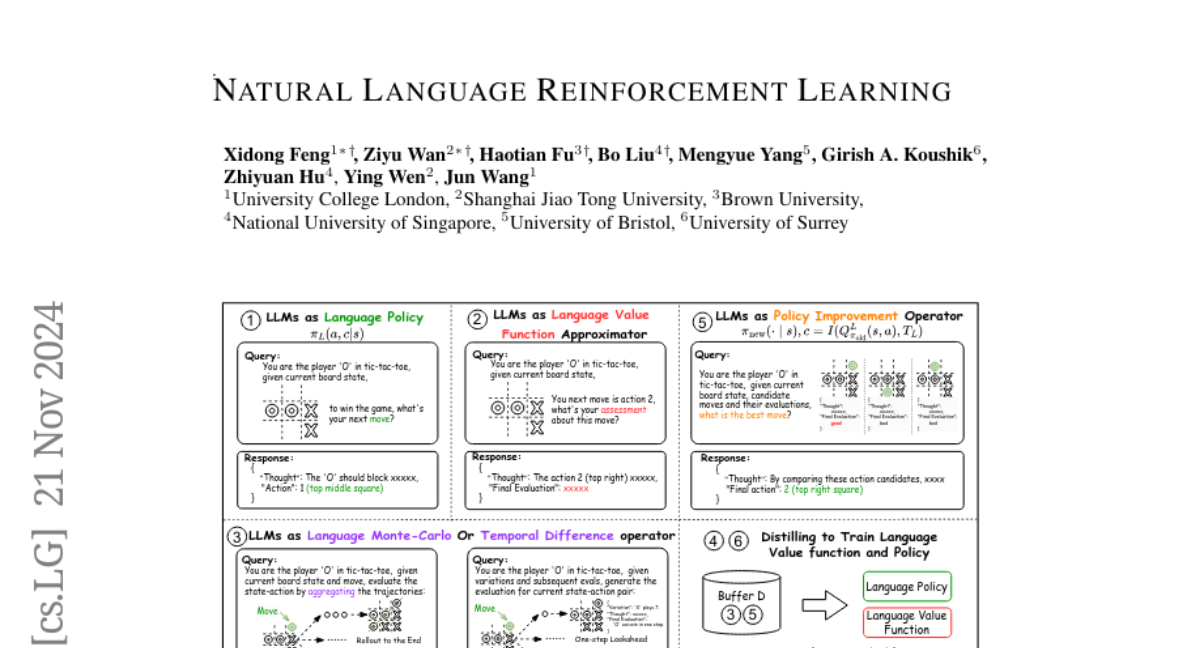

NLRL представляет собой попытку перенести принципы RL в пространство представлений на основе естественного языка. В этом новом парадигме основные элементы RL, такие как задачи, политики, функции стоимости и уравнение Беллмана, переосмысливаются через призму языковых конструкций. Это позволяет агентам не только принимать решения, но и объяснять их на естественном языке, что значительно повышает интерпретируемость и эффективность обучения.

Основные компоненты NLRL

-

Задачи и Цели: В NLRL задачи формулируются на естественном языке, что позволяет агентам лучше понимать и адаптироваться к поставленным целям.

-

Политики: Вместо прямого моделирования вероятностей действий, NLRL использует процесс мышления и планирования, включая стратегические размышления, логическое рассуждение и планирование, для определения действий.

-

Функции Стоимости: Функции стоимости в NLRL оценивают эффективность политики с помощью языковых описаний, а не скалярных значений, что дает более информативную и интерпретируемую оценку состояний и действий.

-

Уравнение Беллмана: В NLRL уравнение Беллмана также переосмысливается с учетом языковых описаний, где агрегация информации и оценка будущих состояний проводятся через языковые операторы.

Применение NLRL

Для практической реализации NLRL используются большие языковые модели (LLMs), которые способны понимать, обрабатывать и генерировать естественный язык. Эти модели могут выполнять различные роли:

-

Языковая Политика: LLM могут действовать как агенты, принимая решения и объясняя их на естественном языке.

-

Языковая Функция Стоимости: LLM могут оценивать состояния и действия, предоставляя языковые оценки их эффективности.

-

Операторы Монте-Карло и Временной Разности: LLM используются для агрегации и синтеза информации из различных траекторий или однократных переходов, что позволяет оценивать будущие состояния и действия.

-

Улучшение Политики: LLM анализируют языковые оценки, чтобы улучшить политику агента, выбирая наиболее перспективные действия.

Эксперименты и Результаты

Эксперименты, проведенные в рамках NLRL, демонстрируют его эффективность, эффективность и интерпретируемость в различных задачах, таких как игры в лабиринте, Breakthrough и Tic-Tac-Toe. Например, в игре Tic-Tac-Toe NLRL показал способность агента к стратегическому мышлению и принятию решений, что привело к улучшению результатов по сравнению с традиционными методами RL.

Заключение и Будущие Работы

NLRL открывает новые горизонты для понимания и реализации алгоритмов RL в пространстве естественного языка. Это направление исследований обещает улучшить эффективность, стабильность и интерпретируемость агентов RL, а также интегрировать RL с текущими достижениями в области языковых моделей и агентных систем. Однако перед NLRL стоят и определенные ограничения, такие как сложность работы с непрерывными пространствами действий и высокими измерениями состояний, а также вычислительные затраты, связанные с использованием больших языковых моделей. Будущие исследования могут быть направлены на разработку теоретических основ для NLRL, интеграцию с существующими методами самооценки и планирования, а также на расширение применения NLRL за пределы игровых задач.

Таким образом, NLRL представляет собой инновационный подход к усилению обучения, который может значительно улучшить способность агентов к принятию решений и взаимодействию с пользователями на естественном языке.