Gradient-Free Path Integral Control for Enhancing Text-to-Video Generation with Large Vision-Language Models

С развитием технологий генеративного моделирования, диффузионные модели стали мощным инструментом для синтеза контента, включая задачи текст-к-изображению (T2I) и текст-к-видео (T2V). Однако, несмотря на достижения, точное выравнивание текста в генерации видео остается значительной проблемой из-за сложных временных зависимостей между кадрами. Существующие подходы на основе обучения с подкреплением (RL) для улучшения текстового выравнивания часто требуют дифференцируемых функций вознаграждения или ограничены малым числом подсказок, что затрудняет их масштабируемость и применимость.

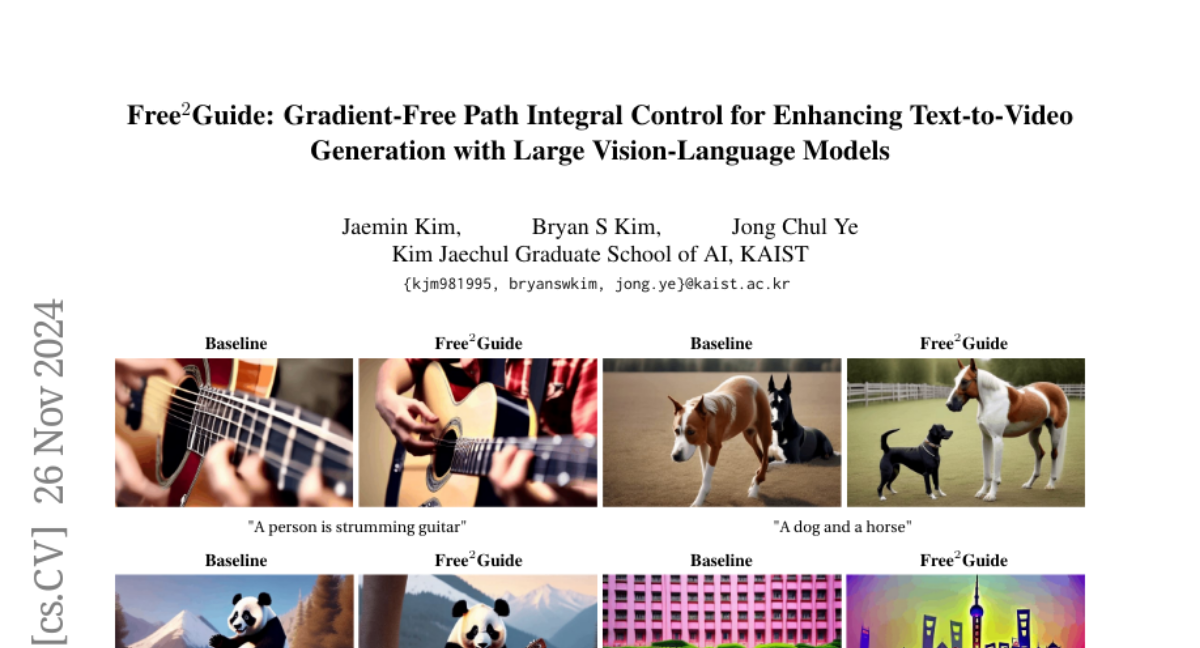

В данной статье мы представляем Free 2 Guide — новую градиентно-свободную рамку для выравнивания сгенерированных видео с текстовыми подсказками без необходимости дополнительного обучения модели. Используя принципы управления по интегралу пути, Free 2 Guide приближает руководство для диффузионных моделей, используя недифференцируемые функции вознаграждения, что позволяет интегрировать мощные черные ящики — большие модели языка и зрения (LVLM) в качестве моделей вознаграждения. Кроме того, наша рамка поддерживает гибкое объединение нескольких моделей вознаграждения, включая крупномасштабные модели на основе изображений, чтобы синергетически улучшить выравнивание без значительных вычислительных затрат.

Связанные работы

Модели диффузии для текста-видео

Модели диффузии для текста-видео, такие как LaVie и VideoCrafter, используют процессы диффузии для генерации последовательностей видео на основе текстовых подсказок. Однако заметным ограничением является то, что видеодиффузионные модели часто испытывают трудности с созданием видео, которые точно соответствуют данным текстовым подсказкам, особенно в терминах пространственных отношений и представления временного стиля.

Обратная связь от больших языковых моделей

Несмотря на то, что предложено несколько подходов для улучшения процесса генерации диффузии с помощью больших языковых моделей (LLM), исследование использования больших моделей языка и зрения (LVLM) остается ограниченным. Недавние работы исследуют интеграцию LVLM как механизма обратной связи для диффузионных моделей, чтобы улучшить контроль и руководство процессами диффузии.

Выравнивание предпочтений человека через модели вознаграждения

Выравнивание с человеческими предпочтениями улучшает качество генерации в диффузионных моделях через дообучение моделей диффузии с использованием градиентов моделей вознаграждения. Однако эти методы в основном сосредоточены на изображениях, и их применение к видео требует дополнительных трудностей, таких как необходимость в специализированных функциях вознаграждения для видео.

Принципы работы Free 2 Guide

Модель диффузии видео

Модель диффузии видео (VLDM) обучает стохастический процесс, постепенно уменьшая шум, создаваемый прямым процессом диффузии. VLDM минимизирует различие между истинным шумом и шумом, предсказанным моделью, чтобы получить чистое латентное представление.

Управление в модели диффузии

Целью является получение оптимального управления, которое направляет процесс выборки к целевому распределению, основанному на текстовых подсказках. Однако, традиционные методы, такие как управление классификатором, требуют наличия дифференцируемой функции вознаграждения, что ограничивает их применение.

Управление по интегралу пути

Мы используем подход управления по интегралу пути, который позволяет оценивать оптимальное управление, основываясь на принципах стохастического оптимального управления. Это позволяет избежать необходимости в градиенте функции вознаграждения, что делает подход более гибким и применимым к видео.

Метод: Free 2 Guide

Применение моделей вознаграждения на основе изображений для видео

Free 2 Guide использует модели вознаграждения, обученные на больших наборах данных текстов и изображений, чтобы оценить соответствие сгенерированного видео текстовым подсказкам. Мы адаптируем LVLM для оценки нескольких кадров одновременно, что позволяет модели учитывать временные аспекты.

Объединение функций вознаграждения

Мы исследуем методы объединения, которые позволяют LVLM учитывать временную информацию, что способствует более эффективному выравниванию видео. Мы предлагаем три метода объединения: взвешенная сумма, нормализованная сумма и консенсус.

Управление с использованием интеграла пути

Для управления обратным процессом выборки без вычисления градиента функции вознаграждения мы используем рамку, основанную на интеграле пути. Это позволяет эффективно направлять генерацию видео к лучшему соответствию с сигналами вознаграждения.

Эксперименты

Базовые модели и стратегия выборки

Мы используем открытые текстово-видео диффузионные модели LaVie и VideoCrafter как базовые модели. Генерируемые видео содержат 16 кадров с разрешением 320x512. Мы применяем LVLM, такие как GPT-4, для оценки соответствия текста и видео.

Оценка выравнивания текста

Мы проводим количественную оценку с использованием VBench, бенчмарка, разработанного для оценки выравнивания моделей T2V относительно текстовых подсказок. Оценка охватывает шесть аспектов: стиль внешнего вида, временной стиль, человеческое действие, множественные объекты, пространственные отношения и общая согласованность.

Оценка общего качества видео

Помимо выравнивания текста, мы оцениваем общее качество сгенерированных видео с использованием шести метрик: согласованность субъекта, согласованность фона, плавность движения, динамическая степень, эстетическое качество и качество изображения.

Результаты

Качественные результаты

Качественные сравнения показывают, что использование модели GPT-4 для оценки соответствия текста и видео улучшает выравнивание в отношении временной динамики и семантического представления. Мы наблюдаем, что LVLM может учитывать временные аспекты, обрабатывая несколько подкадров видео одновременно.

Количественные результаты

В количественных оценках мы подтверждаем, что интеграция LVLM последовательно превосходит конфигурации, которые его исключают. Особенно заметны улучшения в обработке пространственных отношений, где LVLM предоставляет дополнительные подсказки, которые помогают улучшить производительность.

Заключение и ограничения

В данной статье мы представили Free 2 Guide — новую градиентно-свободную рамку для улучшения выравнивания текста-видео в диффузионных генеративных моделях. Наши эксперименты показывают, что Free 2 Guide последовательно улучшает соответствие текстовым подсказкам и общее качество видео. Однако, несмотря на преимущества, использование нашего подхода может немного увеличить время выборки по сравнению с базовыми моделями. Тем не менее, это открывает новые возможности для дальнейших улучшений, поскольку модели вознаграждения продолжают развиваться.