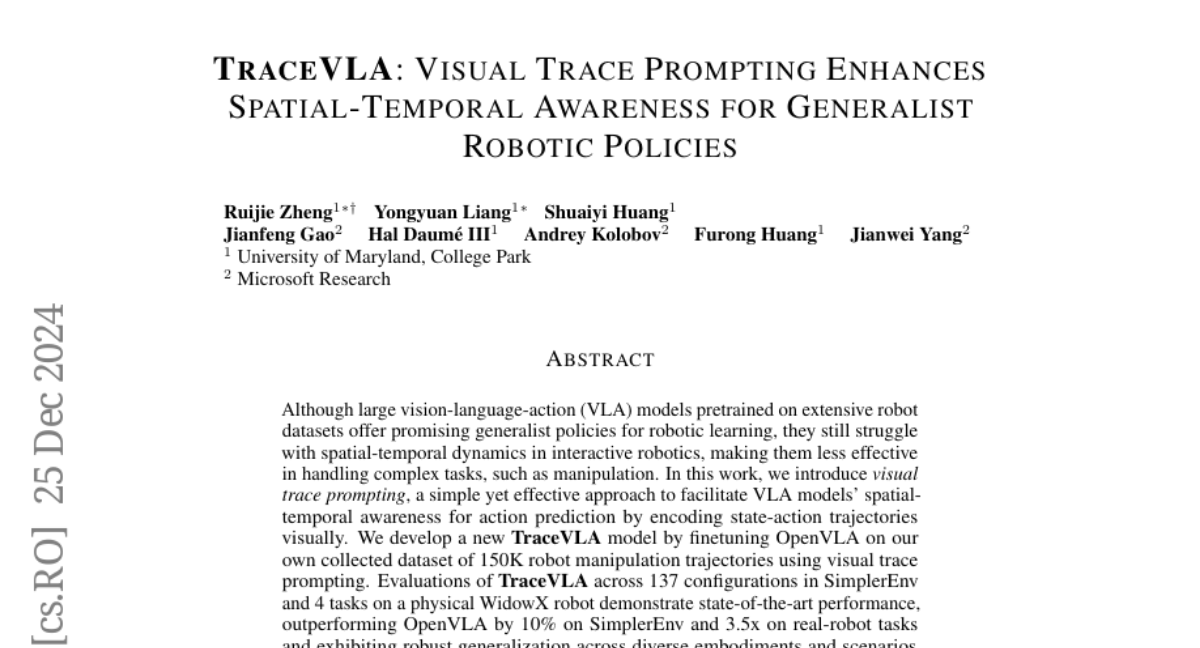

Улучшение пространственно-временной осведомленности моделей VLA с помощью визуального трассирования

Хотя крупные модели языка-видения-действия (VLA), предварительно обученные на обширных наборах данных роботов, предлагают многообещающие универсальные стратегии для обучения роботов, они всё ещё испытывают трудности с пространственно-временной динамикой в интерактивной робототехнике, что делает их менее эффективными в выполнении сложных задач, таких как манипуляция. В данной работе мы представляем визуальное отслеживание подсказок, простой но эффективный подход для содействия пространственно-временной осведомленности моделей VLA при предсказании действий путём визуального кодирования траекторий состояния-действия. Мы разработали новую модель TraceVLA, дообучив OpenVLA на собственно собранном наборе данных из 150 000 траекторий манипуляции роботов с использованием визуального отслеживания подсказок. Оценки TraceVLA на 137 конфигурациях в SimplerEnv и 4 задачах на физическом роботе WidowX демонстрируют передовые характеристики, превосходя OpenVLA на 10% в SimplerEnv и в 3,5 раза на задачах с реальными роботами, а также показывая надёжную генерализацию на различных воплощениях и сценариях. Для дальнейшей проверки эффективности и универсальности нашего метода мы представляем компактную модель VLA на основе 4B Phi-3-Vision, предварительно обученную на Open-X-Embodiment и дообученную на нашем наборе данных, которая соперничает с базовой моделью 7B OpenVLA, значительно улучшая эффективность вывода.