ColorFlow: Революция в цветизации изображений последовательностей

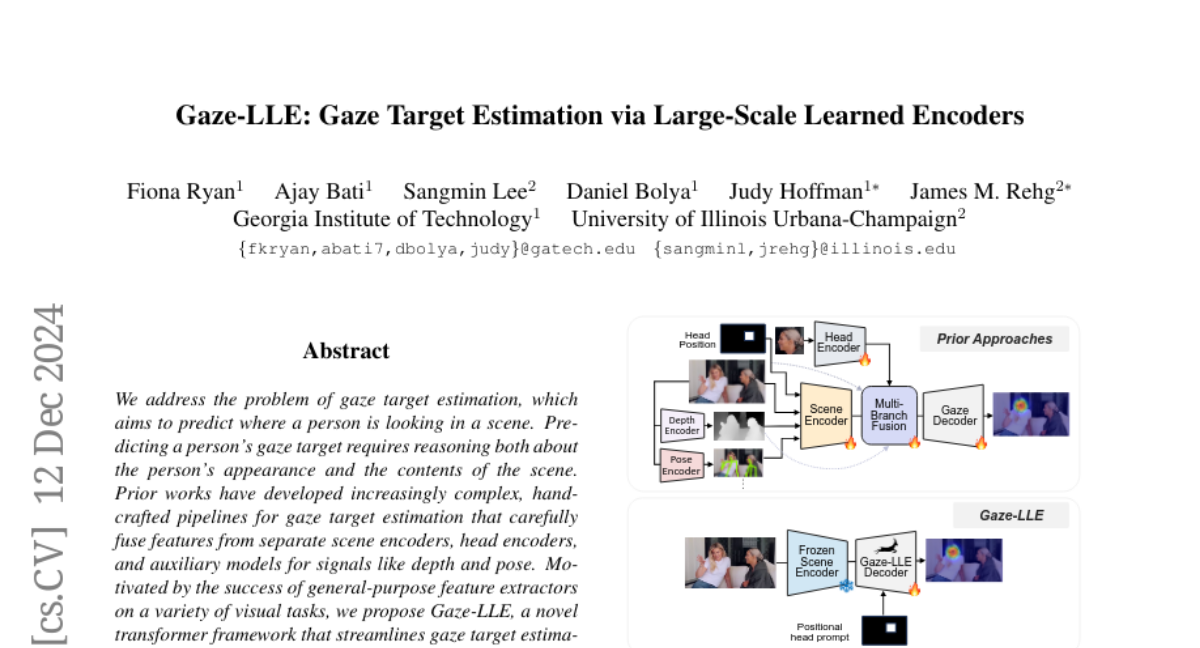

Автоматическая цветизация черно-белых последовательностей изображений с сохранением идентичности персонажей и объектов (ID) является сложной задачей с значительным спросом на рынке, например, для цветизации мультфильмов или комиксов. Несмотря на достижения в визуальной цветизации с использованием крупных генеративных моделей, таких как диффузионные модели, продолжают существовать проблемы с управляемостью и согласованностью идентичности, что делает существующие решения непригодными для промышленного применения. Чтобы решить эту задачу, мы предлагаем ColorFlow — трехэтапную диффузионную основу, адаптированную для цветизации последовательностей изображений в промышленном применении. В отличие от существующих методов, которые требуют дообучения на уровне ID или явной извлечения встраиваний ID, мы предлагаем новую надежную и обобщаемую цветизационную трубопроводную систему с использованием дополненной выборки для цветизации изображений с соответствующими цветовыми ссылками. Наша трубопроводная система также имеет двухветвевую конструкцию: одна ветвь для извлечения цветовой идентичности, а другая для цветизации, используя сильные стороны диффузионных моделей. Мы используем механизм самовнимания в диффузионных моделях для мощного обучения в контексте и сопоставления цветовой идентичности. Для оценки нашей модели мы представляем ColorFlow-Bench, комплексный эталон для цветизации на основе ссылок. Результаты показывают, что ColorFlow превосходит существующие модели по нескольким метрикам, устанавливая новый стандарт в последовательной цветизации изображений и потенциально принося пользу художественной индустрии. Мы публикуем наши коды и модели на нашей странице проекта: https://zhuang2002.github.io/ColorFlow/.