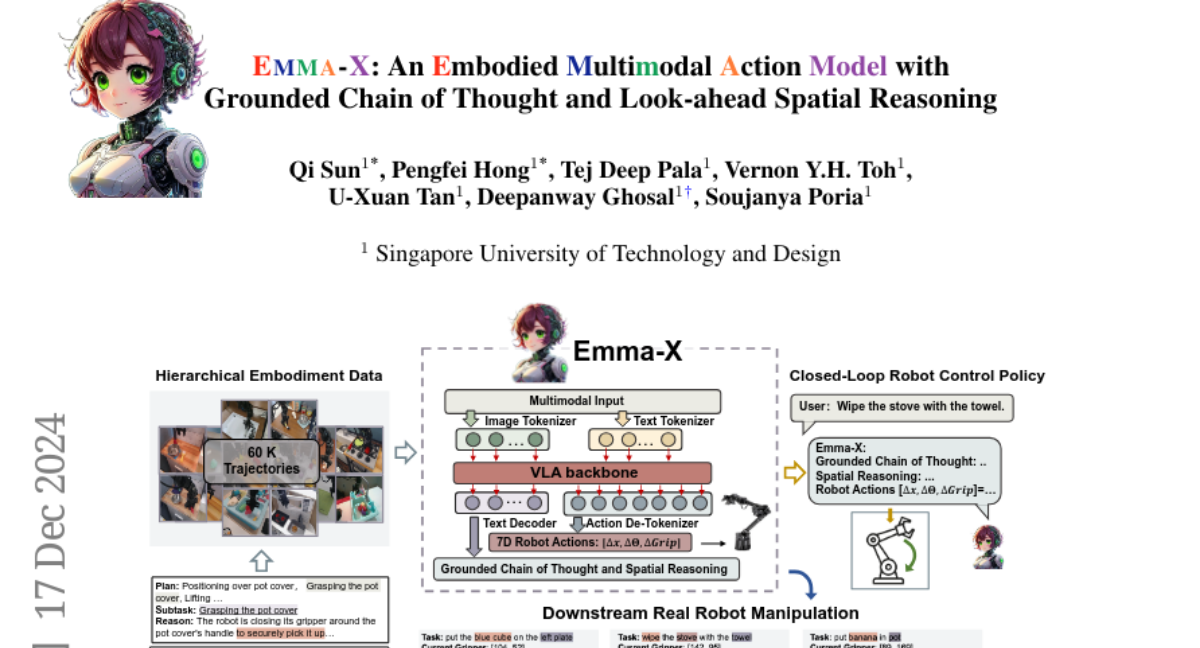

E,M,M,A,-,X: Модель многомодального действия с основанной цепочкой размышлений и пространственным прогнозированием

Традиционные методы управления роботами на основе обучения с подкреплением часто являются специфическими для задачи и не могут обобщаться на разнообразные среды или невидимые объекты и инструкции. Визуальные языковые модели (VLM) демонстрируют сильные способности к пониманию сцен и планированию, но им не хватает способности генерировать осуществимые политики, адаптированные для конкретных роботизированных тел. Чтобы решить эту проблему, появились модели визуально-языкового-действия (VLA), однако они сталкиваются с трудностями в пространственном рассуждении на дальних горизонтах и основанном на задачах планировании. В данной работе мы предлагаем Модель Эмбедированного Мультимодального Действия с Основанной Цепочкой Мыслей и Предварительным Пространственным Рассуждением, Emma-X. Emma-X использует наш конструктивный иерархический набор данных об эмбедировании на основе BridgeV2, содержащий 60,000 траекторий манипуляции роботов, автоаннотированных с обоснованным рассуждением по задачам и пространственным руководством. Кроме того, мы вводим стратегию сегментации траекторий на основе состояния захвата и траекторий движения, что может помочь смягчить галлюцинацию при генерации обоснованного рассуждения по подзадачам. Экспериментальные результаты демонстрируют, что Emma-X достигает превосходных результатов по сравнению с конкурентоспособными базовыми значениями, особенно в реальных роботизированных задачах, требующих пространственного рассуждения.