StreamChat: Интерактивное взаимодействие с потоковым видео

С недавним развитием больших языковых моделей (LLM) и больших мультимодальных моделей (LMM) открылись новые горизонты для применения в таких сценариях, как визуальное следование инструкциям и понимание длинных видео. Однако существующие методы взаимодействия с потоковым видео часто сталкиваются с проблемами, связанными с задержками и недостаточной адаптацией к динамическим изменениям в контенте. В этой статье мы рассмотрим новую модель StreamChat, которая решает эти проблемы и значительно улучшает взаимодействие с потоковым видео.

Проблемы существующих моделей

Существующие модели, работающие с потоковым видео, обычно используют визуальную информацию только до момента, когда задан вопрос. Это приводит к тому, что модель не может учитывать изменения, произошедшие в видео после того, как вопрос был задан. Например, если вопрос задается в момент времени t, а модель отвечает на него через t′ секунд, она будет использовать контент видео только до момента t, что может негативно сказаться на качестве ответа, особенно в динамичных видео-сценах.

StreamChat: Решение проблемы

StreamChat предлагает инновационный подход к динамическому взаимодействию с потоковым видео. Основная идея заключается в том, чтобы обновлять визуальный контекст на каждом этапе декодирования, позволяя модели использовать актуальную информацию из видео в процессе формирования ответа. Это обеспечивает более согласованные и точные ответы, соответствующие динамике видео.

Архитектура StreamChat

StreamChat использует архитектуру, основанную на механизме перекрестного внимания (cross-attention), что позволяет эффективно обрабатывать динамические визуальные входные данные. В этой архитектуре текстовые токены служат запросами, а визуальные токены - ключами и значениями. Это позволяет модели динамически обновлять визуальные токены в процессе взаимодействия, что существенно повышает эффективность обработки.

Механизм 3D-RoPE

Для лучшего кодирования временной информации в сценариях потокового взаимодействия StreamChat использует параллельный механизм 3D-RoPE. Этот механизм организует визуальные и текстовые токены параллельно, что позволяет им делить одно и то же временное положение. Это особенно важно для обеспечения согласованности и непрерывности во время потокового взаимодействия.

Обучение StreamChat

Новый набор данных инструкций

Для обучения моделей потокового взаимодействия был разработан новый плотный набор данных инструкций, который отличается от существующих наборов, ориентированных на оффлайн-понимание видео. В отличие от них, StreamChat требует, чтобы текстовые токены могли видеть только часть видео, что делает набор данных более подходящим для сценариев потокового взаимодействия.

Процесс обучения

В процессе обучения используются маски внимания, чтобы гарантировать, что токен текста в момент времени t не обращается к видеофреймам, происходящим после t. Это критически важно для поддержания временной целостности потокового взаимодействия и позволяет модели сосредоточиться только на релевантной визуальной информации, доступной на каждом этапе декодирования.

Экспериментальные результаты

StreamChat был протестирован на ряде стандартных бенчмарков для изображений и видео, а также на новом бенчмарке, созданном для оценки моделей в сценариях потокового взаимодействия. Результаты показывают, что StreamChat не только демонстрирует конкурентоспособную производительность на существующих бенчмарках, но и значительно превосходит другие модели в сценариях потокового взаимодействия.

Количественные результаты

StreamChat-7B продемонстрировал равные или лучшие результаты по сравнению с LLaVA-Video-72B, несмотря на то, что использовал значительно меньшую модель. Это подчеркивает важность захвата динамики видео во время потокового взаимодействия.

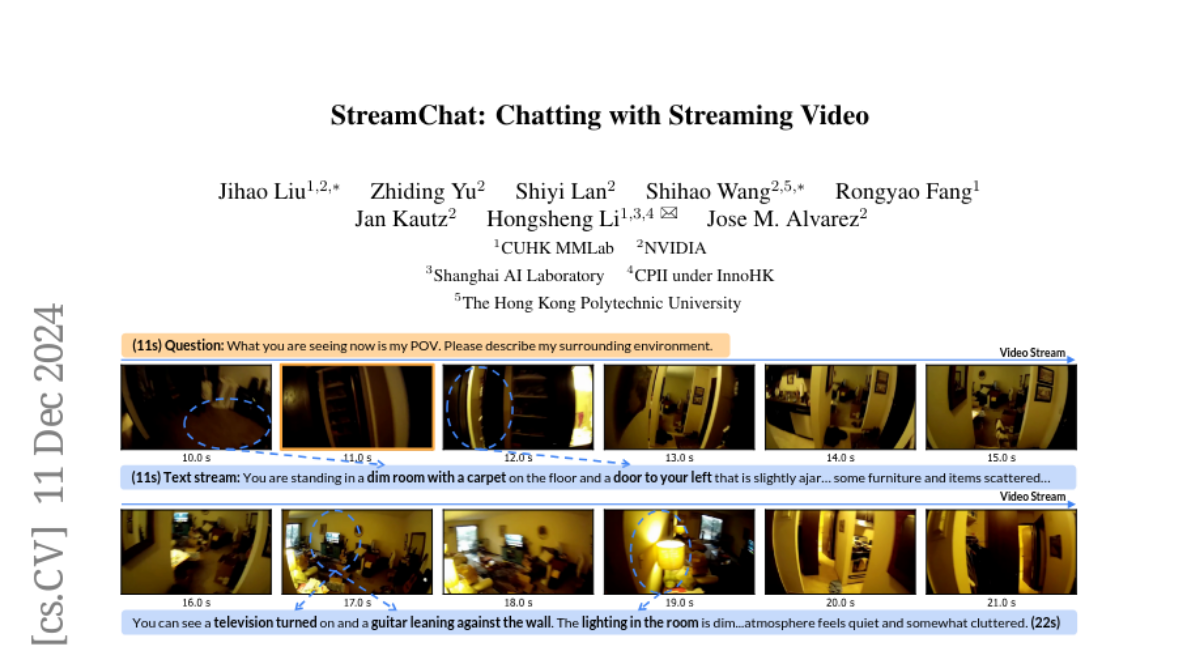

Качественные результаты

Качественная оценка StreamChat показала, что модель может динамически обновлять свой визуальный контекст в соответствии с изменениями в видео. В отличие от других моделей, таких как VILA и LLaVA-Video, StreamChat способен точно адаптировать свои ответы в зависимости от текущего содержания видео.

Заключение

StreamChat представляет собой значительный шаг вперед в области взаимодействия с потоковым видео. Используя гибкую и эффективную архитектуру на основе перекрестного внимания, а также новый набор данных для обучения, StreamChat обеспечивает более точные и актуальные ответы в сценариях потокового взаимодействия. Результаты экспериментов показывают, что эта модель не только превосходит существующие решения, но и открывает новые возможности для применения LMM в динамичных средах.

Ограничения и будущее

Несмотря на значительные достижения, StreamChat имеет свои ограничения. Одним из них является использование эвристического подхода для генерации временных меток для текстовых токенов, что может привести к неточностям в времальном выравнивании, особенно в сложных видео-сценах. Будущее разработки StreamChat будет сосредоточено на улучшении точности временных меток и расширении возможностей взаимодействия с потоковым видео.