BlueLM-V-3B: Алгоритм и системный дизайн для мультимодальных крупных языковых моделей на мобильных устройствах

Крупные языковые модели (LLM) и мультимодальные крупные языковые модели (MLLM) демонстрируют значительный потенциал для улучшения различных аспектов повседневной жизни, от улучшения коммуникации до облегчения обучения и решения проблем. Мобильные телефоны, являясь неотъемлемыми спутниками в нашей повседневной жизни, представляют собой наиболее эффективную и доступную платформу для развертывания MLLM, обеспечивая их бесшовную интеграцию в повседневные задачи. Однако развертывание MLLM на мобильных устройствах сталкивается с рядом проблем из-за ограничений в объеме памяти и вычислительных возможностях, что затрудняет достижение плавной и реального времени обработки без значительной оптимизации.

В этой статье мы представляем BlueLM-V-3B, подход к алгоритмическому и системному дизайну, специально адаптированный для эффективного развертывания MLLM на мобильных платформах. Мы переосмыслили динамическую схему разрешения, принятую в основных MLLM, и внедрили системные оптимизации для развертывания, ориентированного на аппаратное обеспечение, чтобы оптимизировать вывод модели на мобильных телефонах. BlueLM-V-3B выделяется следующими ключевыми особенностями:

- Малый размер: BlueLM-V-3B включает языковую модель с 2.7B параметров и визуальный энкодер с 400M параметров.

- Высокая скорость: BlueLM-V-3B достигает скорости генерации 24.4 токенов в секунду на процессоре MediaTek Dimensity 9300 с 4-битной квантизацией весов LLM.

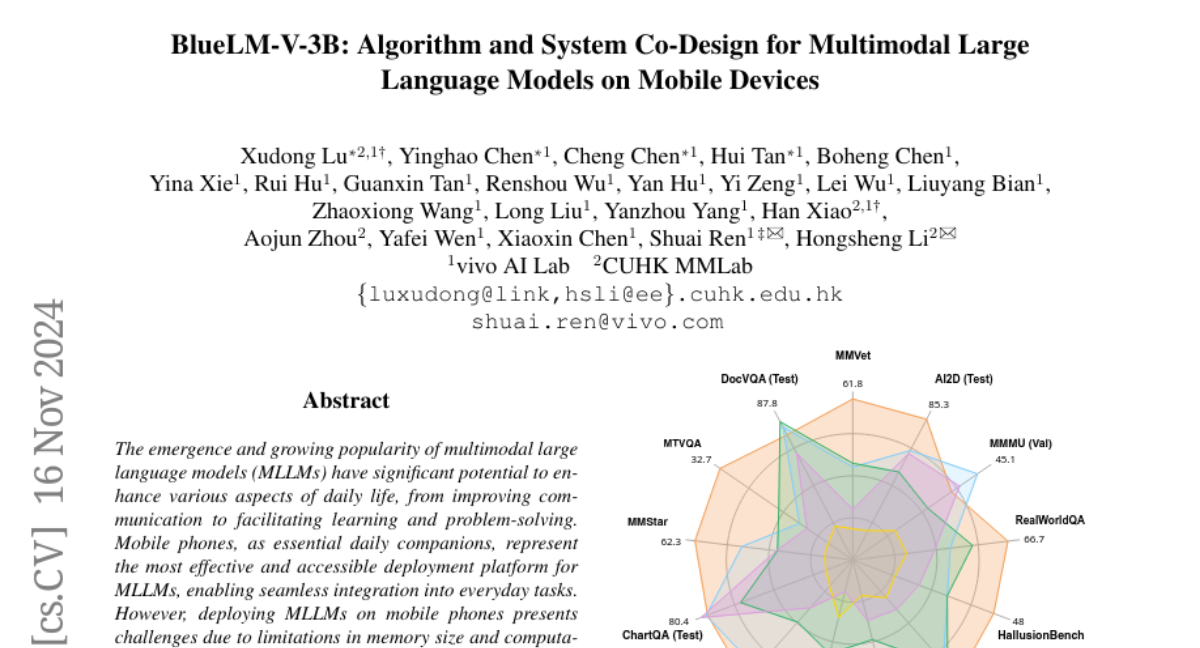

- Сильная производительность: BlueLM-V-3B достигла наивысшего среднего балла 66.1 на бенчмарке OpenCompass среди моделей с ≤ 4B параметров и превзошла ряд моделей с значительно большим размером параметров (например, MiniCPM-V-2.6, InternVL2-8B).

Основные компоненты сети

Архитектура модели

Архитектура BlueLM-V-3B основана на классическом подходе LLaVA, который показал свою эффективность в предыдущих работах, таких как InternVL 1.5 и LLaVA-NeXT. Основные компоненты включают:

- Визуальный энкодер: Для обработки мультимодальных (изображений и текста) входов мы используем SigLIP, ViT для изображений размером 384×384, который имеет 400M параметров.

- MLP Projector: Двухслойный MLP используется для отображения пространства токенов изображений в токены LLM.

- LLM: Мы используем внутреннюю модель BlueLM с 2.7B параметрами в качестве ядра языковой модели для разработки BlueLM-V-3B. Для улучшения способности модели понимать изображения высокого разрешения, мы интегрируем модуль динамической обработки разрешения.

Тренировка и вывод

Во время тренировки визуальный энкодер получает входные изображения, обработанные динамическим процессором разрешения. Выходные признаки проходят через модуль уменьшения токенов и MLP Projector, чтобы получить соответствующие токены изображения. Эти токены затем объединяются с языковыми инструкциями, предоставленными пользователем, для обучения модели.

Для вывода изображения и текстовые токены получаются аналогичным образом (с инструкциями пользователя в аудио формате, которые сначала преобразуются в текст), и модель генерирует последующие токены в автопрогрессивном режиме.

Динамическое разрешение изображения

Оригинальный ViT LLaVA напрямую изменяет размер входных изображений до фиксированного разрешения (например, 336×336 или 384×384), что не подходит для изображений высокого разрешения. Для решения этой проблемы, BlueLM-V-3B принимает дизайн динамического разрешения изображения, который был доказан эффективным в InternVL 1.5 и LLaVA-NeXT. Мы наблюдаем проблему чрезмерного увеличения изображения в этих двух методах и вносим улучшения для лучшего обучения и более легкого развертывания.

Чрезмерное увеличение изображения

LLaVA-NeXT и InternVL 1.5 оба предлагают подходы динамического разрешения для работы с изображениями высокого разрешения. Для энкодера SigLIP оба подхода используют 384×384 в качестве базового разрешения (1:1), затем выбирают соответствующее соотношение сторон (m:n), чтобы изменить размер (и заполнить) оригинальное изображение до размера 384m×384n. Изображение затем делится на патчи размером 384×384.

- LLaVA-NeXT: Тенденция выбирать соотношения сторон, которые приводят к большему изображению, чем оригинальное, но с меньшей общей площадью.

- InternVL 1.5: Выбор соотношений сторон, которые соответствуют ширине и высоте оригинального изображения.

Мы используем примеры в Fig. 3 для демонстрации чрезмерного увеличения изображения двумя методами. Для LLaVA-NeXT, при заданном изображении с разрешением 394×390, оно выберет соотношение 2:2, затем изменит размер и заполнит оригинальное изображение до 768×768 (увеличение площади в 4 раза). Для InternVL 1.5, при заданном изображении с разрешением 380×76 (установка max_num=6, т.е. m×n≤6), оно выберет соотношение 5:1, затем напрямую изменит размер оригинального изображения до 1920×384 (увеличение в 25 раз).

Расслабленное сопоставление соотношения сторон

Мы предлагаем метод расслабленного сопоставления соотношения сторон, основанный на LLaVA-NeXT, для смягчения проблемы чрезмерного увеличения изображения. LLaVA-NeXT определяет эффективное разрешение R_e и потраченное разрешение R_w. Для соотношений сторон (m:n), которые приводят к разрешению изображения 384m×384n меньше, чем оригинальное изображение по любому из измерений, R_e определяется как максимальная площадь изображения, масштабируемая пропорционально для размещения в размерах 384m×384n. В противном случае, R_e устанавливается как площадь оригинального изображения. После получения R_e, R_w вычисляется как 384m×384n - R_e.

LLaVA-NeXT исследует возможные соотношения сторон и ищет наибольшее R_e при минимизации R_w. Обычно доступны большие опции соотношения сторон, потому что m и n всегда устанавливаются на большие значения для адаптации к изображениям высокого разрешения (например, от 1:1 до 6:6 в LLaVA-OneVision). В этом контексте LLaVA-NeXT часто приводит к увеличению изображения, выбирая соотношение сторон, которое предлагает более высокое разрешение, чем оригинальное изображение.

Учитывая, что большие разрешения (в 4 раза) не обязательно предоставляют дополнительную информацию, но увеличивают сложность обучения и развертывания, уменьшение размера изображения является более подходящим выбором. Мы предлагаем метод расслабленного сопоставления соотношения сторон, используя порог для предотвращения тенденции всегда выбирать большие разрешения.

Заключение

BlueLM-V-3B представляет собой значительный шаг вперед в области развертывания MLLM на мобильных устройствах, обеспечивая баланс между производительностью и эффективностью. Этот подход к алгоритмическому и системному дизайну не только улучшает возможности модели, но и делает ее доступной для широкого круга пользователей, открывая новые горизонты в использовании AI на мобильных платформах.