LiFT: Использование человеческой обратной связи для выравнивания моделей текст-видео

С недавними достижениями в области генеративных моделей текст-видео (T2V) наблюдаются впечатляющие результаты в создании высококачественных видеоматериалов. Эти модели позволяют пользователям генерировать динамические видео на основе текстовых описаний, предоставляя гибкий и управляемый подход к созданию видео. Тем не менее, несмотря на этот прогресс, существующие модели все еще сталкиваются с проблемами, такими как артефакты, несоответствие текстовым описаниям и неестественное движение. Эти проблемы возникают из-за субъективных человеческих предпочтений, которые сложно формализовать в виде объективных функций.

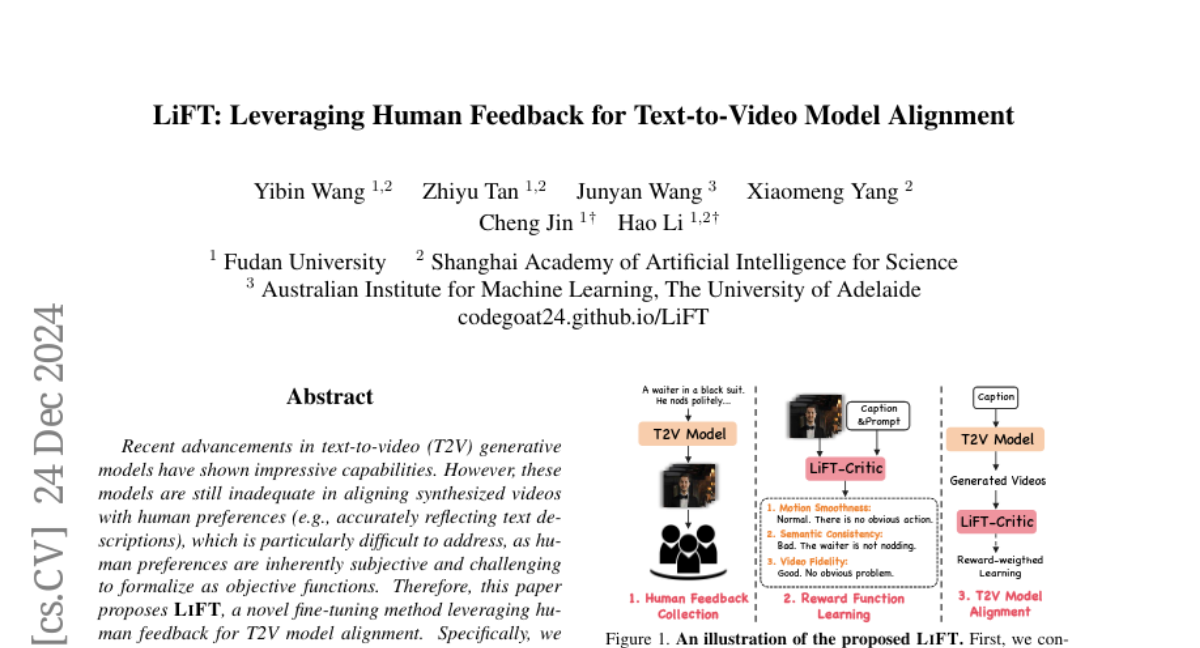

В данной статье предлагается метод LiFT, который представляет собой новый подход к тонкой настройке моделей T2V, используя человеческую обратную связь для выравнивания моделей. Метод включает три ключевых этапа: сбор обратной связи от людей, обучение функции вознаграждения и выравнивание модели T2V.

1. Сбор человеческой обратной связи

Первый этап включает создание обширного набора данных обратной связи от людей, называемого LIFT-HRA. Этот набор данных состоит из примерно 10 000 аннотаций, каждая из которых включает в себя оценку и соответствующее объяснение. Для сбора данных используются видеопары текстов, которые генерируются с помощью предварительно обученной языковой модели (LLM). Аннотаторы оценивают каждую пару видео-текст по трем ключевым измерениям: семантической согласованности, плавности движения и видеофиделити.

1.1 Аннотация данных

Аннотация включает в себя оценку видео по трем измерениям:

- Семантическая согласованность: Соответствие между текстовым описанием и визуальным содержанием.

- Плавность движения: Естественность и непрерывность движения в видео.

- Видеофиделити: Общая визуальная качество видео.

Аннотаторы оценивают каждое видео, присваивая ему одну из трех категорий: "Хорошо", "Нормально" или "Плохо", и предоставляют подробное объяснение своей оценки. Этот процесс позволяет глубже понять, какие именно аспекты видео вызывают положительные или отрицательные оценки.

1.2 Очистка данных

После аннотирования данных проводится трехступенчатый процесс очистки, который включает:

- Грубая фильтрация: Удаление данных с явными ошибками аннотации.

- Итеративная доработка: Разделение набора данных на две части для обучения начальной модели вознаграждения и последующей аннотации оставшейся части.

- Финальная интеграция: Обучение окончательной модели вознаграждения с использованием очищенного набора данных.

В результате получается надежный набор данных, который можно использовать для обучения модели вознаграждения.

2. Обучение функции вознаграждения

На втором этапе разрабатывается модель вознаграждения, называемая LIFT-CRITIC. Эта модель обучается на основе собранных данных, чтобы предсказать оценки человеческой обратной связи и предоставить объяснения. Модель не только предсказывает оценки, но и захватывает причины, стоящие за ними, что улучшает интерпретируемость и понимание процесса оценки.

2.1 Архитектура модели

Модель LIFT-CRITIC основана на мультимодальной модели (LMM), которая обучается для предсказания оценок по трем измерениям. Существует два основных подхода к обучению модели:

- Регрессионная голова: Модель обучается для прямого предсказания оценок.

- Преобразование оценок в текстовые метки: Модель предсказывает текстовые метки (например, "хорошо", "нормально", "плохо") и генерирует объяснения.

Выбор второго подхода позволяет модели лучше учитывать сложность человеческого суждения и улучшает ее интерпретируемость.

2.2 Обучение модели

Обучение модели включает в себя использование триплетов данных, состоящих из мультимодального ввода (видео и текстовое описание), вопроса и ответа. Оптимизационная цель — минимизация потерь, что позволяет модели лучше понимать, какие аспекты видео влияют на его оценку.

3. Выравнивание модели T2V

На третьем этапе используется обученная функция вознаграждения для выравнивания модели T2V. Это достигается через максимизацию взвешенной функции правдоподобия, что позволяет модели генерировать видео, которые лучше соответствуют человеческим ожиданиям.

3.1 Подход к выравниванию

Выравнивание модели T2V включает в себя использование функции вознаграждения для обновления параметров модели. Это достигается путем минимизации потерь, которые зависят от оценок, присвоенных сгенерированным видео. Первое слагаемое в функции потерь поощряет модель генерировать видео, которые получают более высокие оценки, в то время как второе слагаемое служит регуляризатором, основанным на реальных данных.

3.2 Эффективность метода

Эксперименты показывают, что использование метода LiFT значительно улучшает качество синтезируемых видео. В частности, модель, обученная с использованием LIFT-CRITIC, превосходит базовую модель CogVideoX-5B по всем 16 метрикам, что подчеркивает потенциал человеческой обратной связи для улучшения выравнивания и качества синтезируемых видео.

4. Эксперименты

4.1 Установка экспериментов

Для оценки эффективности предложенного подхода были проведены эксперименты с использованием различных моделей и наборов данных. Модель LIFT-CRITIC была адаптирована для конкретных задач оценки, и все модели были обучены на мощных графических процессорах.

4.2 Количественные результаты

Результаты экспериментов показывают, что интеграция обучения вознаграждения с использованием LIFT-CRITIC приводит к значительным улучшениям по всем метрикам оценки. Например, модель, обученная с использованием LIFT-CRITIC, показывает улучшения в "Согласованности субъекта" и "Плавности движения", что указывает на лучшее выравнивание с человеческими предпочтениями.

4.3 Качественные результаты

Визуальные сравнения результатов показывают, что модель, обученная с использованием LiFT, генерирует видео с лучшей семантической согласованностью и плавностью движения. Эти примеры подчеркивают эффективность подхода в выравнивании сгенерированного видео с текстовым описанием и ожиданиями человека.

Заключение

В данной работе представлен новый подход к выравниванию моделей T2V с использованием человеческой обратной связи, который включает в себя создание набора данных LIFT-HRA и обучение модели вознаграждения LIFT-CRITIC. Результаты экспериментов демонстрируют, что предложенный метод значительно улучшает качество синтезируемых видео и выравнивание с человеческими ожиданиями. Этот подход открывает новые возможности для дальнейших исследований в области генерации видео и взаимодействия человека с искусственным интеллектом.