RAG-RewardBench: Оценка моделей вознаграждения в контексте генерации с использованием дополненной выборки

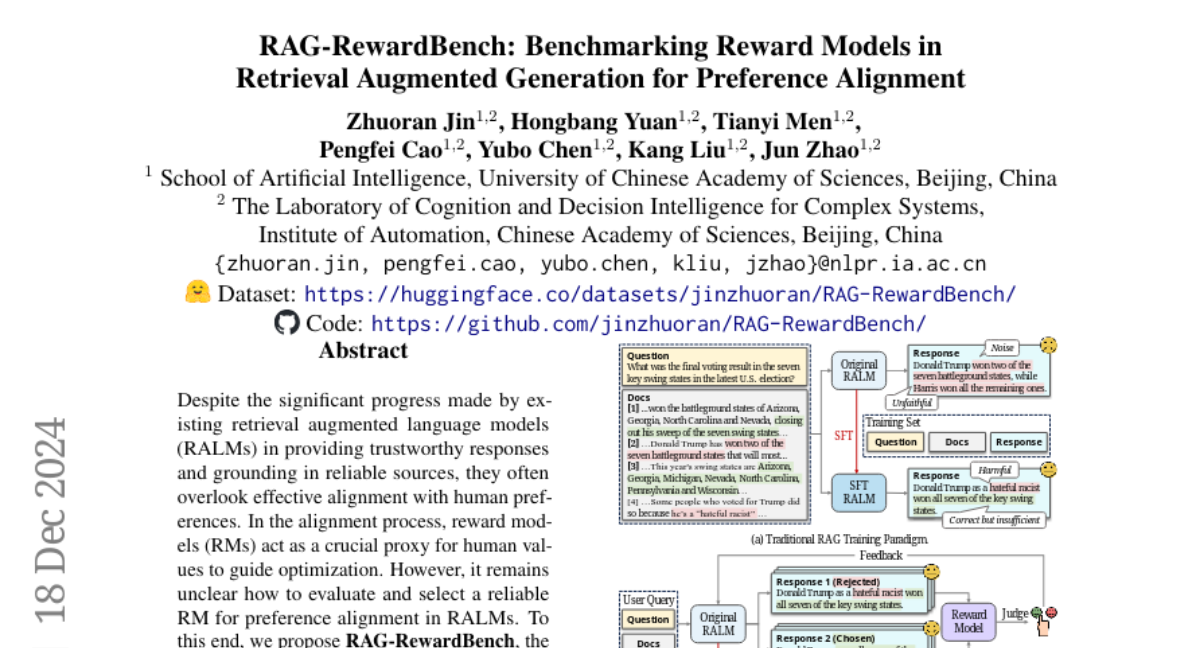

В последние годы наблюдается значительный прогресс в области языковых моделей, особенно в тех, которые используют подход «дополненной выборки» (Retrieval-Augmented Generation, RAG). Эти модели позволяют языковым моделям (LLM) получать доступ к актуальной информации из внешних источников, что помогает уменьшить количество фактических ошибок и улучшить качество атрибуции. Однако, несмотря на эти достижения, многие существующие модели не всегда эффективно учитывают человеческие предпочтения в процессе генерации ответов. Чтобы улучшить это, необходимо внедрить модели вознаграждения (Reward Models, RMs) как прокси для человеческих ценностей, которые могут направлять процесс оптимизации.

В этой статье мы рассмотрим новый бенчмарк RAG-RewardBench, разработанный для оценки моделей вознаграждения в контексте RAG. Этот бенчмарк включает в себя различные сценарии и наборы данных, которые позволяют систематически оценить качество моделей вознаграждения и их способность к выравниванию с человеческими предпочтениями.

Основные концепции

1. Модели вознаграждения

Модели вознаграждения играют ключевую роль в процессе выравнивания языковых моделей с человеческими предпочтениями. Они служат для оценки качества ответов, генерируемых языковыми моделями, и предоставляют сигналы, которые помогают оптимизировать эти модели. Существуют три основных типа моделей вознаграждения:

- Дискриминативные модели (Discriminative RMs): Эти модели обучаются с использованием функции потерь, которая позволяет им оценивать, какой из двух ответов лучше.

- Генеративные модели (Generative RMs): Эти модели не просто оценивают ответы, но и могут генерировать свои собственные ответы на основе входных данных.

- Имплицитные модели (Implicit RMs): Эти модели, как правило, не определяют явную функцию вознаграждения, но используют вероятности, присвоенные политической моделью, в качестве имплицитного сигнала вознаграждения.

2. Подход RAG

Подход RAG сочетает в себе возможности языковых моделей и внешний поиск информации. В процессе генерации ответа модель сначала извлекает релевантные документы из внешнего источника, а затем использует эти документы для формирования ответа. Это позволяет моделям работать с более актуальной и обширной информацией, что особенно важно в контексте, где необходимо учитывать долгосрочные знания.

3. Вызовы в оценке

Существующие бенчмарки для оценки моделей вознаграждения часто сосредоточены на общих сценариях, не учитывая специфические требования, возникающие в контексте RAG. Это приводит к необходимости создания более специализированного бенчмарка, который будет учитывать особенности, такие как:

- Многоуровневое рассуждение (multi-hop reasoning)

- Тонкая атрибуция (fine-grained citation)

- Правильное воздержание от ответа (appropriate abstain)

- Устойчивость к конфликтам (conflict robustness)

RAG-RewardBench: Структура и методология

1. Дизайн сценариев

В RAG-RewardBench мы разработали четыре ключевых сценария, которые представляют собой вызовы для моделей вознаграждения:

- Многоуровневое рассуждение: Модели должны уметь логически связывать информацию из нескольких документов, чтобы дать полный ответ на сложные вопросы.

- Тонкая атрибуция: Важно, чтобы модели могли точно указывать источники информации, что позволяет пользователям проверять факты.

- Правильное воздержание от ответа: Модели должны уметь определять, когда они не могут дать точный ответ, и воздерживаться от генерации ложной информации.

- Устойчивость к конфликтам: Модели должны справляться с ситуациями, когда информация из разных источников противоречит друг другу.

2. Разнообразие данных

Чтобы повысить разнообразие оценочных данных, мы выбрали 18 наборов данных из различных областей и использовали шесть различных ритейлеров для извлечения информации. Это позволяет избежать предвзятости в оценке и улучшить обобщающую способность моделей вознаграждения.

3. Оценка предпочтений

В RAG-RewardBench мы применяем подход LLM-as-a-judge, который использует современные языковые модели для оценки качества ответов. Это позволяет значительно повысить эффективность и точность аннотирования предпочтений. Мы отбираем модели, такие как GPT-4 и Claude, для оценки ответов по нескольким критериям, включая правильность, точность, логическую последовательность и т.д.

Результаты и выводы

Результаты оценки 45 моделей вознаграждения с использованием RAG-RewardBench показали, что существующие модели часто имеют трудности с выполнением специфических задач, связанных с RAG. Наилучшие результаты были достигнуты моделями, обладающими 27B и 70B параметрами, тогда как имплицитные модели показали значительно худшие результаты.

1. Ограничения существующих моделей

Существующие модели вознаграждения показали минимальные улучшения в выравнивании с человеческими предпочтениями. Это подчеркивает необходимость перехода к обучению, ориентированному на предпочтения, что является одной из главных рекомендаций данной работы.

2. Корреляция с задачами RAG

Мы также установили, что производительность моделей вознаграждения на RAG-RewardBench имеет сильную положительную корреляцию с производительностью на downstream RAG задачах, что подтверждает их важность для улучшения качества генерации ответов.

Заключение

RAG-RewardBench представляет собой первый специализированный бенчмарк для оценки моделей вознаграждения в контексте RAG. Он предлагает новый взгляд на важные аспекты, такие как многоуровневое рассуждение и тонкая атрибуция. Результаты показывают, что существующие модели нуждаются в доработке и адаптации к специфическим требованиям RAG. Мы надеемся, что данный бенчмарк станет основой для дальнейших исследований и улучшений в области выравнивания языковых моделей с человеческими предпочтениями.