Chimera: Улучшение универсальной модели с помощью специализированных экспертов

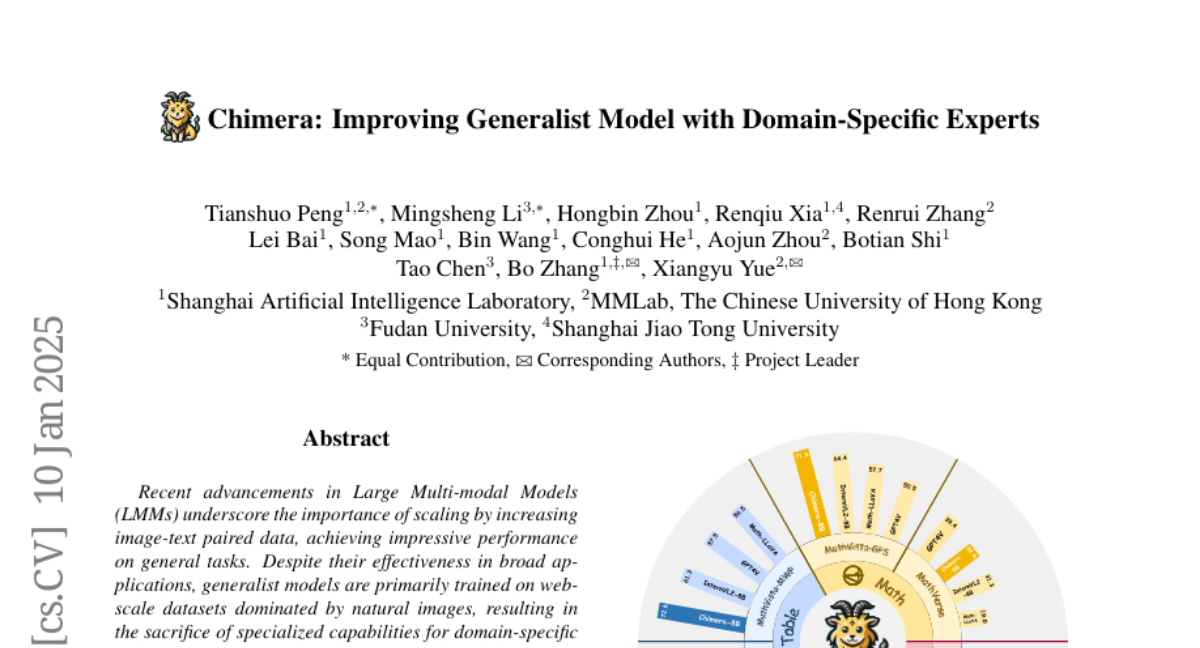

Недавние достижения в области крупных мультимодальных моделей (LMM) подчеркивают важность масштабирования за счет увеличения объема парных данных изображений и текста, что приводит к впечатляющим результатам в общих задачах. Несмотря на их эффективность в широких приложениях, общие модели в основном обучаются на датасетах веб-масштаба, доминирующих естественными изображениями, что приводит к жертве специализированными возможностями для задач, требующих обширных предварительных знаний в конкретной области. Более того, прямое интегрирование экспертных моделей, адаптированных для определенных областей, является сложной задачей из-за разрыва в представлении и дисбаланса оптимизации между общей моделью и экспертами. Чтобы решить эти проблемы, мы представляем Chimera, масштабируемый и недорогой мультимодальный конвейер, разработанный для повышения способности существующих LMM с помощью экспертов из конкретных областей. В частности, мы разрабатываем прогрессивную стратегию обучения для интеграции функций из экспертных моделей в ввод общей мультимодальной модели. Чтобы решить дисбаланс оптимизации, вызванный хорошо согласованным общим визуальным кодировщиком, мы вводим новый механизм сотрудничества между общими и специализированными моделями (GSCM). Это приводит к универсальной модели, которая превосходит по всем параметрам в областях графиков, таблиц, математики и документов, достигая состояния искусства в задачах мультимодального рассуждения и извлечения визуального содержания, обе из которых являются сложными задачами для оценки существующих LMM.