Адаптивный Инференс Мульти-Модальных LLM через Слияние и Обрезку Токенов

С недавним развитием больших языковых моделей (LLM) стало возможным создание мульти-модальных LLM, которые демонстрируют высокую способность к пониманию визуальных данных, таких как изображения и видео. Однако, несмотря на их успехи, эти модели часто требуют значительных вычислительных ресурсов из-за большого количества визуальных токенов, генерируемых визуальными энкодерами. Это ограничивает их применение в условиях ограниченных ресурсов и для задач с длинным контекстом.

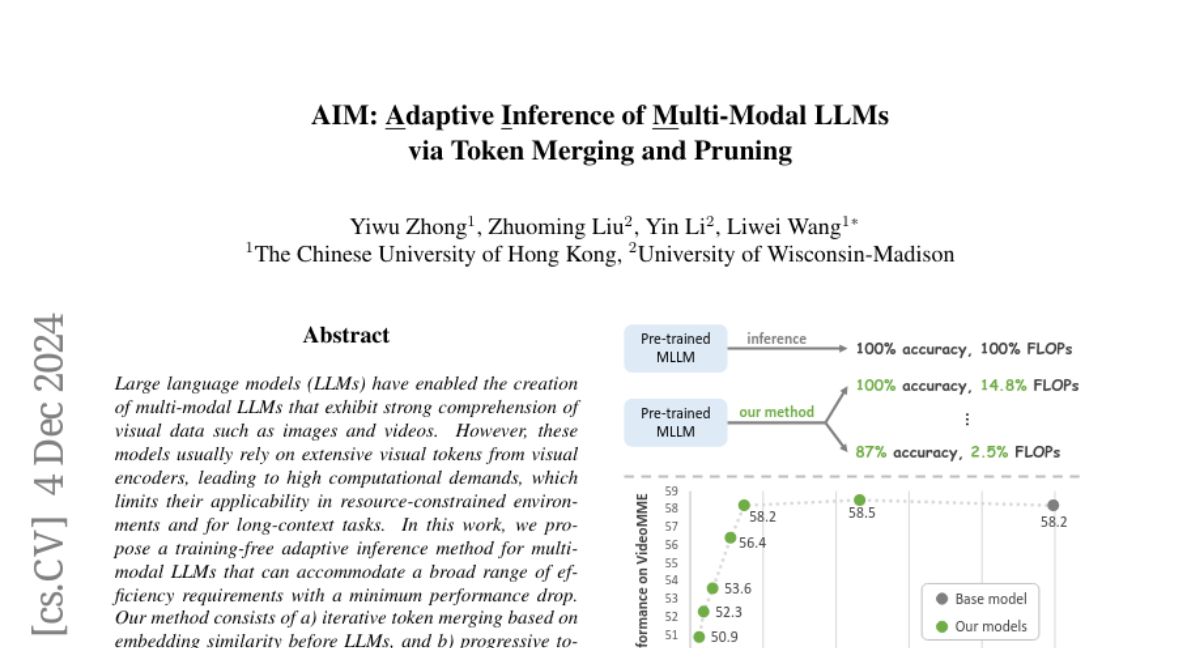

В данной работе мы предлагаем метод адаптивного инференса для мульти-модальных LLM, который не требует дополнительного обучения и может удовлетворять широкий спектр требований к эффективности с минимальными потерями в производительности. Наш метод включает два ключевых этапа: (a) итеративное слияние токенов на основе схожести их эмбеддингов перед подачей в LLM и (b) прогрессивная обрезка токенов внутри слоев LLM на основе многомодальной значимости.

Проблематика высоких вычислительных затрат

Мульти-модальные LLM, особенно те, которые работают с видео, могут генерировать тысячи токенов для одной единицы данных. Это приводит к высокому потреблению вычислительных ресурсов, что делает их трудными для использования в реальных приложениях, таких как обработка в реальном времени на мобильных устройствах. Увеличение количества кадров в видео также приводит к росту общего числа токенов, что ограничивает способность модели обрабатывать плотные видеопотоки и может привести к потере важной временной информации.

Адаптивный инференс

Адаптивный инференс позволяет динамически регулировать вычислительную нагрузку модели во время инференса на основе контекстуальных факторов, таких как содержание изображения, вычислительные ограничения или желаемые уровни точности. Поскольку удержание всех визуальных токенов во время инференса часто не требуется, наша основная идея заключается в стратегическом выборе токенов в процессе инференса. Это позволяет оптимизировать эффективность модели, сохраняя при этом ее точность.

Методология

Мы предлагаем метод адаптивного инференса, состоящий из двух основных этапов:

-

Слияние токенов перед LLM: Визуальный энкодер преобразует входные визуальные данные в визуальные токены, которые затем итеративно сливаются на основе их схожести эмбеддингов. Это значительно уменьшает количество токенов, сохраняя при этом производительность модели.

-

Обрезка токенов внутри LLM: После слияния токенов, мы передаем их в LLM, где менее важные токены обрезаются на каждом слое, используя алгоритм PageRank для оценки значимости токенов на основе весов внимания.

Эксперименты и результаты

Мы провели обширные эксперименты на различных видео- и изображенческих бенчмарках, таких как VideoMME и MLVU. Результаты показывают, что наш метод значительно снижает вычислительные затраты (например, на 7 раз по сравнению с базовой моделью), сохраняя при этом производительность мульти-модальных LLM.

Сравнение с существующими методами

Подход, предлагаемый в данной работе, превосходит методы, которые уже существуют на данный момент, в контексте понимания длинных видео. Например, мы показали улучшение на 4.6% по сравнению с состоянием на рынке (SOTA) на бенчмарке MLVU при сопоставимых вычислительных затратах.

Важные находки

-

Избыточность токенов: Мы обнаружили, что полный набор видео токенов часто не требуется, так как всего 25% визуальных токенов, поданных в LLM, могут поддерживать близкую производительность.

-

Влияние на производительность: Обрезка текстовых токенов на ранних слоях LLM значительно влияет на производительность, тогда как обрезка визуальных токенов на поздних слоях может сохранять производительность.

-

Фокус на многомодальной интеграции: Мульти-модальные LLM в ранних слоях акцентируют внимание на кросс-модальной интеграции, в то время как в поздних слоях они сосредотачиваются на текстовых токенах.

Заключение

В данной работе представлен метод адаптивного инференса для мульти-модальных LLM, который позволяет значительно сократить вычислительные затраты, сохраняя при этом производительность. Мы надеемся, что наши результаты станут основой для будущих исследований в области адаптивных мульти-модальных LLM, где соотношение точности и эффективности может динамически изменяться в зависимости от вычислительных условий.