GraPE: Генеративная платформа для композиционного T2I синтеза

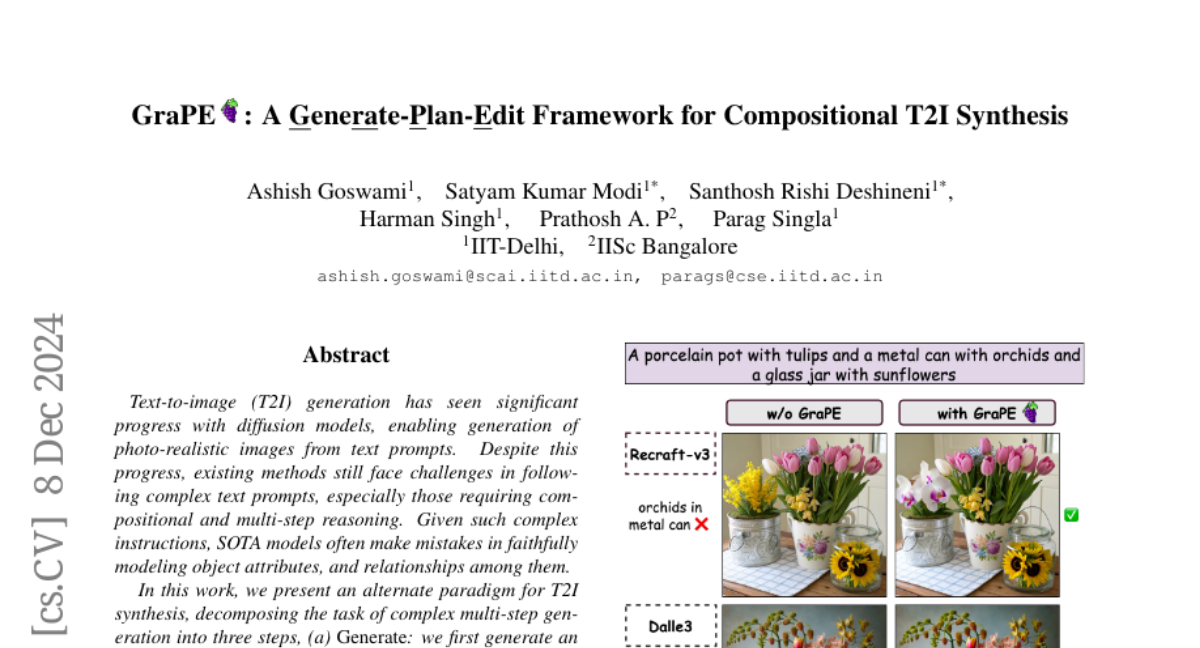

Синтез изображений на основе текстовых описаний (Text-to-Image, T2I) стал одной из самых обсуждаемых тем в области машинного обучения. Современные диффузионные модели значительно улучшили качество генерации фотореалистичных изображений. Однако, несмотря на эти достижения, существующие методы всё ещё сталкиваются с трудностями при обработке сложных текстовых подсказок, особенно тех, которые требуют композиционного и многоступенчатого рассуждения. В этой статье мы обсудим новый подход, представленный в работе "GraPE: Генеративная платформа для композиционного T2I синтеза", который предлагает альтернативную парадигму для T2I синтеза, разбивая задачу на три этапа: генерация, планирование и редактирование.

Проблемы существующих моделей

Несмотря на успехи, достигнутые с помощью диффузионных моделей, такие модели часто допускают ошибки в точном моделировании атрибутов объектов и их взаимосвязей. Эти ошибки могут возникать из-за недостатка подходящих обучающих данных и использования слабых текстовых кодировщиков. Это ограничивает их применение в реальных сценариях, где требуется автоматизированная и надежная генерация изображений.

Существующие подходы к улучшению T2I генерации можно разделить на две категории:

- Финетюнинг существующих моделей генерации: Эти методы требуют изменения архитектуры и переобучения моделей.

- Адаптация процедуры вывода: Эти подходы не требуют переобучения, а вместо этого изменяют процесс генерации.

Хотя оба подхода показывают некоторые улучшения, задача остается далеко не решенной.

Новый подход GraPE

GraPE (Generate-Plan-Edit) предлагает модульный и свободный от обучения подход к T2I синтезу. Он разбивает задачу на три этапа:

- Генерация (Generate): На первом этапе создается изображение с помощью существующих T2I моделей.

- Планирование (Plan): Используя многофункциональные большие языковые модели (Multi-Modal Large Language Models, MLLMs), мы идентифицируем ошибки в сгенерированном изображении и формируем последовательность корректирующих шагов в виде плана редактирования.

- Редактирование (Edit): На последнем этапе мы применяем существующие модели редактирования изображений, чтобы последовательно выполнить план редактирования на сгенерированном изображении.

Этап 1: Генерация

Первый этап включает в себя использование современных моделей T2I для создания начального изображения. Эта модель может быть любой из существующих диффузионных моделей, таких как DALL-E или Stable Diffusion. Важно отметить, что на этом этапе изображение может содержать ошибки, которые мы будем исправлять на следующих этапах.

Этап 2: Планирование

На втором этапе используется MLLM для анализа сгенерированного изображения и текстового описания. MLLM выполняет следующие задачи:

- Анализ текстовых элементов: Извлечение высокоуровневых пар объектов и атрибутов из текстового описания.

- Анализ элементов изображения: Генерация детализированного анализа объектов в сгенерированном изображении.

- Идентификация ошибок: Сравнение извлеченных элементов из текстового описания и изображения для определения несоответствий.

MLLM генерирует последовательность редактирования, которая включает конкретные шаги, необходимые для исправления ошибок в изображении.

Этап 3: Редактирование

На последнем этапе мы применяем модель редактирования изображений, чтобы последовательно реализовать план редактирования. Важно, что этот этап можно выполнить с использованием любой предобученной модели редактирования, что делает подход GraPE универсальным.

Преимущества GraPE

- Модульность: GraPE может работать с любыми существующими моделями генерации и редактирования, что делает его гибким инструментом для различных задач.

- Отсутствие необходимости в обучении: GraPE не требует дополнительного обучения, что упрощает его интеграцию и использование.

- Улучшение производительности: GraPE показывает значительные улучшения в производительности по сравнению с исходными моделями T2I, обеспечивая более точное соответствие между изображением и текстовым описанием.

Экспериментальная оценка

Авторы провели обширную экспериментальную оценку на трех бенчмарках и десяти моделях T2I, включая DALL-E 3 и Stable Diffusion 3.5. Результаты показали, что GraPE улучшает производительность SOTA моделей на 3 и более пунктов и сокращает разрыв в производительности между слабыми и сильными моделями.

Заключение

GraPE представляет собой значительный шаг вперед в области генерации изображений на основе текстовых описаний. Его модульная структура и способность к адаптации к различным моделям делают его мощным инструментом для улучшения качества T2I синтеза. Несмотря на достигнутые успехи, работа по дальнейшему улучшению модели и расширению ее возможностей продолжается. В будущем можно ожидать интеграцию с моделями, которые будут более точно соответствовать текстовым описаниям, а также применение механизмов обратной связи для улучшения редактирования изображений.