Погружение в 3D: Открытие новых горизонтов с DiffusionGS

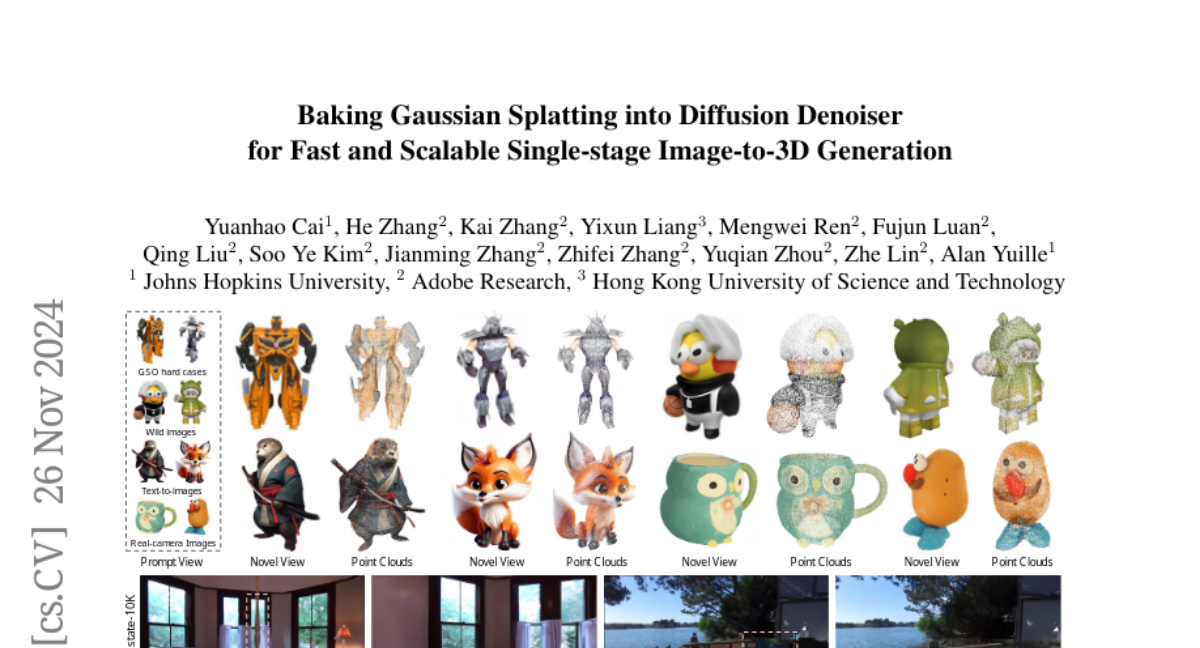

В мире, где визуальное восприятие играет ключевую роль, преобразование двумерных изображений в трехмерные объекты становится не просто техническим достижением, но и открывает двери в новые измерения для таких областей, как AR/VR, кинематограф, робототехника и многих других. Традиционные методы создания 3D из 2D изображений часто сталкиваются с проблемами согласованности и качества, особенно при изменении ракурса изображения или работе с обширными сценами. Однако, с появлением DiffusionGS, разработанного группой исследователей из Johns Hopkins University, Adobe Research и Hong Kong University of Science and Technology, мы стоим на пороге новой эры в генерации 3D контента.

Проблемы и Подходы

Существующие Методы

Большинство существующих методов генерации 3D из изображений полагаются на двухэтапные процессы, где сначала генерируются многовидовые изображения с помощью 2D диффузионных моделей, а затем эти изображения используются для реконструкции 3D моделей. Эти методы, несмотря на свою эффективность в определенных условиях, не могут гарантировать согласованность трехмерного представления, особенно при изменении ракурса съемки, и часто ограничены в обработке только объектно-центрических изображений.

DiffusionGS: Инновационный Подход

DiffusionGS представляет собой одностадийную модель диффузии, которая напрямую генерирует 3D представления из одного изображения, обходя многие из проблем, с которыми сталкиваются традиционные методы. Вот ключевые аспекты этого подхода:

-

Генерация 3D Гауссианских Облаков Точек: В отличие от традиционных методов, DiffusionGS в каждом временном шаге создает 3D гауссианские облака точек, что обеспечивает согласованность во всех ракурсах.

-

Смешанная Обучающая Стратегия: Для улучшения обобщающей способности модели, используется стратегия смешанного обучения на данных об объектах и сценах, что позволяет модели адаптироваться к разнообразным условиям съемки и геометрии.

-

RPPC (Reference-Point Plücker Coordinates): Новый метод кодирования камеры, который помогает лучше воспринимать глубину и 3D геометрию.

Как Работает DiffusionGS?

Основы Диффузии

Диффузионные модели, такие как DDPM (Denoising Diffusion Probabilistic Models), работают путем постепенного добавления шума к данным и последующего его удаления для восстановления исходного сигнала. DiffusionGS использует этот принцип, но вместо восстановления 2D изображений, она восстанавливает 3D представления.

Архитектура DiffusionGS

-

Входные Данные: Модель принимает одно чистое изображение и несколько зашумленных видов объекта или сцены.

-

Денойзер: Архитектура модели включает в себя трансформер, который обрабатывает входные данные, объединенные с информацией о камере, для предсказания 3D гауссианских примитивов.

-

Рендеринг Гауссианских Облаков: Используя дифференцируемую растеризацию, модель преобразует предсказанные 3D точки в изображения, которые затем сравниваются с реальными изображениями для обучения.

-

Смешанное Обучение: Модель обучается на смешанном наборе данных, включающем объекты и сцены, что позволяет ей лучше обобщать и создавать более реалистичные 3D модели.

RPPC: Улучшение Восприятия Глубины

RPPC использует точку на луче, ближайшую к началу координатной системы мира, для более точного кодирования камеры, что улучшает восприятие глубины и геометрии сцены.

Эксперименты и Результаты

Качество и Скорость

DiffusionGS демонстрирует превосходство над существующими методами, показывая улучшение на 2.20 dB в PSNR и снижение FID на 23.25 для объектов, а также на 2.91 dB и 75.68 для сцен. При этом, модель работает значительно быстрее, выполняя генерацию за ~6 секунд на одном GPU A100.

Визуальные Результаты

Модель успешно генерирует детализированные и согласованные 3D модели как для объектов, так и для сцен, справляясь с такими сложными задачами, как фуррность, тени, плоские иллюстрации, сложная геометрия и даже отражения.

Генерация из Текста

Интеграция с моделями текст-изображение, такими как Stable Diffusion и FLUX, позволяет DiffusionGS создавать 3D модели из текстовых описаний, что открывает новые возможности для дизайна и визуализации.

Заключение

DiffusionGS представляет собой значительный шаг вперед в области генерации 3D контента из 2D изображений, предлагая не только улучшенное качество и скорость, но и возможность работы с разнообразными сценариями и объектами. Это инновационное решение обещает расширить границы визуального восприятия и творчества, делая 3D генерацию более доступной и эффективной для широкого спектра приложений.