MOVIS: Улучшение синтеза новых видов для многопредметных сцен

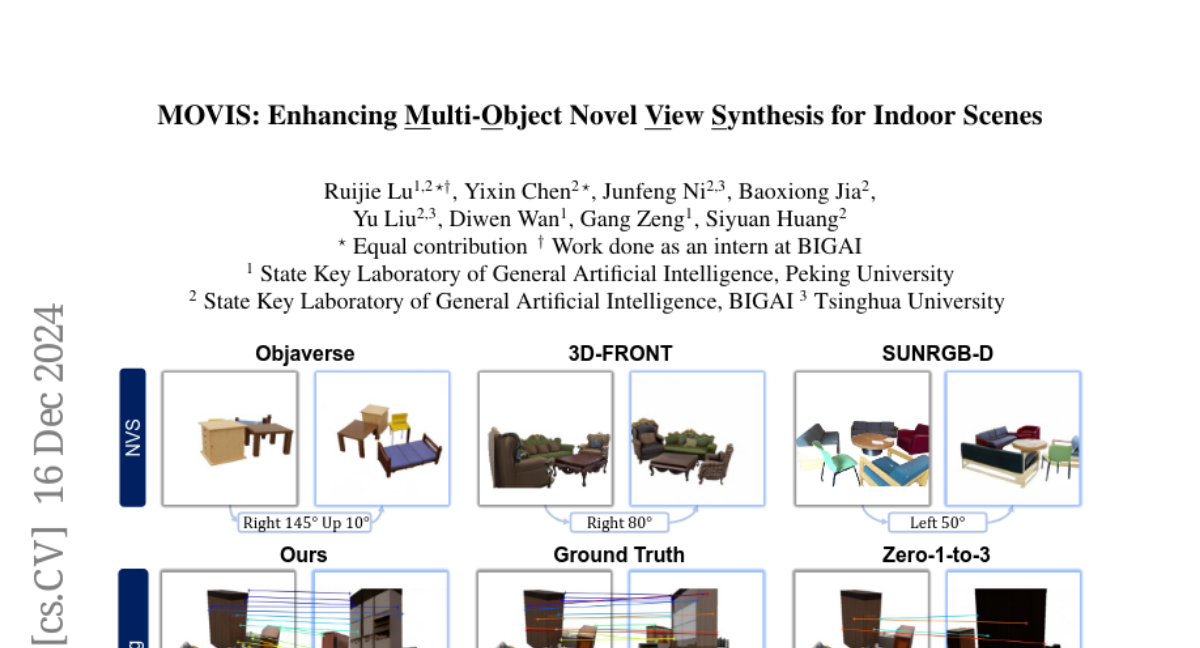

Переосмысление предварительно обученных диффузионных моделей оказалось эффективным для NVS. Однако эти методы в основном ограничены одним объектом; прямое применение таких методов к композиционным сценариям с несколькими объектами дает худшие результаты, особенно неправильное размещение объектов и непоследовательные формы и внешний вид при новых ракурсах. Способы повышения и систематической оценки кросс-видовой согласованности таких моделей остаются недостаточно исследованными. Чтобы решить эту проблему, мы предлагаем MOVIS для повышения структурной осведомленности модели диффузии, зависящей от вида, для многопредметного NVS с точки зрения входных данных модели, вспомогательных задач и стратегии обучения. Во-первых, мы вводим осведомленные о структуре признаки, включая глубину и маску объекта, в U-Net для удаления шума, чтобы улучшить понимание моделью экземпляров объектов и их пространственных взаимосвязей. Во-вторых, мы вводим вспомогательную задачу, требующую от модели одновременного предсказания масок объектов нового ракурса, что дополнительно улучшает способность модели различать и размещать объекты. Наконец, мы проводим углубленный анализ процесса выборки диффузии и тщательно разрабатываем планировщик выборки по временным шагам, ориентированный на структуру, во время обучения, который балансирует обучение глобальному размещению объектов и восстановлению тонких деталей. Чтобы систематически оценить правдоподобие синтезированных изображений, мы предлагаем оценить кросс-видовую согласованность и размещение объектов нового ракурса наряду с существующими метриками NVS на уровне изображений. Обширные эксперименты на сложных синтетических и реалистичных наборах данных демонстрируют, что наш метод обладает сильными способностями к обобщению и производит согласованный синтез новых видов, подчеркивая его потенциал для руководства будущими задачами NVS с несколькими объектами, учитывающими 3D.