Вставка объектов в изображения без обучения с использованием предобученных диффузионных моделей

Вставка объектов в изображения по текстовым инструкциям является сложной задачей в области семантической обработки изображений. Она требует баланса между сохранением оригинального контента сцены и интеграцией нового объекта таким образом, чтобы он выглядел естественно и уместно. Несмотря на значительные усилия в этой области, существующие модели часто сталкиваются с трудностями в достижении этого баланса, особенно когда речь идет о выборе подходящего места для добавления объекта в сложных сценах.

Вставка объектов в изображения на основе текстовых инструкций открывает множество возможностей для создания контента, компьютерной графики и генерации синтетических данных. Например, художники могут использовать модели текст-к-изображению для постепенного построения сложных визуальных сцен, а исследователи в области автономного вождения могут добавлять пешеходов в новые сценарии для обучения систем восприятия автомобилей.

Основная проблема заключается в том, чтобы добавить объект таким образом, чтобы он не только соответствовал текстовой инструкции, но и выглядел естественно в контексте изображения. Это требует понимания аффордансов — глубоких семантических знаний о том, как люди и объекты взаимодействуют в реальном мире, чтобы разместить объект в подходящем месте. Мы называем эту задачу Image Additing.

Обзор существующих методов

Ранние попытки решения этой задачи включали использование традиционных методов компьютерной графики, где объекты размещались вручную или с помощью синтетических данных. С развитием глубокого обучения, генеративные модели начали обучаться на больших наборах данных, чтобы предсказывать возможные позиции объектов в сценах. Например:

- Compositing GAN (Azadi et al., 2020) генерирует композитные объекты, уточняя их геометрию и внешний вид.

- Relaxed Placement (Lee et al., 2022) оптимизирует размещение и размер объектов на основе отношений, изображенных в графах сцены.

- OBJect3DIT (Michel et al., 2024) исследует вставку объектов, осведомленную о 3D, с использованием языковых инструкций.

Несмотря на их эффективность, эти методы часто сталкиваются с трудностями при работе с реальными сценариями размещения.

Наш подход: Add-it

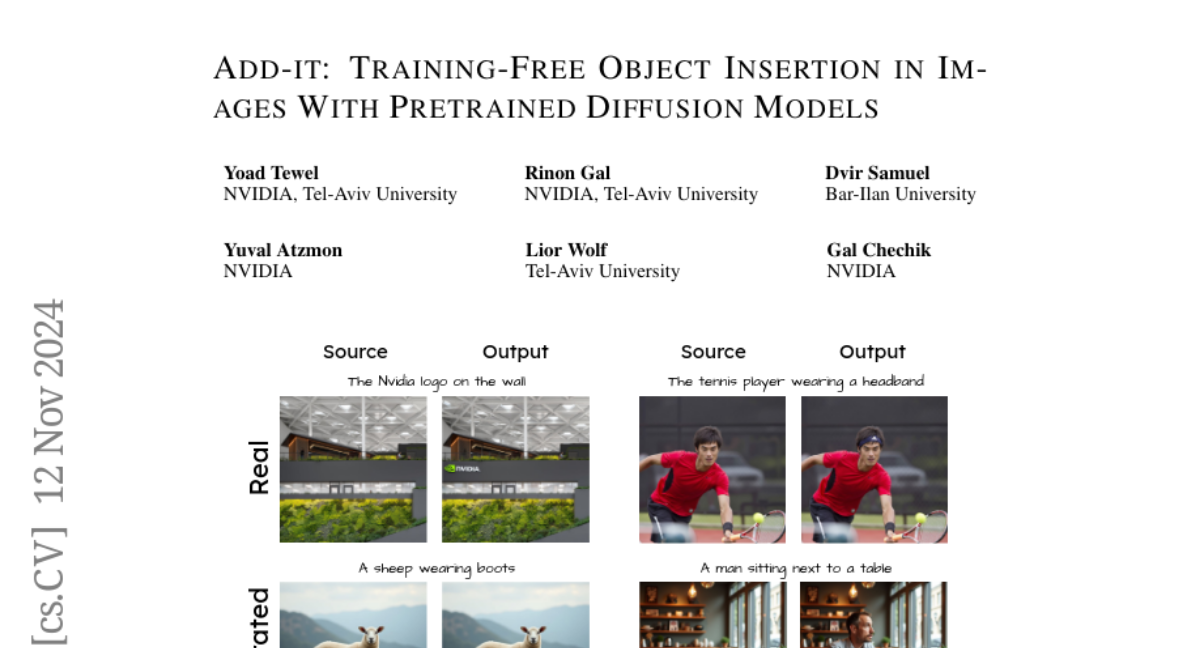

Мы представляем Add-it, метод, который позволяет вставлять объекты в изображения без дополнительного обучения или оптимизации. Add-it использует предобученные диффузионные модели, расширяя их механизмы внимания для интеграции информации из трех ключевых источников:

- Исходное изображение - для сохранения структуры и деталей сцены.

- Текстовый запрос - для описания объекта, который нужно добавить.

- Генерируемое изображение - для обеспечения естественного размещения объекта.

Расширенное внимание

Add-it вводит взвешенное расширенное внимание, которое помогает поддерживать структурную согласованность и детализацию, одновременно обеспечивая естественное размещение объектов. Механизм внимания модифицируется таким образом, чтобы учитывать токены из исходного изображения, текстового запроса и генерируемого изображения. Это позволяет модели извлекать ключевые и значения из всех трех источников:

A = softmax([Q_p, Q_target][K_source, K_p, K_target]⊤ / √d_k)

h = A · [V_source, V_p, V_target]

где Q_p, Q_target — запросы для текстового запроса и генерируемого изображения соответственно, а K и V — ключи и значения, извлеченные из исходного изображения, текстового запроса и генерируемого изображения.

Структурный перенос

Для обеспечения структурного сходства между исходным и целевым изображениями, мы применяем структурный перенос. Этот процесс включает в себя добавление шума к исходному изображению на высоких уровнях шума, что позволяет сохранить общую структуру, но дает возможность вносить изменения в содержание изображения.

Субъектно-ориентированное латентное смешивание

Чтобы сохранить мелкие детали исходного изображения, такие как текстуры и тени, мы вводим субъектно-ориентированное латентное смешивание. Этот шаг включает в себя создание маски объекта с помощью модели сегментации SAM-2 и смешивание латентных представлений исходного и целевого изображений на основе этой маски.

Эксперименты и результаты

Мы оценили Add-it на нескольких бенчмарках, включая наш новый Additing Affordance Benchmark, который оценивает правдоподобность размещения объектов. Add-it показал превосходные результаты, значительно улучшив метрики аффордансов и включения объектов по сравнению с существующими методами.

Метрики

- CLIP-based метрики (CLIP_dir, CLIP_out, CLIP_im) для оценки соответствия изменений в изображении текстовым инструкциям.

- Inclusion - для измерения частоты добавления объекта в изображение.

- Affordance - для оценки правдоподобности размещения объекта.

Человеческая оценка

В ходе пользовательских исследований, Add-it был предпочтен в более чем 80% случаев по сравнению с другими методами.

Заключение

Add-it представляет собой значительный шаг вперед в области вставки объектов в изображения без необходимости дополнительного обучения. Этот метод демонстрирует, что использование знаний, заложенных в предобученные диффузионные модели, может привести к созданию естественных и убедительных изображений с добавленными объектами. Add-it открывает новые возможности для семантической обработки изображений, облегчая создание сложных визуальных сцен и улучшая качество синтетических данных для обучения AI-моделей.