HARP: Улучшение производительности языковых моделей с помощью осведомленности о колебаниях и переосмысления

В последние годы языковые модели, основанные на архитектуре Transformer, стали основой многих приложений в области обработки естественного языка. Однако, несмотря на их впечатляющие достижения, существует ряд ограничений, связанных с производительностью этих моделей во время вывода (inference). В этой статье мы рассмотрим новую методику, предложенную в работе "HARP: Hesitation-Aware Reframing in Transformer Inference Pass", которая направлена на улучшение производительности языковых моделей за счет адаптации вычислительных ресурсов в зависимости от сложности генерируемых токенов.

Архитектура Transformer, предложенная Васвани и его коллегами в 2017 году, использует фиксированное количество проходов слоев для генерации каждого нового токена. Это обеспечивает простоту параллелизации во время обучения, но не всегда позволяет использовать весь потенциал модели во время вывода, когда токены генерируются последовательно. Исследования в области адаптивных вычислений показывают, что не все шаги вывода равны по сложности: некоторые токены требуют больше вычислительных ресурсов, чем другие. Это приводит к тому, что текущие подходы к выводу могут быть неэффективными, особенно когда речь идет о сложных токенах.

Проблема равномерного распределения вычислений

Современные языковые модели, как правило, обрабатывают каждый токен одинаково, независимо от его сложности. Это может привести к снижению точности и производительности. В ответ на это, некоторые исследователи начали увеличивать размер моделей, чтобы обеспечить больше вычислительных ресурсов для сложных токенов. Однако это также приводит к ненужным затратам для более простых токенов.

Другие подходы, такие как Спекулятивное декодирование, используют более крупную модель для проверки и коррекции токенов, сгенерированных меньшей моделью, что позволяет более эффективно распределять вычислительные ресурсы. Однако такие методы требуют наличия внешних моделей и могут быть сложными в реализации.

Вдохновение от когнитивных процессов человека

В данной работе авторы черпают вдохновение из человеческого поведения, позволяя моделям выполнять дополнительные вычисления для "сложных" шагов, не полагаясь на внешние модели или требуя повторного обучения. Основными концепциями, на которых основан метод HARP, являются:

- Осведомленность о колебаниях: когда модель сталкивается с неопределенностью, она "приостанавливается" и переосмысливает входные данные, что позволяет ей более эффективно обрабатывать сложные токены.

- Эффект фрейминга: как информация представлена, может влиять на суждение и реакцию. Переосмысление входных данных позволяет модели рассматривать их с другой точки зрения, что может улучшить результаты.

Метод HARP

Основные компоненты

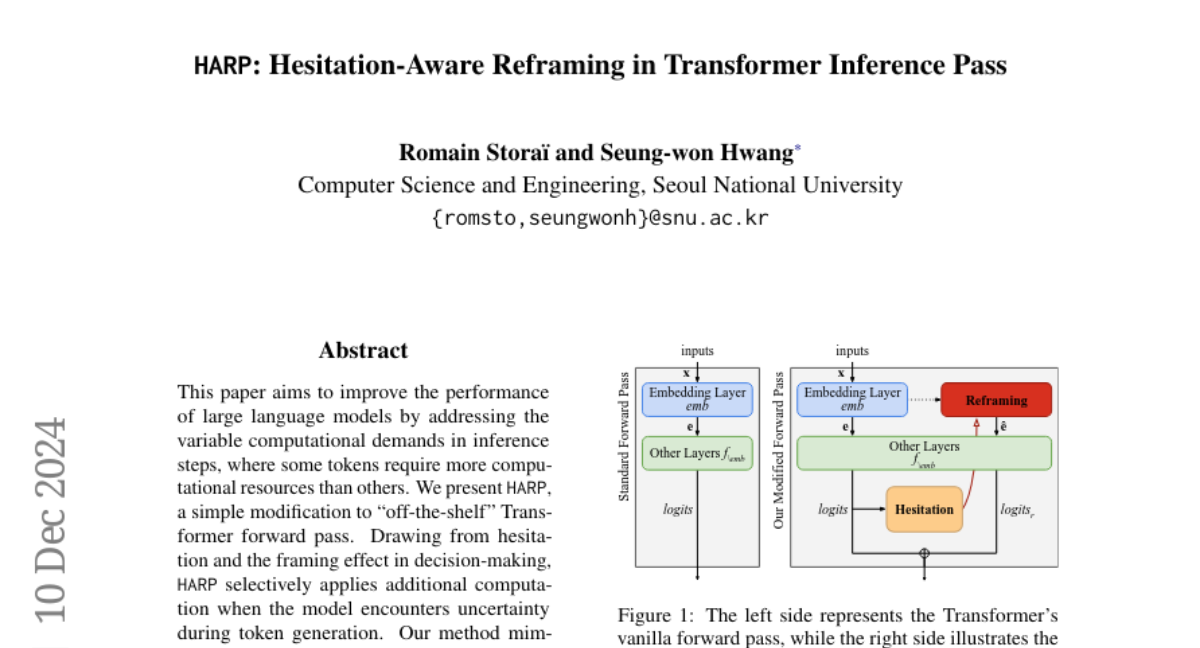

HARP (Hesitation-Aware Reframed Forward Pass) представляет собой модификацию стандартного прохода Transformer, которая включает в себя два ключевых компонента:

- Оценка неопределенности: на каждом этапе генерации токена модель оценивает свою неопределенность, используя энтропию Шеннона как меру неопределенности.

- Переосмысление входов: если модель испытывает неопределенность, она переосмысливает входные данные, добавляя случайный шум к векторным представлениям токенов, что позволяет ей рассматривать данные с новой точки зрения.

Процесс работы HARP

Процесс работы HARP можно описать следующими шагами:

- Стандартный проход: модель обрабатывает входные токены через слой встраивания и последующие слои, генерируя начальные логиты (предсказания).

- Оценка неопределенности: модель вычисляет энтропию логитов, чтобы оценить свою уверенность в предсказании следующего токена.

- Переосмысление: если энтропия выше порогового значения, модель выполняет дополнительный проход с переосмысленными входами, где к векторным представлениям добавляется случайный шум.

- Комбинирование логитов: финальные логиты формируются путем взвешенного комбинирования логитов из стандартного и переосмысленного проходов.

Эмпирическая оценка

Модели и наборы данных

Авторы протестировали HARP на нескольких языковых моделях размером от 3,8 до 8 миллиардов параметров, включая LLaMA-3.1 и Mistral 7B. Они использовали различные наборы данных, включая GSM8K, CommonSenseQA и LAMBADA, чтобы оценить производительность модели на различных задачах.

Результаты

Результаты показали, что HARP значительно улучшает производительность всех задач. В частности, HARP продемонстрировал улучшение точности на до 5.16% по сравнению с базовой моделью. Кроме того, время вывода HARP было в два раза быстрее, чем у методов, использующих поиск по лучу (beam search).

Сравнение с другими методами

HARP также продемонстрировал превосходство над другими методами, такими как Спекулятивное декодирование и использование токенов паузы. В отличие от этих методов, HARP не требует повторного обучения и может быть легко внедрен в существующие модели.

Заключение

HARP представляет собой инновационный подход к улучшению производительности языковых моделей во время вывода, который основывается на адаптивных вычислениях и когнитивных процессах человека. Этот метод позволяет моделям более эффективно обрабатывать сложные токены, не требуя значительных изменений в архитектуре или повторного обучения. Результаты показывают, что HARP может быть мощным инструментом для повышения точности и эффективности языковых моделей, что открывает новые горизонты для их применения в различных задачах обработки естественного языка.