Разработка интеллектуальных агентов для графических интерфейсов: Взгляд на модель ShowUI

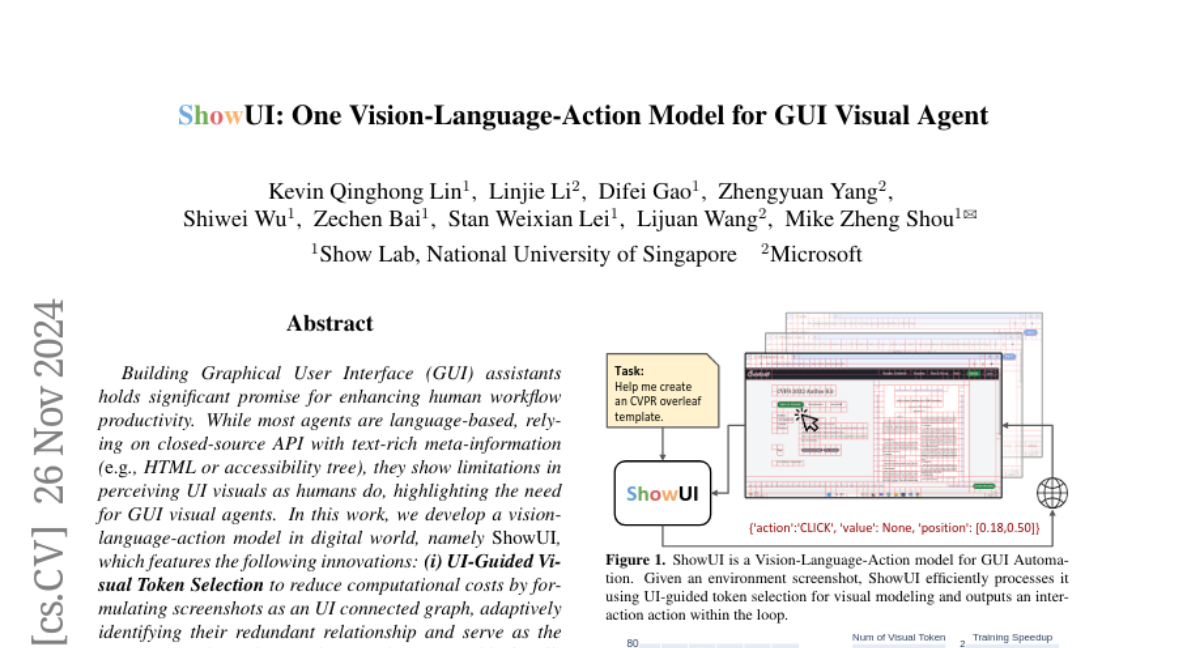

Разработка графических интерфейсов пользователя (GUI) для помощников обещает значительные перспективы для повышения продуктивности рабочих процессов человека. Хотя большинство агентов основаны на языковых технологиях и используют закрытые API с богатой текстовой мета-информацией (например, HTML или дерево доступности), они проявляют ограничения в восприятии визуалов интерфейса так, как это делают люди, что подчеркивает необходимость в агентах, способных визуально воспринимать GUI. В данной работе мы разрабатываем модель видео-языковых действий в цифровом мире, называемую ShowUI, которая включает следующие инновации: (i) Выбор визуальных токенов, руководимый UI, для снижения вычислительных затрат путем формулирования скриншотов в виде связанного графа UI, адаптивно выявляя их избыточные отношения и используя их в качестве критериев для выбора токенов в блоках само-внимания; (ii) Потоковое смешивание видео, языка и действий, которое гибко объединяет разнообразные потребности в задачах GUI, позволяя эффективно управлять историей визуальных действий при навигации или сопоставлении последовательностей запросов-действий на каждый скриншот для повышения эффективности обучения; (iii) Создание малых, но качественных наборов данных с инструкциями для GUI путем тщательного отбора данных и применения стратегии пересэмплирования для решения проблемы значительного дисбаланса типов данных. С помощью вышеперечисленных компонентов, ShowUI, легковесная модель на 2 миллиарда параметров, использующая 256K данных, достигает высокой точности в 75.1% при нулевом тестировании на привязке к скриншотам. Ее выбор токенов, руководимый UI, дополнительно сокращает на 33% избыточные визуальные токены во время обучения и ускоряет производительность в 1.4 раза. Эксперименты по навигации в средах web Mind2Web, мобильного AITW и онлайн MiniWob подчеркивают эффективность и потенциал нашей модели для развития визуальных агентов GUI. Модели доступны по адресу https://github.com/showlab/ShowUI.