НЕКО: Построение пост-распознавания с использованием моделей больших языковых моделей и специалистов по задачам

Распознавание речи, текста и изображений является важной задачей в области искусственного интеллекта (AI). Человеческая способность к распознаванию охватывает множество модальностей, включая речь, визуальные образы и текст, и, несмотря на несовершенство, люди могут эффективно общаться, даже когда речь идет о неправильном распознавании. В этой статье мы исследуем концепцию "пост-распознавания" или "генеративной коррекции ошибок" (GEC) с помощью больших языковых моделей (LLM), фокусируясь на новом подходе, который использует специалистов по задачам (Mixture-of-Experts, MoE) для повышения точности и универсальности в различных сценариях распознавания.

Пост-распознавание и его вызовы

Пост-распознавание относится к процессу коррекции и улучшения результатов, полученных от первоначальных моделей распознавания, таких как автоматическое распознавание речи (ASR), оптическое распознавание символов (OCR) и машинный перевод (MT). Основная задача заключается в том, как эффективно обучить модель на большом разнообразии данных из различных доменов, чтобы она могла корректировать ошибки, специфичные для каждого из этих доменов, не увеличивая при этом количество параметров модели.

Модели больших языковых моделей и генеративная коррекция ошибок

Большие языковые модели (LLM) в последние годы показали значительные успехи в понимании и генерации текста. Они были адаптированы для задач пост-распознавания, где они используются для рефинансирования и коррекции первоначальных результатов распознавания. Однако, прямое обучение LLM на смешанных данных из различных источников может привести к неоптимальной производительности из-за различий в модальностях ввода, форматов вывода, типов ошибок и характеристик доменов.

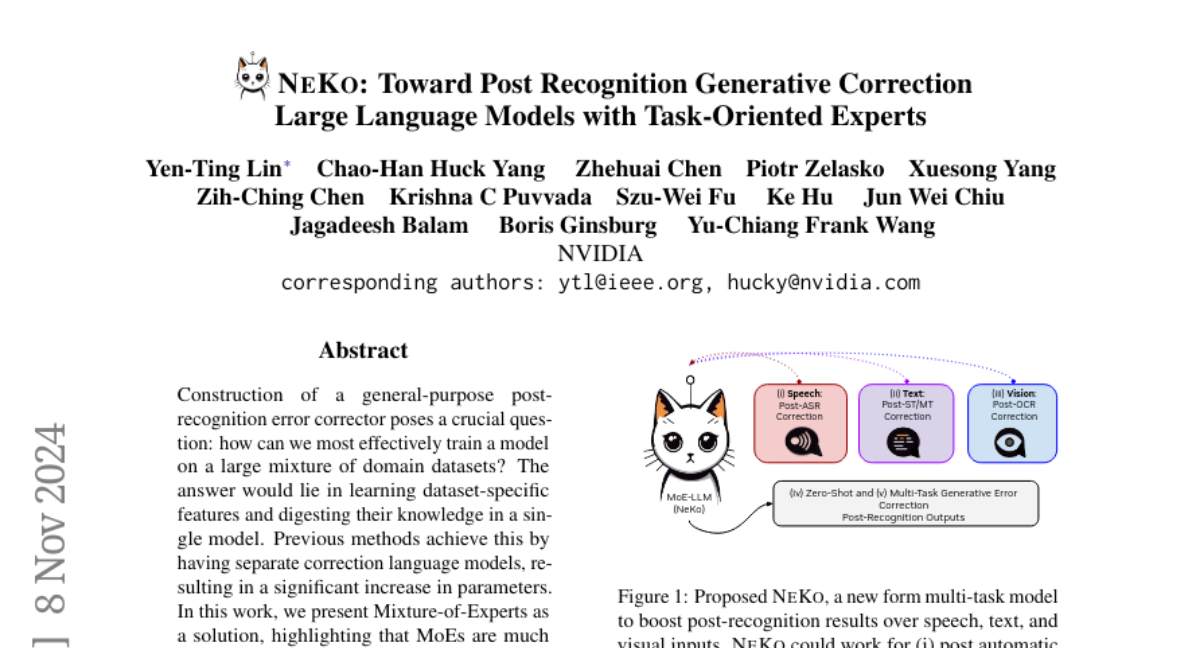

Модель НЕКО: Построение на основе MoE

Наш подход, названный НЕКО (от англ. "NeKo" - "N, E, K, O"), предлагает использовать MoE для решения этих проблем. MoE - это архитектура, где несколько специализированных подмоделей (экспертов) работают вместе, чтобы решать задачи, каждая из которых специализируется на определенных аспектах входных данных. В нашем случае, каждый эксперт обучается на определенном наборе данных распознавания (например, ASR, OCR, MT), позволяя модели извлекать специфические для задачи особенности, одновременно обмениваясь знаниями через общую сеть маршрутизации.

Архитектура НЕКО

Архитектура НЕКО основана на трансформере, где традиционные слои заменены слоями MoE. В каждом таком слое входной токен направляется к одному или нескольким экспертам, выбранным на основе вероятностей, вычисленных сетью маршрутизации. Эта сеть определяет, какие эксперты будут активированы для обработки каждого токена, что позволяет модели эффективно масштабироваться и специализироваться на различных задачах без увеличения вычислительных затрат на токен во время инференса.

Эксперименты и результаты

Наши эксперименты показали, что НЕКО может значительно улучшить производительность в различных задачах пост-распознавания:

- ASR: На Open ASR Leaderboard НЕКО достигла нового рекорда производительности, снизив среднюю относительную ошибку на 5.0%.

- MT и ST: На тестовых наборах FLEURS, CoVoST-2 и MuST-C НЕКО превзошла существующие модели, улучшив BLEU score на 5.4-9.2 пункта.

- OCR: НЕКО снизила ошибку распознавания символов с 71.03% до 14.43%.

- Текстовая коррекция: В задачах грамматической коррекции и улучшения когерентности текста НЕКО показала значительные улучшения.

Заключение

НЕКО представляет собой инновационный подход к пост-распознаванию, используя MoE для эффективного обучения на смешанных данных и специализации на различных задачах. Этот метод не только улучшает точность распознавания, но и демонстрирует способность модели к обобщению на новые, невидимые ранее задачи. В будущем мы планируем исследовать более сложные стратегии назначения экспертов, а также улучшить интерпретируемость и адаптивность модели для еще более широкого спектра приложений.