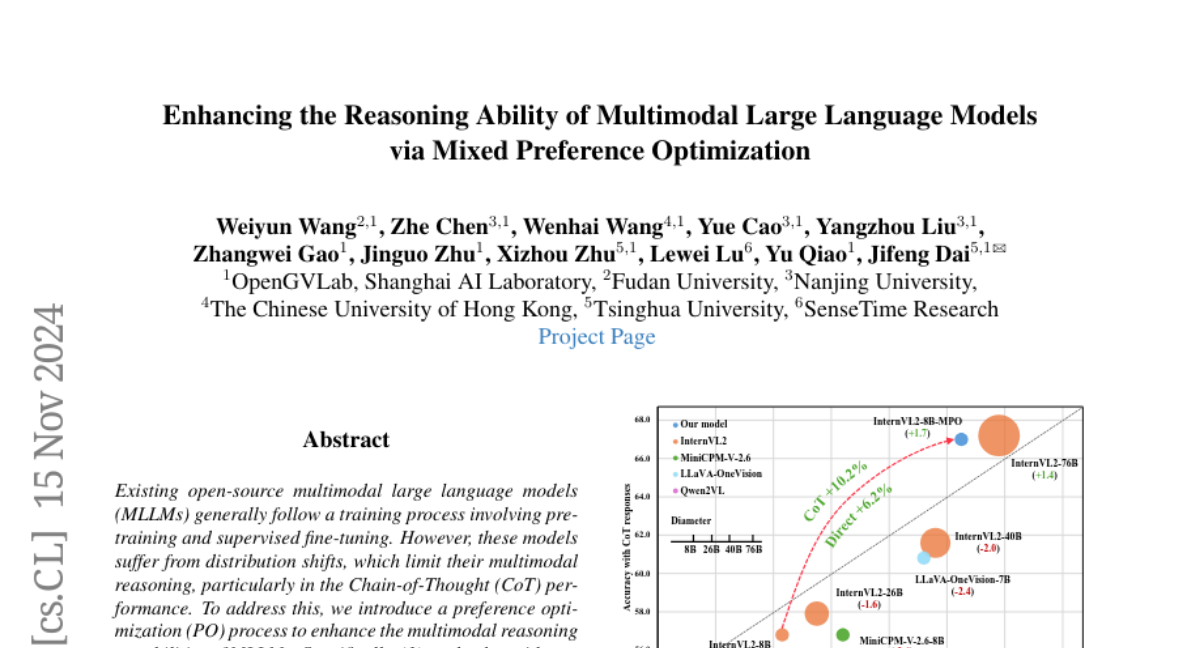

Усиление способностей к мультимодальному рассуждению с помощью оптимизации смешанных предпочтений

Существующие открытые мультимодальные крупные языковые модели (MLLM) обычно проходят процесс обучения, включающий предварительное обучение и настройку под надзором. Однако эти модели страдают от сдвигов распределения, что ограничивает их мультимодальное рассуждение, особенно в задачах цепочки рассуждений (Chain-of-Thought, CoT). Чтобы решить эту проблему, мы вводим процесс оптимизации предпочтений (PO), чтобы улучшить мультимодальные способности к рассуждению MLLM. В частности: 1. **На стороне данных** мы разработали автоматизированный конвейер для создания предпочтительных данных, чтобы создать MMPR - высококачественный, крупномасштабный набор данных мультимодальных предпочтений для рассуждений. 2. **На стороне модели** мы исследуем интеграцию PO с MLLM, разрабатывая простой, но эффективный метод, названный Смешанной Оптимизацией Предпочтений (Mixed Preference Optimization, MPO), который улучшает мультимодальную производительность CoT. Наш подход демонстрирует улучшение результатов на нескольких бенчмарках, особенно в задачах мультимодального рассуждения. В частности, наша модель, InternVL2-8B-MPO, достигла точности 67.0 на MathVista, опережая InternVL2-8B на 8.7 пунктов и показывая результаты, сравнимые с InternVL2-76B, которая в 10 раз больше. Мы надеемся, что это исследование вдохновит на дальнейшие улучшения в области MLLM. Код, данные и модель будут доступны для общественности.