MagicDriveDiT: Высококачественная генерация длинных видео для автономного вождения с адаптивным управлением

В последние годы технологии генерации видео значительно продвинулись вперёд благодаря развитию моделей диффузии. Эти модели позволяют создавать контролируемые видеосинтезы, что особенно важно для таких областей, как автономное вождение, где качество и точность синтезированных видео играют ключевую роль. Однако существующие методы сталкиваются с ограничениями в масштабируемости и интеграции управляющих условий, что не позволяет им удовлетворять требованиям высокого разрешения и длительности видео, необходимым для автономных систем вождения.

В этой статье мы представляем MagicDriveDiT, новый подход, основанный на архитектуре DiT (Diffusion Transformer), который решает эти проблемы. Наша методология улучшает масштабируемость с помощью техники flow matching и применяет прогрессивную стратегию обучения для управления сложными сценариями. Кроме того, MagicDriveDiT использует пространственно-временное кодирование условий, что позволяет точно управлять пространственно-временными латентными переменными.

Основные концепции MagicDriveDiT

Архитектура

MagicDriveDiT использует архитектуру DiT, которая включает в себя:

- Flow Matching: Этот метод позволяет модели эффективно масштабироваться, улучшая качество синтеза видео.

- Прогрессивное обучение: Модель обучается сначала на коротких и низкоразрешенных видео, постепенно переходя к более длинным и высокоразрешенным, что помогает в конвергенции и улучшении качества генерации.

- Пространственно-временное кодирование: Для управления пространственно-временными латентными переменными используется специально разработанный механизм кодирования, который обеспечивает точное управление геометрией и движением объектов в видео.

Управление условиями

- Карты дорог (Maps): Используются для определения структуры дороги в видео. Мы применяем методы временного уменьшения размерности, чтобы согласовать карты с латентными переменными видео.

- 3D боксы (Boxes): Для управления положением и движением объектов в пространстве и времени. Мы используем подход с временным трансформером и RoPE (Rotary Position Embedding) для захвата временных корреляций.

- Траектории (Trajectories): Определяют движение эго-автомобиля и других объектов. Кодирование траекторий выполняется аналогично боксам, но с использованием MLP для камерных поз.

Преимущества MagicDriveDiT

-

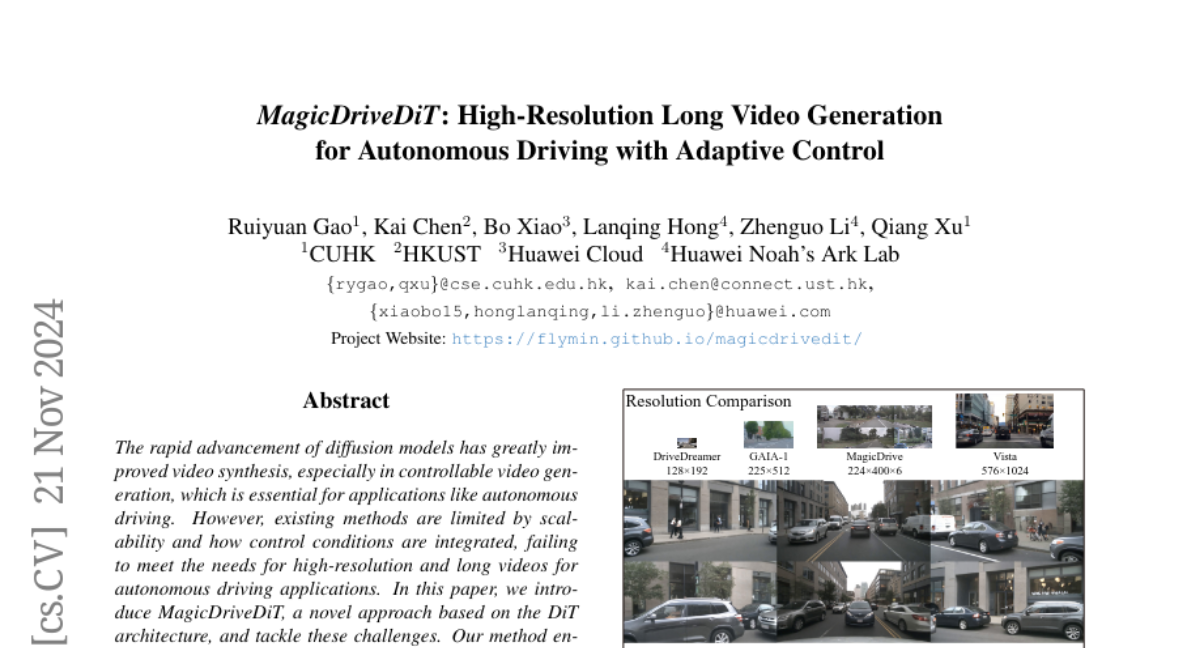

Высокое разрешение и длительность видео: MagicDriveDiT способна генерировать видео с разрешением до 848x1600 пикселей и длиной до 241 кадра, что значительно превосходит предыдущие работы.

-

Точность управления: Модель обеспечивает высокую точность в управлении пространственно-временными параметрами, что критически важно для автономного вождения.

-

Генерализация: Благодаря обучению на смешанных разрешениях и длительностях, MagicDriveDiT может генерировать видео, превышающие по качеству и длительности те, на которых она обучалась.

Эксперименты и результаты

Настройки эксперимента

Мы использовали датасет nuScenes для оценки MagicDriveDiT. Наша модель сравнивалась с базовыми моделями, такими как MagicDrive и MagicDrive3D, по нескольким метрикам, включая FVD (Frechet Video Distance) для оценки качества видео, mAP (mean Average Precision) для оценки точности обнаружения объектов и mIoU (mean Intersection over Union) для оценки точности сегментации дорог.

Результаты

- Качество генерации: MagicDriveDiT значительно улучшила метрику FVD по сравнению с базовыми моделями, что свидетельствует о более высокой реалистичности и детализации генерируемых видео.

- Контролируемость: Модель продемонстрировала высокую точность в управлении условиями, такими как погода, время суток, и траектории движения объектов.

- Генерализация: MagicDriveDiT показала способность генерировать видео с параметрами, выходящими за рамки обучающих данных, что подтверждает её высокую адаптивность.

Заключение

MagicDriveDiT представляет собой значительный шаг вперёд в области генерации видео для автономного вождения. Используя архитектуру DiT, метод flow matching и прогрессивное обучение, она обеспечивает высококачественную генерацию видео с точным управлением пространственно-временными условиями. Это открывает новые возможности для симуляции и тестирования автономных систем вождения, делая их более надежными и эффективными.