Morph: Бездвижный Физический Оптимизационный Фреймворк для Генерации Человеческого Движения

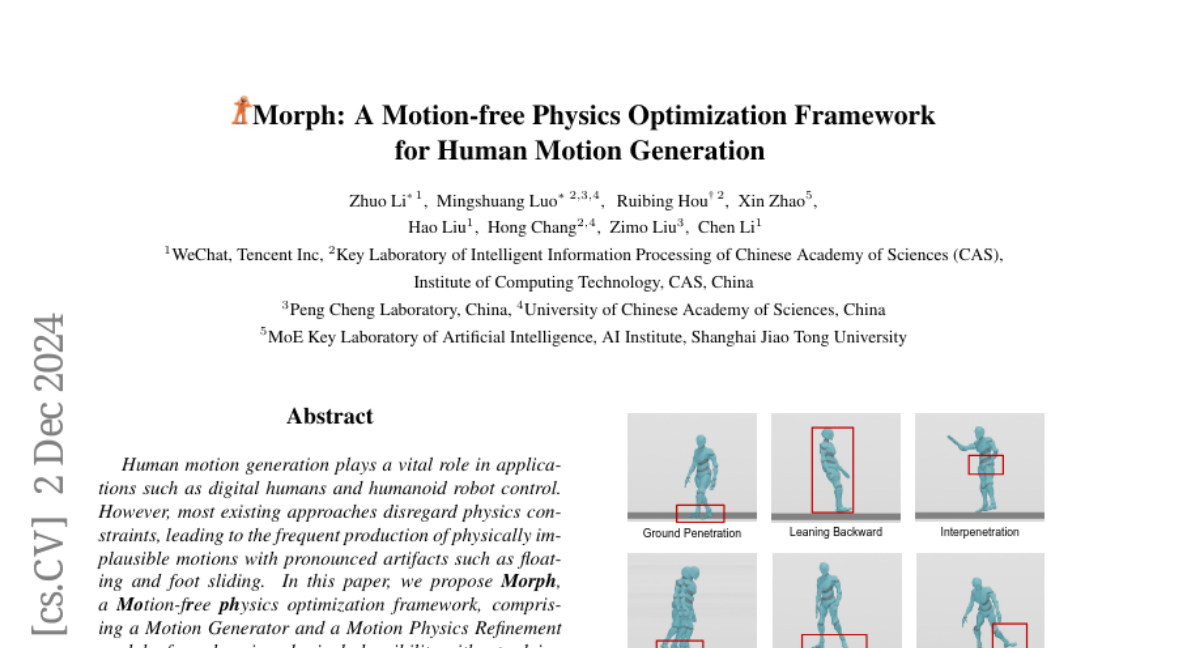

Генерация человеческого движения играет жизненно важную роль в таких приложениях, как цифровые люди и управление гуманоидными роботами. Однако большинство существующих подходов игнорируют физические ограничения, что приводит к частой генерации физически неправдоподобных движений с заметными артефактами, такими как левитация и соскальзывание ног. В данной работе мы предлагаем Morph, рамки оптимизации физики без движения, состоящие из генератора движений и модуля уточнения физики движений, для повышения физической правдоподобности без необходимости в дорогих данных движений из реального мира. В частности, Генератор Движений отвечает за предоставление масштабных синтетических данных о движениях, в то время как Модуль Уточнения Физики Движений использует эти синтетические данные для обучения имитатора движений внутри физического симулятора, накладывая физические ограничения для проекции шумных движений в физически правдоподобное пространство. Эти физически уточненные движения, в свою очередь, используются для доработки Генератора Движений, что дополнительно повышает его возможности. Эксперименты как в задачах генерации движений из текста, так и в задачах генерации танцев из музыки показывают, что наша система достигает передового качества генерации движений, значительно улучшая физическую правдоподобность.