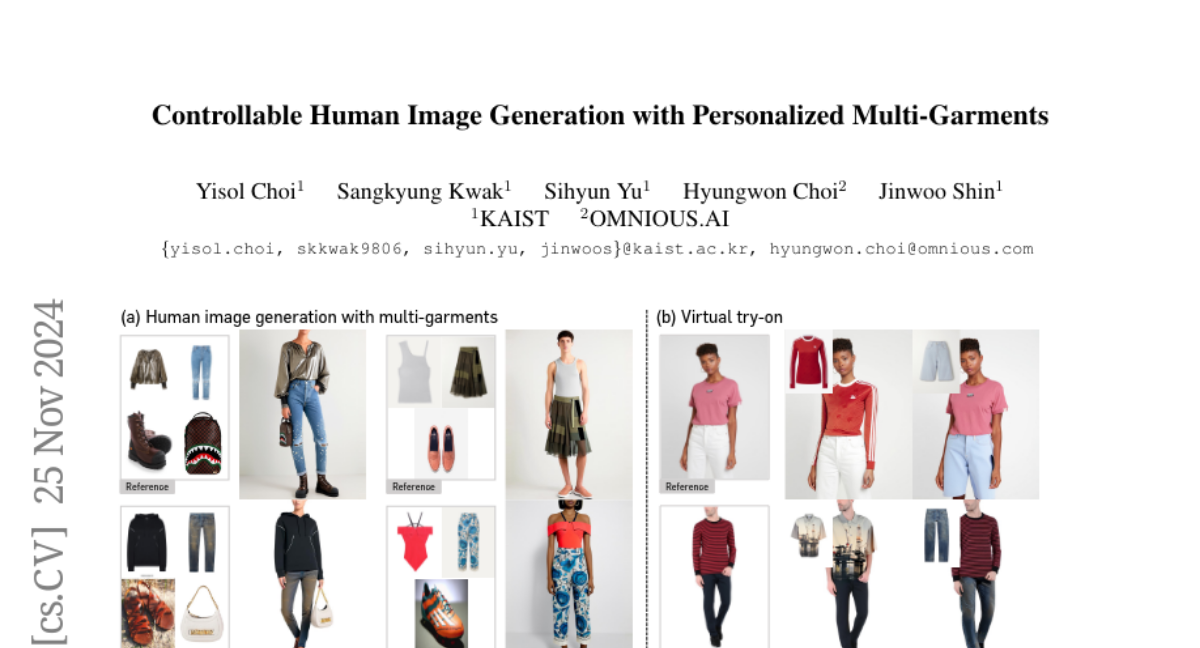

Контролируемая генерация человеческих изображений с персонализированными мульти-гарментами

Мы представляем BootComp, новую систему на основе моделей диффузии текста-в-изображение для контролируемой генерации изображений людей с использованием нескольких эталонных предметов одежды. Основная проблема здесь — сбор данных для обучения: создание крупномасштабного набора данных с высококачественными изображениями эталонной одежды для каждого человека представляет значительную сложность, то есть, идеально было бы вручную собирать каждую фотографию одежды, которую носит каждый человек. Чтобы решить эту проблему, мы предлагаем пайплайн для генерации данных, который позволяет создать большой синтетический набор данных, состоящий из пар человек и нескольких предметов одежды, путем внедрения модели для извлечения любых эталонных изображений одежды из каждого изображения человека. Для обеспечения качества данных мы также предлагаем стратегию фильтрации для удаления нежелательных сгенерированных данных на основе измерения перцептивного сходства между одеждой, представленной на изображении человека, и извлеченной одеждой. Наконец, используя созданный синтетический набор данных, мы обучаем модель диффузии, которая имеет два параллельных пути деноизации, использующие несколько изображений одежды в качестве условий для генерации изображений людей, при этом сохраняя их детализированные особенности. Мы также демонстрируем широкую применимость нашей системы, адаптируя ее к различным типам генерации на основе эталонов в области моды, включая виртуальную примерку и контролируемую генерацию изображений людей с другими условиями, такими как поза, лицо и т.д.

Создание Композиционных Сцен через Генерацию Экземпляров RGBA с Текстом в Изображение

Модели генерации изображений на основе текстов с использованием диффузии могут создавать изображения высокого качества, однако это требует утомительной настройки запросов. Улучшить управляемость можно путем введения условий компоновки, однако существующие методы не обладают возможностью редактирования компоновки и точного контроля над атрибутами объектов. Концепция многослойной генерации имеет большой потенциал для решения этих ограничений, однако одновременная генерация изображений вместе с композицией сцены ограничивает контроль над детализированными атрибутами объектов, их относительным положением в 3D пространстве и способностями к манипулированию сценой. В данной работе мы предлагаем новый многоэтапный парадигм генерации, который предназначен для точного контроля, гибкости и интерактивности. Для обеспечения контроля над атрибутами экземпляров, мы разрабатываем новый тренировочный парадигм для адаптации модели диффузии к генерации изолированных компонентов сцены в виде RGBA изображений с информацией о прозрачности. Для создания сложных изображений мы используем эти предварительно сгенерированные экземпляры и вводим процесс многослойной композиции, который плавно собирает компоненты в реалистичные сцены. Наши эксперименты показывают, что наша модель диффузии RGBA способна генерировать разнообразные и высококачественные экземпляры с точным контролем над атрибутами объектов. Через многослойную композицию мы демонстрируем, что наш подход позволяет создавать и манипулировать изображениями на основе сложных запросов с точным контролем над внешним видом и местоположением объектов, предоставляя более высокую степень контроля по сравнению с конкурирующими методами.