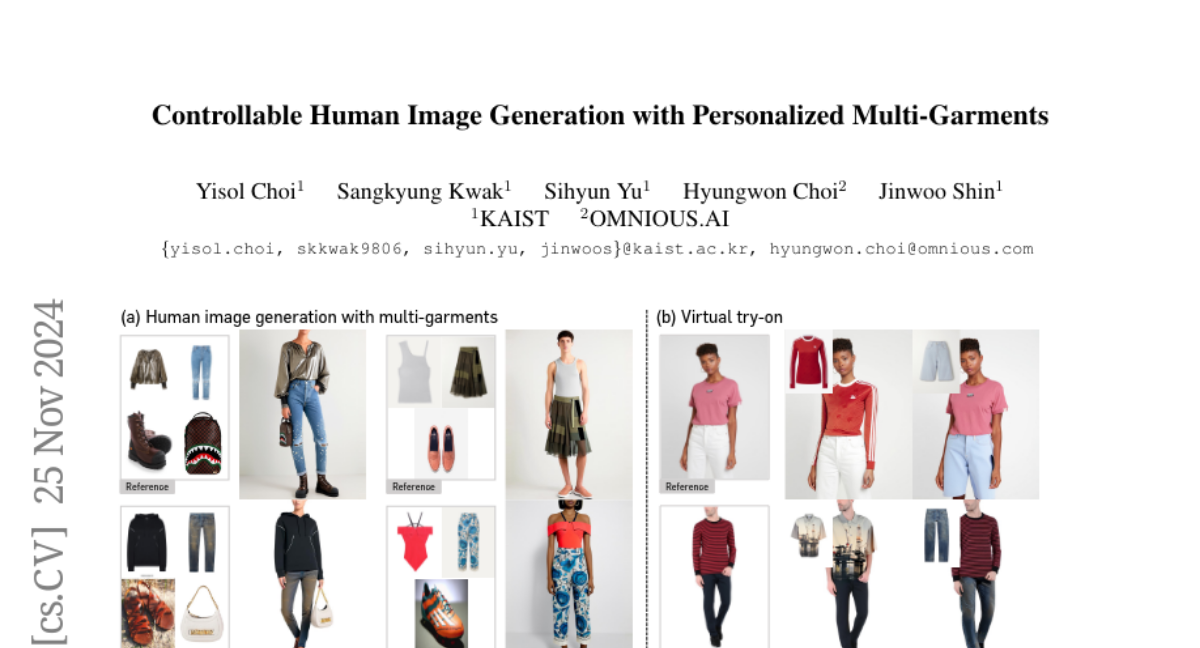

Контролируемая генерация человеческих изображений с персонализированными мульти-гарментами

Мы представляем BootComp, новую систему на основе моделей диффузии текста-в-изображение для контролируемой генерации изображений людей с использованием нескольких эталонных предметов одежды. Основная проблема здесь — сбор данных для обучения: создание крупномасштабного набора данных с высококачественными изображениями эталонной одежды для каждого человека представляет значительную сложность, то есть, идеально было бы вручную собирать каждую фотографию одежды, которую носит каждый человек. Чтобы решить эту проблему, мы предлагаем пайплайн для генерации данных, который позволяет создать большой синтетический набор данных, состоящий из пар человек и нескольких предметов одежды, путем внедрения модели для извлечения любых эталонных изображений одежды из каждого изображения человека. Для обеспечения качества данных мы также предлагаем стратегию фильтрации для удаления нежелательных сгенерированных данных на основе измерения перцептивного сходства между одеждой, представленной на изображении человека, и извлеченной одеждой. Наконец, используя созданный синтетический набор данных, мы обучаем модель диффузии, которая имеет два параллельных пути деноизации, использующие несколько изображений одежды в качестве условий для генерации изображений людей, при этом сохраняя их детализированные особенности. Мы также демонстрируем широкую применимость нашей системы, адаптируя ее к различным типам генерации на основе эталонов в области моды, включая виртуальную примерку и контролируемую генерацию изображений людей с другими условиями, такими как поза, лицо и т.д.