Оценка качества изображения для областей интереса с использованием инструкционной настройки видео-языковых моделей

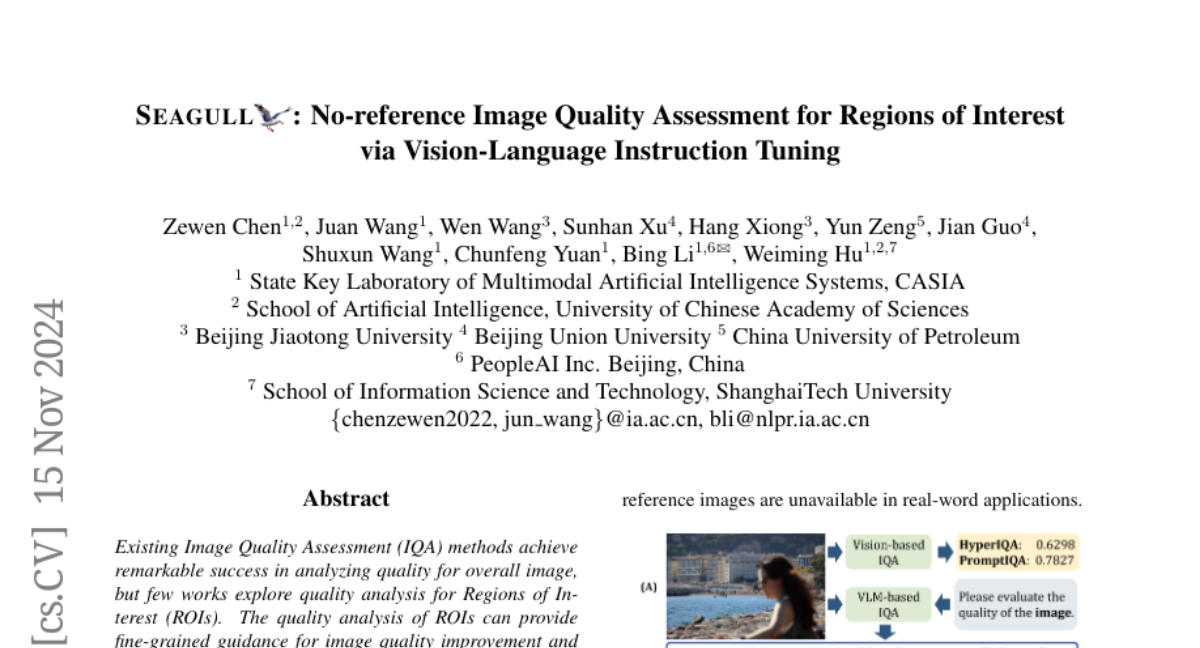

Существующие методы оценки качества изображения (IQA) достигли значительных успехов в анализе качества целого изображения, однако немногие работы исследуют анализ качества для областей интереса (ROIs). Анализ качества ROIs может предоставить детальные рекомендации для улучшения качества изображения и является ключевым для сценариев, ориентированных на качество на уровне регионов. В данной статье предлагается новая сеть, SEAGULL, которая может видеть и оценивать качество ROIs с использованием руководства от большой модели "видение-язык". SEAGULL включает модель "видение-язык" (VLM), маски, сгенерированные моделью Segment Anything Model (SAM) для указания ROIs, и тщательно разработанный экстрактор признаков на основе масок (MFE) для извлечения глобальных и локальных токенов для указанных ROIs, что позволяет выполнять точную оценку качества на уровне ROIs. Более того, в статье созданы два набора данных IQA на основе ROIs, SEAGULL-100w и SEAGULL-3k, для обучения и оценки IQA на основе ROIs. SEAGULL-100w содержит около 100 тысяч синтетических искаженных изображений с 33 миллионами ROIs для предобучения, чтобы улучшить способность модели воспринимать качество регионов, а SEAGULL-3k включает около 3 тысяч реальных искаженных ROIs для повышения способности модели воспринимать реальные искажения. После предобучения на SEAGULL-100w и дообучения на SEAGULL-3k, SEAGULL демонстрирует выдающиеся результаты в оценке качества ROIs с высокой детализацией. Код и наборы данных доступны по адресу https://github.com/chencn2020/Seagull.