Обзор метода RAG: Регионально-осведомленная генерация изображений из текста

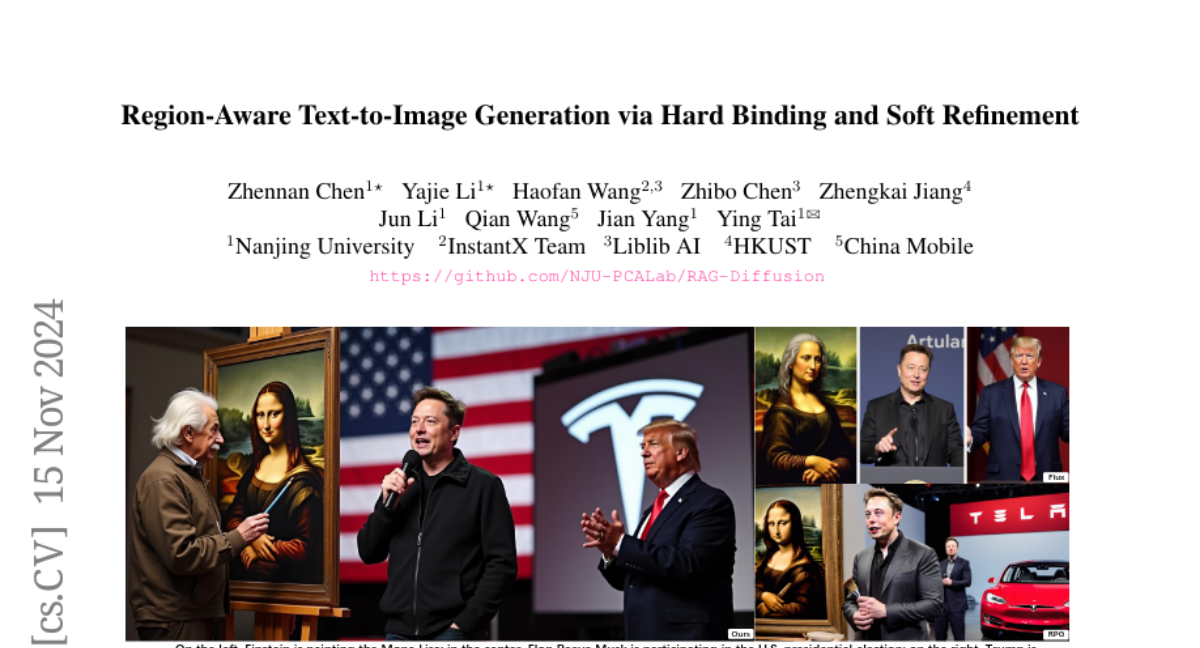

В данной статье мы представляем RAG, метод генерации изображений по тексту с учетом региональных описаний для точного компоновки макета. Региональное подсказывание или композитная генерация, позволяющая точный пространственный контроль, привлекает все больше внимания благодаря своей практичности в реальных приложениях. Однако, предыдущие методы либо вводят дополнительные обучаемые модули, что ограничивает их применение только к определенным моделям, либо манипулируют картами оценок внутри слоев перекрестного внимания с помощью масок внимания, что приводит к ограниченной силе контроля при увеличении числа регионов. Чтобы справиться с этими ограничениями, мы разделяем процесс многорегиональной генерации на две подзадачи: создание отдельных регионов (Региональная Жесткая Привязка), что гарантирует правильное выполнение регионального запроса, и общую детальную доработку (Региональная Мягкая Доработка) регионов, которая игнорирует визуальные границы и усиливает взаимодействие между соседними регионами. Более того, RAG новаторски делает возможным перерисовку, где пользователи могут изменять конкретные неудовлетворительные регионы предыдущей генерации, оставляя все остальные регионы неизменными, без необходимости использовать дополнительные модели для дорисовки. Наш подход не требует настройки и может быть применен к другим системам как улучшение следования запросу. Количественные и качественные эксперименты показывают, что RAG превосходит предыдущие методы без настройки по привязке атрибутов и отношениям объектов.