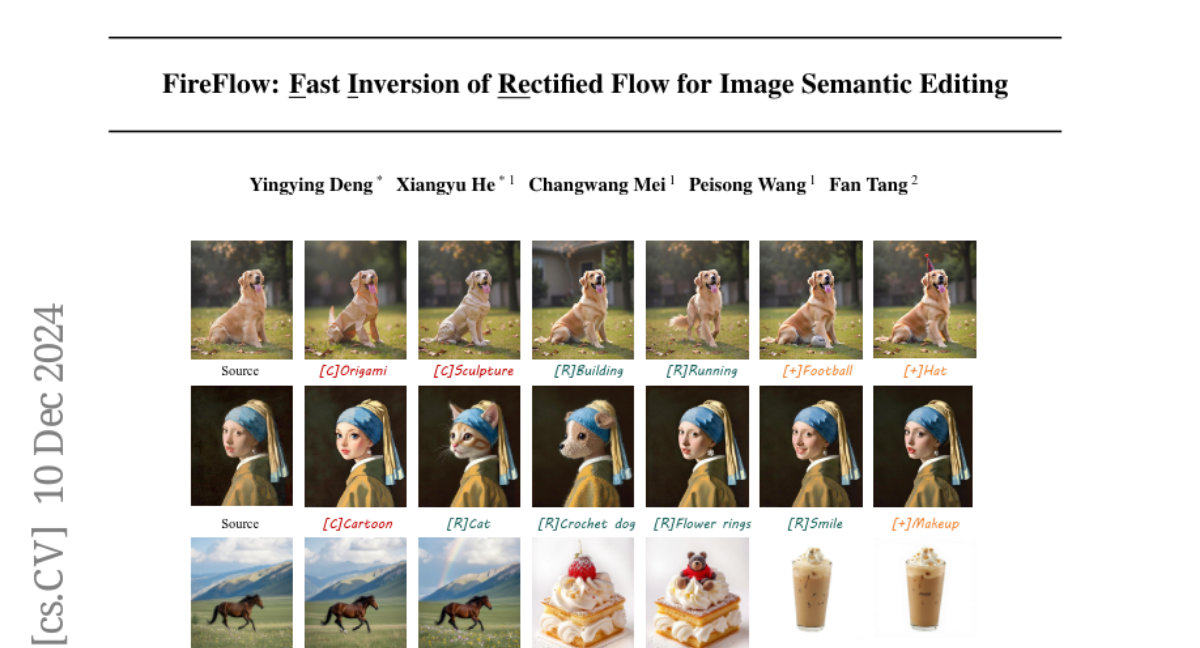

FireFlow: Быстрая инверсия ректифицированного потока для семантического редактирования изображений

Хотя ректифицированные потоки (ReFlows) с дистилляцией предлагают многообещающий способ быстрого выборки, их быстрая инверсия преобразует изображения обратно в структурированный шум для восстановления, и последующее редактирование остается нерешенной задачей. В этой статье представлено решение FireFlow, простой, но эффективный подход нулевого выстрела, который наследует потрясающую способность моделей на основе ReFlow (таких как FLUX) в генерации, одновременно расширяя их возможности до точной инверсии и редактирования за 8 шагов. Сначала мы демонстрируем, что тщательно разработанный численный решатель имеет решающее значение для инверсии ReFlow, позволяя точную инверсию и реконструкцию с точностью решателя второго порядка, сохраняя при этом практическую эффективность метода Эйлера первого порядка. Этот решатель достигает трехкратного увеличения скорости работы по сравнению с современными методами инверсии и редактирования ReFlow, при этом обеспечивая меньшие ошибки реконструкции и превосходные результаты редактирования в режиме без обучения. Код доступен по адресу https://github.com/HolmesShuan/FireFlow{this URL}.