GenMAC: Композиционная генерация видео на основе текста с помощью многоагентного сотрудничества

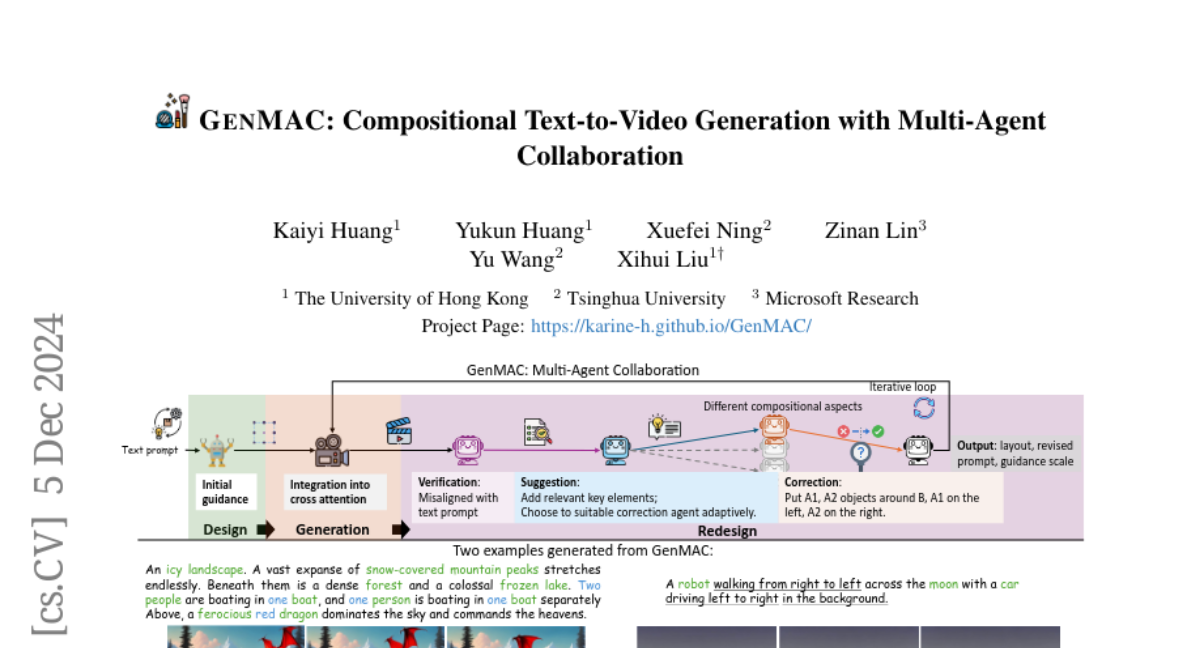

Модели генерации текста в видео продемонстрировали значительный прогресс в последние годы. Однако они все еще испытывают трудности с созданием сложных динамических сцен на основе составных текстовых запросов, таких как связывание атрибутов для нескольких объектов, временная динамика, связанная с разными объектами, и взаимодействие между объектами. Наша основная мотивация заключается в том, что сложные задачи можно разложить на более простые, каждая из которых обрабатывается специализированным агентом MLLM. Несколько агентов могут сотрудничать для достижения коллективного интеллекта в сложных целях. Мы предлагаем GenMAC, итеративную многоагентную структуру, которая позволяет составлять текстовую генерацию видео. Совместный рабочий процесс включает три этапа: Дизайн, Генерация и Повторный дизайн, с итеративным циклом между этапами Генерации и Повторного дизайна для постепенной проверки и уточнения созданных видео. Этап Повторного дизайна является самым сложным, его цель - проверить созданные видео, предложить исправления и переработать текстовые запросы, макеты кадра и масштабы руководства для следующей итерации генерации. Чтобы избежать галлюцинации одного агента MLLM, мы разбиваем этот этап на четыре последовательно выполняемых агента на основе MLLM: агент проверки, агент предложений, агент исправлений и агент структурирования выходных данных. Более того, для решения разнообразных сценариев составной текстовой генерации видео мы разрабатываем механизм самостоятельного маршрутизации для адаптивного выбора подходящего агента исправлений из набора агентов исправлений, каждый из которых специализирован для одного сценария. Обширные эксперименты демонстрируют эффективность GenMAC, достигая лучших результатов в области составной текстовой генерации видео.