Track4Gen: Улучшение генерации видео с помощью отслеживания точек

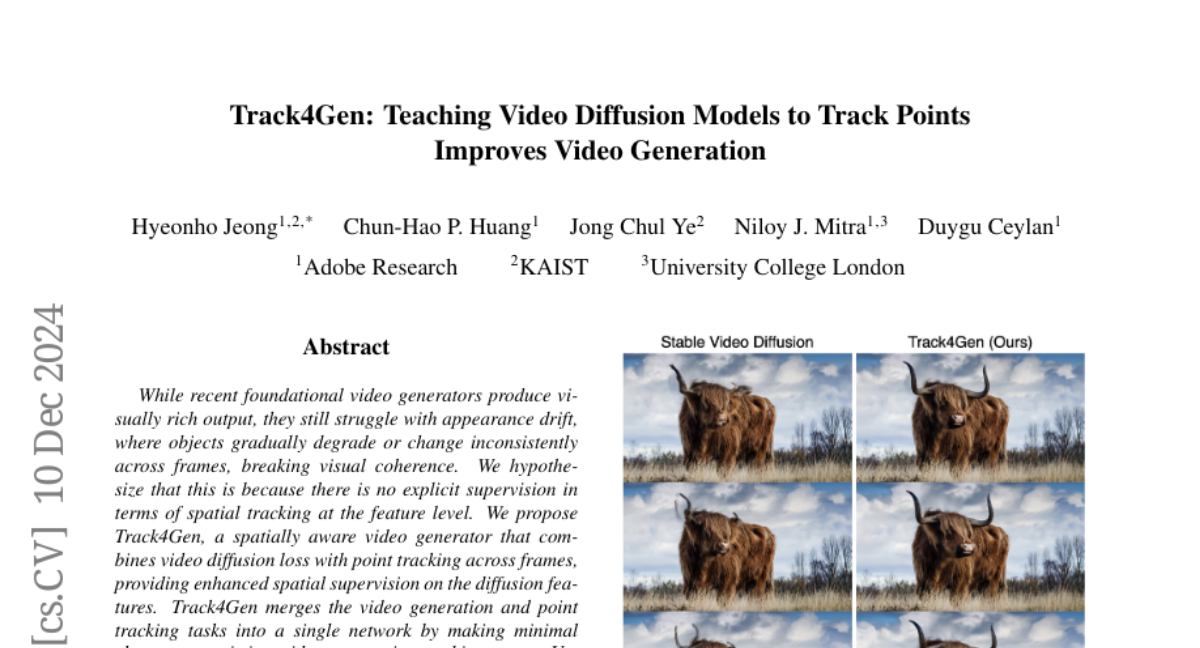

Хотя современные генераторы видео создают визуально насыщенный контент, они все еще сталкиваются с проблемой дрейфа внешнего вида, когда объекты постепенно теряют четкость или меняются непоследовательно в разных кадрах, нарушая визуальную согласованность. Мы предполагаем, что это происходит из-за отсутствия явного контроля в терминах пространственного слежения на уровне признаков. Мы предлагаем Track4Gen, генератор видео, обладающий пространственной осведомленностью, который сочетает в себе затраты на диффузию видео с отслеживанием точек в разных кадрах, обеспечивая улучшенное пространственное управление признаками диффузии. Track4Gen объединяет задачи генерации видео и отслеживания точек в одну сеть, внося минимальные изменения в существующие архитектуры генерации видео. Используя Stable Video Diffusion в качестве основы, Track4Gen демонстрирует, что возможно объединить генерацию видео и отслеживание точек, которые обычно рассматриваются как отдельные задачи. Наши обширные оценки показывают, что Track4Gen эффективно снижает дрейф внешнего вида, что приводит к временно стабильной и визуально согласованной генерации видео. Страница проекта: hyeonho99.github.io/track4gen