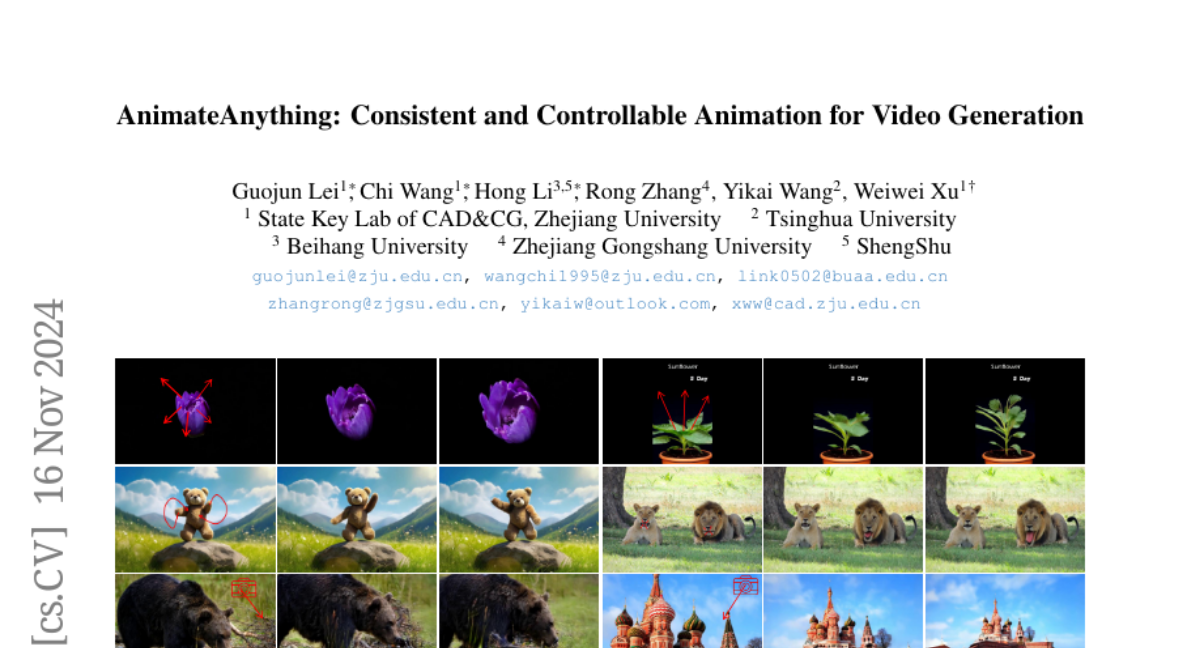

AnimateAnything: Создание Консистентных и Контролируемых Анимаций для Генерации Видео

В последние годы генерация видео с помощью искусственного интеллекта (AI) достигла значительных успехов, особенно после появления моделей, таких как Sora. Однако, несмотря на эти достижения, создание видео с точным управлением движением камеры, объектами и другими визуальными сигналами остается сложной задачей. В этом контексте представлен новый подход под названием AnimateAnything, который обещает революционизировать процесс генерации видео, предоставляя пользователям инструменты для точного и консистентного манипулирования различными аспектами видео.

Введение в AnimateAnything

AnimateAnything — это инновационный метод, который позволяет создавать видео с учетом множества различных условий, таких как траектории камеры, текстовые подсказки и пользовательские аннотации движения. Основная идея заключается в том, чтобы преобразовать все эти контрольные сигналы в единое представление — оптический поток, который затем используется для руководства процессом генерации видео.

Основные концепции

-

Многоуровневая Контрольная Сеть: AnimateAnything использует специально разработанную сеть для объединения различных контрольных сигналов в единое представление движения. Это позволяет модели учитывать как локальные движения объектов, так и глобальные изменения в сцене, вызванные движением камеры.

-

Преобразование в Оптический Поток: Весь контрольный информация преобразуется в кадр-за-кадром оптический поток, который служит как движущий приоритет для генерации видео. Это обеспечивает точность и консистентность движения в видео.

-

Модуль Стабилизации на Основе Частот: Для уменьшения мерцания, вызванного большими масштабами движения, введен модуль стабилизации, который работает в частотной области, обеспечивая временную когерентность видео.

Архитектура AnimateAnything

Этап 1: Генерация Единого Оптического Потока

На первом этапе AnimateAnything преобразует различные визуальные контрольные сигналы в единое представление оптического потока. Это достигается через:

-

Явное Внедрение: Контрольные сигналы, которые могут быть напрямую преобразованы в разреженный оптический поток (например, стрелочные аннотации движения), обрабатываются через модель генерации потока (FGM). Эта модель преобразует разреженные потоки в плотные, используя латентную диффузионную модель.

-

Неявное Внедрение: Для сигналов, которые трудно напрямую преобразовать в оптический поток (например, траектории камеры), используется прогрессивное внедрение через модель ссылочного движения (CRM). Эта модель интегрирует траектории камеры с референтным изображением, чтобы получить многомасштабные референтные признаки, которые затем направляют процесс генерации оптического потока.

Этап 2: Генерация Видео

На втором этапе используется полученный единый оптический поток для руководства генерацией видео:

-

Кодировка Оптического Потока: Оптический поток кодируется в латентное пространство, что позволяет эффективно использовать его в качестве руководства для генерации видео.

-

Интеграция с Видео Латентами: Видео латенты, полученные из изображения, и латенты оптического потока объединяются через блок Vision Transformer (ViT), что обеспечивает согласованность между движением и визуальным содержанием.

-

Генерация Видео: Финальная генерация видео происходит с использованием модели Diffusion Transformer (DiT), где текстовые подсказки и оптический поток интегрируются для создания видео, соответствующего заданным условиям.

Модуль Стабилизации на Основе Частот

Для улучшения качества и стабильности генерируемого видео, AnimateAnything применяет модуль стабилизации, который работает в частотной области:

-

Преобразование Фурье: Признаки видео преобразуются в частотную область с помощью Быстрого Преобразования Фурье (FFT).

-

Модификация Спектральных Признаков: В частотной области применяется параметрическая матрица весов для модификации спектральных признаков, что позволяет подавить нестабильность и мерцание.

-

Обратное Преобразование Фурье: После модификации, признаки возвращаются в временную область с помощью обратного FFT, обеспечивая временную когерентность видео.

Эксперименты и Результаты

AnimateAnything был протестирован на различных наборах данных, включая Real10K и WebVid10M, показав превосходство над существующими методами в плане качества генерации видео, консистентности с контрольными сигналами и общей стабильности видео. Эксперименты подтвердили, что метод может эффективно обрабатывать сложные сцены и движения, обеспечивая высокое качество и точность управления.

Заключение

AnimateAnything представляет собой значительный шаг вперед в области генерации видео с помощью AI, предлагая уникальный подход к интеграции и управлению различными визуальными сигналами. Благодаря своей способности создавать стабильные, консистентные и контролируемые анимации, этот метод открывает новые возможности для создания контента в кино, виртуальной реальности и других областях, где точность и качество видео имеют решающее значение.