p-MoD: Эффективные Мультимодальные Большие Языковые Модели

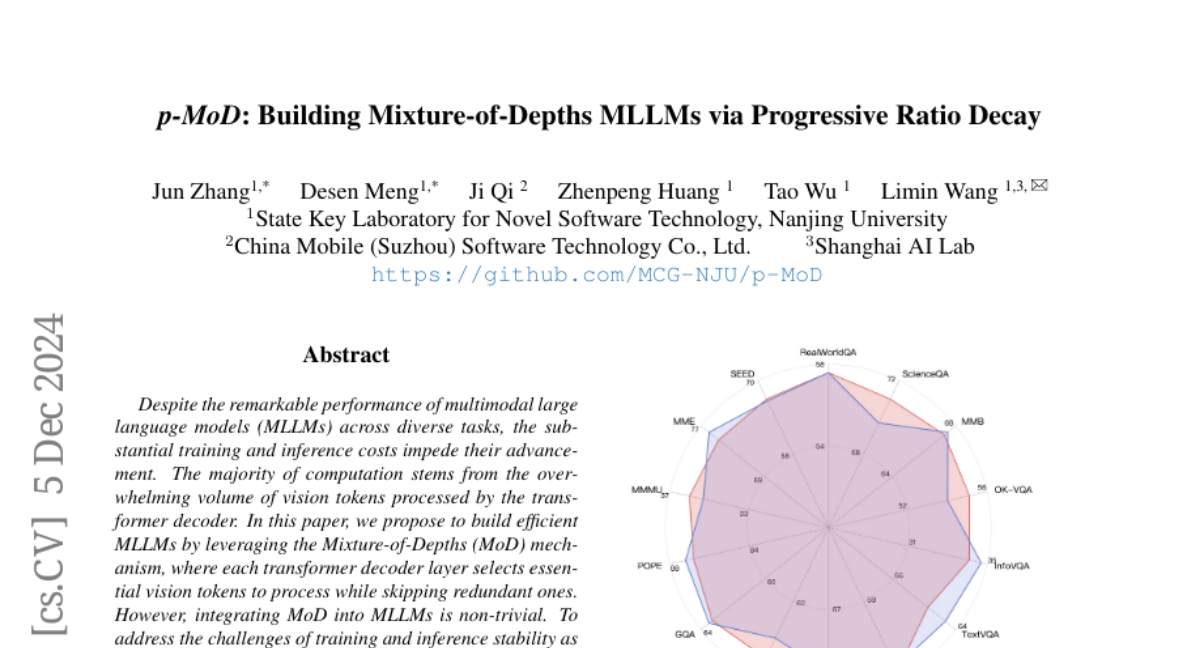

Несмотря на выдающиеся результаты многомодальных больших языковых моделей (MLLM) в различных задачах, значительные затраты на обучение и вывод мешают их развитию. Большая часть вычислений связана с огромным объемом визуальных токенов, обрабатываемых декодером трансформера. В этой статье мы предлагаем создавать эффективные MLLM, используя механизм Смеси Глубин (MoD), где каждый слой декодера трансформера выбирает важные визуальные токены для обработки, пропуская избыточные. Однако интеграция MoD в MLLM не является тривиальной задачей. Чтобы справиться с проблемами стабильности обучения и вывода, а также ограниченными данными для обучения, мы адаптируем модуль MoD с помощью двух новых разработок: тангентально-контролируемой нормализации весов (TanhNorm) и симметричного переобучения токенов (STRing). Более того, мы наблюдаем, что визуальные токены проявляют более высокую избыточность в более глубоких слоях, и, следовательно, разрабатываем стратегию прогрессивного уменьшения соотношения (PRD), которая постепенно сокращает коэффициент удержания токенов слой за слоем, используя смещенный косинусный график. Этот ключевой дизайн полностью раскрывает потенциал MoD, значительно увеличивая эффективность и производительность наших моделей. Для проверки эффективности нашего подхода мы проводим обширные эксперименты с двумя базовыми моделями по 14 контрольным точкам. Наша модель, p-MoD, сравнивается или даже превосходит производительность базовых моделей, при этом затрачивая всего 55,6% TFLOPs и 53,8% хранения кэша KV во время вывода и 77,7% GPU-часов во время обучения.