VisionZip: Устранение избыточности визуальных токенов в моделях "визуальный-язык"

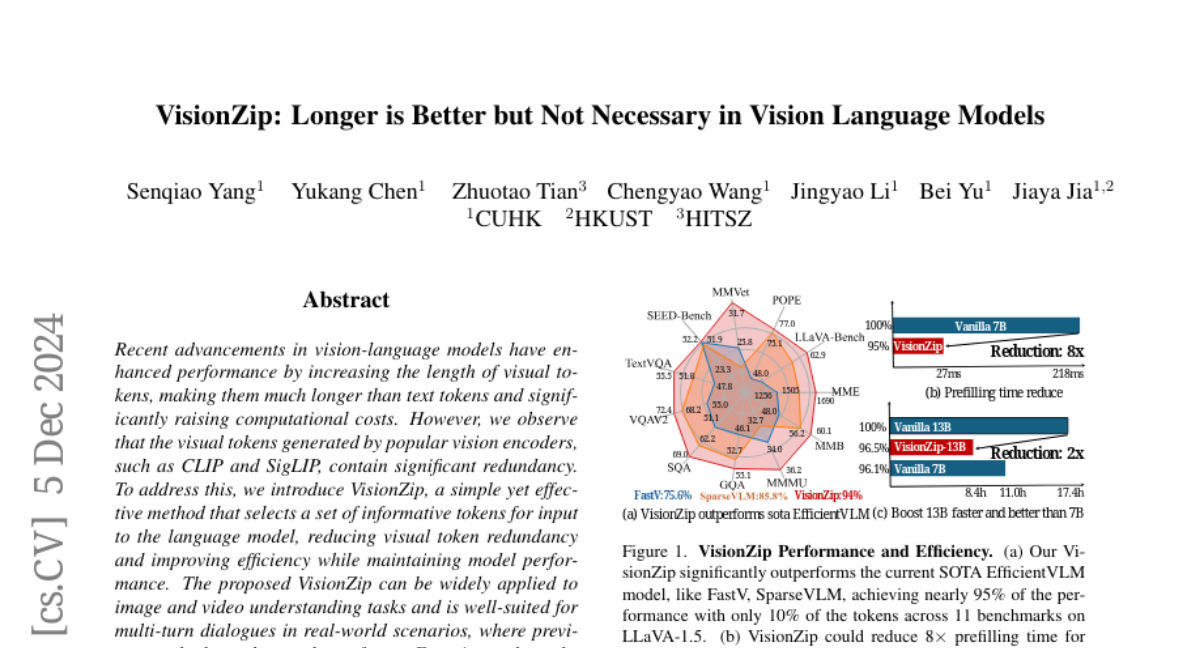

Недавние достижения в моделях связи «визуальный-язык» повысили эффективность, увеличив длину визуальных токенов, сделав их значительно длиннее текстовых токенов и значительно увеличив вычислительные затраты. Тем не менее, мы наблюдаем, что визуальные токены, созданные популярными визуальными энкодерами, такими как CLIP и SigLIP, содержат значительную избыточность. Чтобы решить эту проблему, мы представляем VisionZip, простой, но эффективный метод, который выбирает набор информативных токенов для подачи в языковую модель, уменьшая визуальную токенизаторную избыточность и улучшая эффективность при сохранении производительности модели. Предложенный VisionZip может широко применяться к задачам понимания изображений и видео и хорошо подходит для многоповоротных диалогов в реальных сценариях, где предыдущие методы, как правило, показывают низкие результаты. Экспериментальные результаты показывают, что VisionZip превосходит предыдущий самый лучший метод как минимум на 5% в производительности во всех настройках. Более того, наш метод значительно увеличивает скорость вывода модели, улучшая время предварительного заполнения в 8 раз и позволяя модели LLaVA-Next 13B выводить быстрее, чем модель LLaVA-Next 7B, при этом достигая лучших результатов. Кроме того, мы анализируем причины этой избыточности и призываем сообщество сосредоточиться на извлечении лучших визуальных признаков, а не просто на увеличении длины токенов. Наш код доступен на https://github.com/dvlab-research/VisionZip .