VisionZip: Устранение избыточности визуальных токенов в моделях "визуальный-язык"

Современные достижения в области моделей "визуальный-язык" (VLM) значительно улучшили производительность, однако увеличение длины визуальных токенов привело к значительным затратам вычислительных ресурсов. В данной статье мы рассматриваем метод VisionZip, который направлен на уменьшение избыточности визуальных токенов, сохраняя при этом эффективность и производительность моделей.

Проблема избыточности токенов

Модели VLM, такие как LLaVA и Mini-Gemini, часто используют значительно больше визуальных токенов по сравнению с текстовыми. Например, в LLaVA-1.5 используется 576 визуальных токенов, тогда как текстовых токенов всего несколько десятков. Это приводит к неэффективному использованию памяти и вычислительных ресурсов. Мы наблюдаем, что большинство визуальных токенов имеют низкую значимость, и только небольшая их часть действительно вносит значимый вклад в процесс обработки информации.

Метод VisionZip

VisionZip — это текст-агностичный метод, который позволяет эффективно выбирать информативные визуальные токены для передачи в языковую модель (LLM). Он включает в себя два основных этапа: выбор доминирующих токенов и слияние контекстуальных токенов.

Выбор доминирующих токенов

На первом этапе мы определяем токены, которые получают наибольшее внимание. Это делается путем анализа весов внимания, полученных из визуального энкодера. Токены, которые получают значительное внимание, считаются доминирующими и сохраняются для дальнейшей обработки.

Слияние контекстуальных токенов

На втором этапе мы сливаем оставшиеся токены, основываясь на их семантической схожести, чтобы сохранить мелкие, но потенциально важные детали. Это позволяет создать контекстуальные токены, которые содержат более полную информацию о визуальных данных.

Эффективная настройка

VisionZip также включает в себя этап эффективной настройки, который позволяет модели адаптироваться к уменьшенному количеству токенов. Это достигается за счет минимального обучения проекционного слоя, что позволяет улучшить согласование между визуальным и языковым пространствами.

Эффективность VisionZip

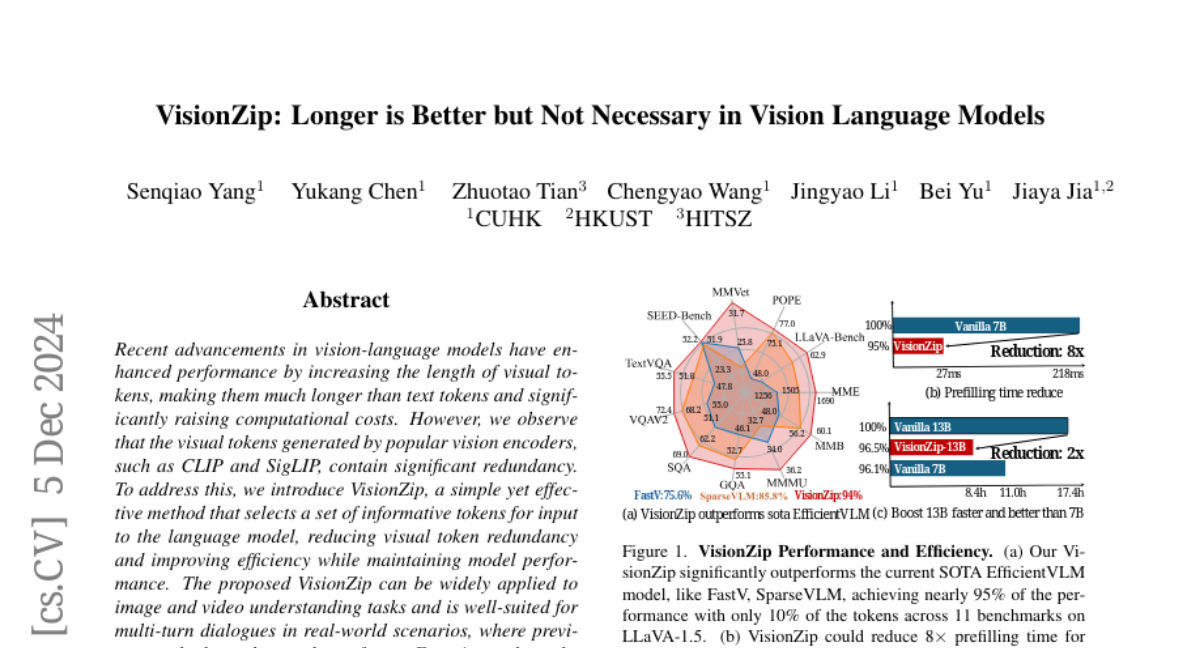

Экспериментальные результаты показывают, что VisionZip превосходит предыдущие методы по производительности и скорости вывода. Например, он может сократить время предварительной обработки на 8 раз и улучшить скорость вывода модели LLaVA-Next 13B по сравнению с моделью 7B, достигая при этом лучших результатов.

Анализ причин избыточности

Мы провели анализ, чтобы понять, почему визуальные токены обладают высокой избыточностью. Выяснили, что на более глубоких слоях внимание модели начинает сосредотачиваться на ограниченном наборе токенов, что приводит к потере информации, содержащейся в остальных токенах. Это явление также может быть связано с использованием функции softmax, которая усиливает акцент на токенах с высоким вниманием и снижает значимость остальных.

Применимость VisionZip

VisionZip можно применять не только к задачам понимания изображений, но и к видео, а также для многократных диалогов в реальных сценариях. Он является текст-агностичным, что упрощает его интеграцию с существующими алгоритмами LLM и позволяет значительно сократить время обработки и потребление памяти.

Заключение

VisionZip представляет собой простое и эффективное решение для устранения избыточности визуальных токенов в моделях VLM. Это позволяет значительно повысить вычислительную эффективность, сохраняя при этом высокую производительность моделей. Мы надеемся, что наше исследование вдохновит дальнейшие разработки в области визуальных энкодеров с меньшей избыточностью и улучшенной производительностью.