JuStRank: Оценка LLM-судей для ранжирования систем

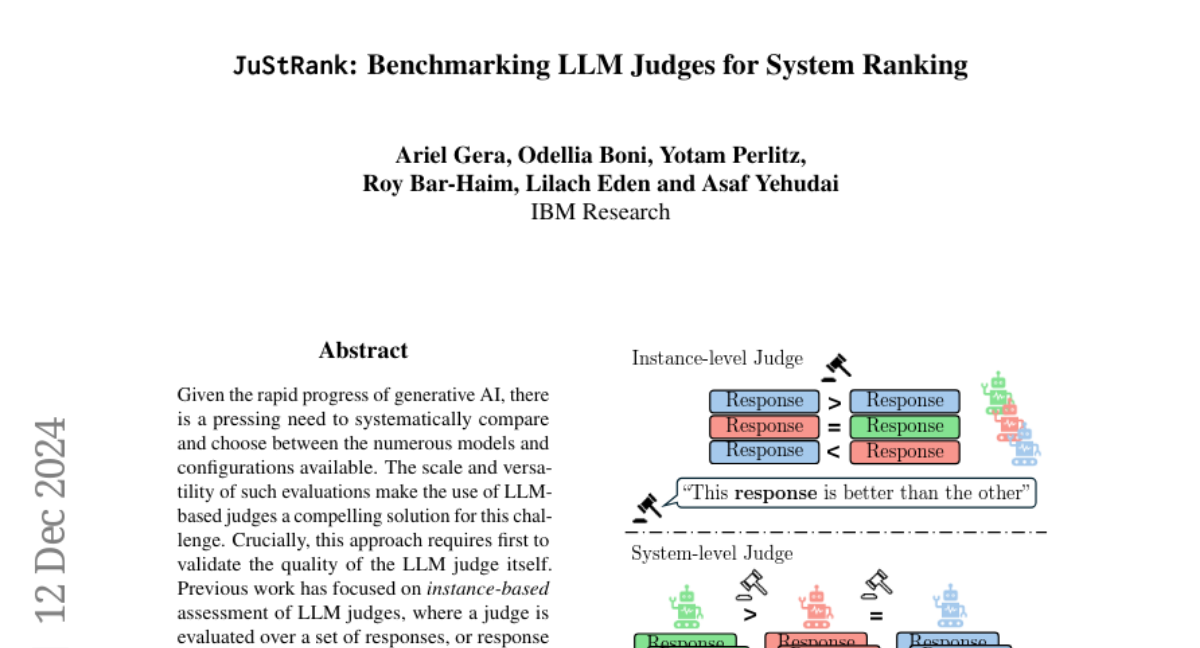

Учитывая быстрый прогресс генеративного ИИ, существует настоятельная необходимость систематически сравнивать и выбирать между многочисленными моделями и конфигурациями. Масштаб и универсальность таких оценок делают использование судей на основе больших языковых моделей (LLM) убедительным решением для этой задачи. Ключевым моментом в этом подходе является необходимость сначала проверить качество самого судьи LLM. Предыдущие работы сосредотачивались на оценке судей LLM на основе конкретных примеров, где судья оценивается по набору ответов или парам ответов, оставаясь при этом нейтральным к их исходным системам. Мы утверждаем, что эта обстановка упускает из виду критически важные факторы, влияющие на ранжирование на уровне системы, такие как положительная или отрицательная предвзятость судьи к определённым системам. Чтобы устранить этот пробел, мы проводим первое крупномасштабное исследование судей LLM в качестве ранжировщиков систем. Баллы системы генерируются путем агрегирования оценок судей по нескольким выводам системы, а качество судьи оценивается путем сравнения полученного ранжирования систем с ранжированием, основанным на мнении человека. Кроме общей оценки судьи, наш анализ предоставляет детализированную характеристику поведения судьи, включая их решительность и предвзятость.