От судейства к оценке: возможности и вызовы LLM как судьи

В последние годы искусственный интеллект (ИИ) и обработка естественного языка (NLP) значительно продвинулись вперед, но оценка и судейство остаются одними из самых сложных задач. Традиционные методы оценки, основанные на сопоставлении или встраивании, часто не справляются с тонкостями и нюансами, что приводит к неудовлетворительным результатам. Однако, с развитием крупных языковых моделей (LLM), таких как GPT-4 и другие, появился новый подход - "LLM как судья" (LLM-as-a-judge), который использует мощь этих моделей для оценки, ранжирования и выбора среди различных задач и приложений. В данной статье мы рассмотрим концепции, представленные в исследовании "From Generation to Judgment: Opportunities and Challenges of LLM-as-a-judge" авторов Dawei Li и др., предоставляя обзор этого многообещающего направления.

Оценка и судейство являются фундаментальными аспектами машинного обучения и NLP, особенно когда речь идет о сравнении различных атрибутов, таких как качество, релевантность и полезность. Традиционные метрики, такие как BLEU и ROUGE, опираются на статистические подходы к оценке качества текста, измеряя перекрытие слов между выходным текстом и эталонным текстом. Однако эти метрики часто не справляются с динамичными и открытыми сценариями, где требуется более глубокое понимание контекста и нюансов.

С появлением LLM, которые демонстрируют выдающиеся результаты в понимании инструкций, анализе запросов и генерации ответов, возникла идея использовать их для оценки и судейства. Эти модели способны анализировать текст на более высоком уровне, учитывая контекст, семантику и даже тонкости, которые обычно упускаются традиционными методами.

Определение LLM как судьи

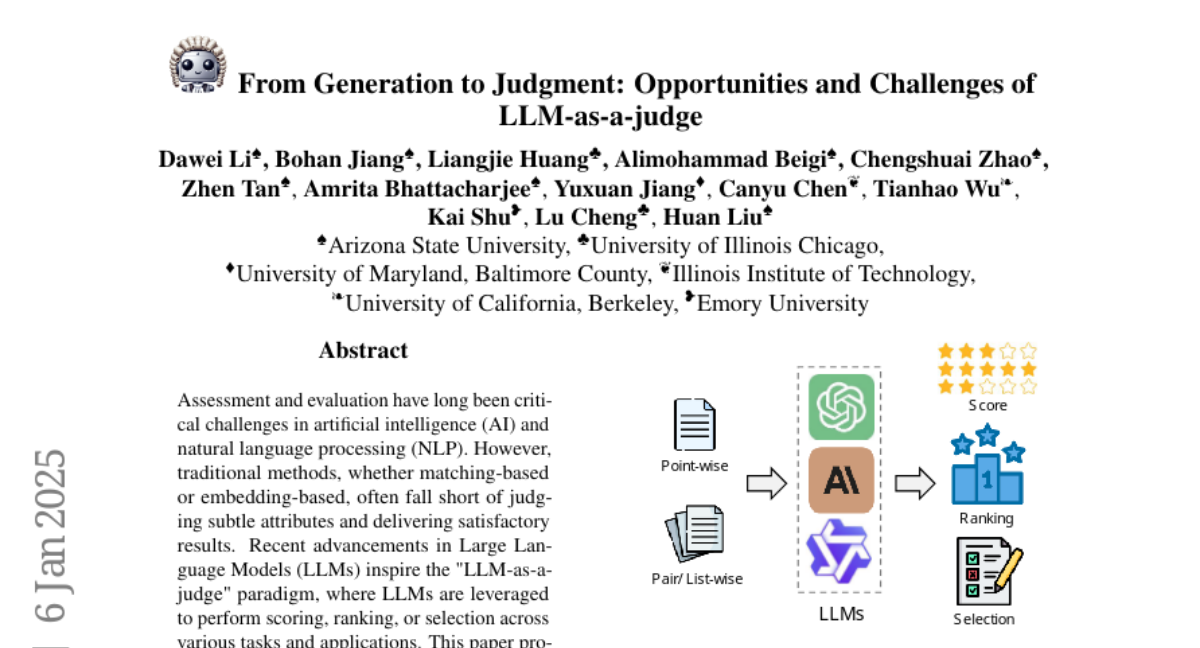

LLM как судьи могут принимать на вход один или несколько кандидатов для оценки и выдавать результат в виде оценки, ранжирования или выбора. Вот как это может выглядеть:

- Point-Wise: Когда оценивается один кандидат, LLM фокусируется на его отдельных характеристиках.

- Pair/List-Wise: Когда сравниваются два или более кандидатов, LLM проводит сравнительный анализ.

Выходные данные могут быть:

- Score: Каждому кандидату присваивается оценка.

- Ranking: Кандидаты ранжируются по определенным критериям.

- Selection: Выбирается один или несколько лучших кандидатов.

Атрибуты для оценки

LLM могут оценивать различные атрибуты:

- Полезность (Helpfulness): Оценка насколько ответ полезен для пользователя.

- Безопасность (Harmlessness): Оценка на предмет потенциального вреда или неподходящего содержания.

- Надежность (Reliability): Проверка на фактичность и точность информации.

- Релевантность (Relevance): Оценка соответствия ответа запросу.

- Выполнимость (Feasibility): Оценка возможности выполнения предложенного действия или решения.

- Общее качество: Общая оценка качества ответа.

Методы настройки и подходы

Для улучшения способностей LLM как судей используются различные методы:

Настройка

- Источники данных: Используются либо вручную размеченные данные, либо синтетическая обратная связь, генерируемая самими моделями.

- Техники настройки: Включают в себя обучение с учителем, обучение предпочтений, а также использование техник, таких как DPO (Directed Preference Optimization).

Промптинг

- Смена операций: Методы, такие как перестановка порядка кандидатов, для уменьшения позиционных предвзятостей.

- Аугментация правил: Включение принципов или правил в промпты для более точного и направленного оценивания.

- Сотрудничество мульти-агентов: Использование нескольких LLM для коллективного оценивания.

- Демонстрация: Примеры оценок для руководства LLM.

- Многоходовое взаимодействие: Динамическое взаимодействие между LLM и кандидатами для более глубокой оценки.

- Ускорение сравнения: Методы для ускорения процесса сравнения кандидатов.

Применение

LLM как судьи находят применение в различных областях:

- Оценка: От оценки открытых текстов до оценки логических рассуждений.

- Выравнивание: Использование для выравнивания моделей с человеческими предпочтениями.

- Поиск и извлечение информации: Оценка релевантности и полезности извлеченных данных.

- Рассуждение: Оценка логики и последовательности рассуждений.

Бенчмарки для оценки LLM как судей

Для оценки эффективности LLM как судей разработаны различные бенчмарки:

- Общая производительность: Оценка согласованности с человеческими суждениями.

- Квантификация предвзятости: Измерение и корректировка предвзятости в оценках.

- Специализированная производительность: Оценка в конкретных областях, таких как кодирование или медицина.

- Мультимодальная оценка: Оценка моделей, работающих с различными типами данных.

Вызовы и будущие направления

Несмотря на значительные успехи, LLM как судьи сталкиваются с рядом вызовов:

- Предвзятость и уязвимость: Модели могут проявлять различные формы предвзятости, такие как позиционная или длина ответа.

- Динамическое и сложное судейство: Необходимость в более сложных и адаптивных методах оценки.

- Самооценка: Использование LLM для оценки собственных ответов.

- Совместное судейство человек-LLM: Интеграция человеческой обратной связи для улучшения оценок.

Будущие направления исследований включают:

- Интеграция RAG: Использование моделей для извлечения и генерации информации для более точной оценки.

- Использование данных для устранения предвзятости: Создание датасетов, направленных на устранение предвзятости.

- Адаптивные методы оценки: Разработка систем, которые адаптируют сложность вопросов в зависимости от способностей кандидатов.

Заключение

Использование LLM как судей открывает новые горизонты в оценке и судействе, предоставляя более глубокое понимание контекста и нюансов, чем традиционные методы. Однако, для полной реализации этого потенциала необходимо решить ряд вызовов, связанных с предвзятостью, динамичностью оценки и интеграцией человеческого суждения. Исследования в этой области продолжаются, и будущие разработки обещают сделать LLM еще более эффективными и справедливыми судьями в мире ИИ и NLP.